Contents

猫番

Cats は Scala のための関数型プログラミングのライブラリで、これは僕がそれを使ってみた記録だ。 大まかな流れは、僕が 2012年 (!) に書いた独習 Scalaz に倣う。

Cats のサイト によると、名前は圏 (category) の遊び心のある短縮形に由来する。 プログラマの取りまとめは猫の群をまとめるようなものだと言われる。

訳注: 本稿原題の herding cats は、英語の慣用句の一つで、herd というのは何十匹もの牛や羊を追い立てて群で移動させること。 猫は集団行動ができないので、言うことを聞かずにてんでんばらばらな状態、またはそれをまとめようとする様。

少なくとも Scala を使ってるプログラマに関しては当てはまるのではないかと思う。 この状況を十分承知した上で、Cats は第一の動機として「とっつき易さ」をあげている。

Cats は技術的な視点からみても面白そうだ。 とっつき易さのせいか、Erik Asheim (@d6/@non) の凄さか、 色々人が集まってきて新しいアイディアを持ち込んでいる。 例えば、Michael Pilquist (@mpilquist) 氏の simulacrum や Miles Sabin (@milessabin) 氏の型クラスの自動導出などが例だ。 これから、色々学んでいきたい。

0日目

これは、僕が Scalaz を独習したログをもとに Cats をいじってみたログだ。 チュートリアルと一部では呼ばれているが、走り書きで書かれたトラベルログだと思って読んだほうがいい。 つまり、実際にここで書かれたことを学びたければ、本を読んだり、自分で例題を解く他に近道は無い。

いきなり詳細に飛び込む代わりに、前編として導入から始めたいと思う。

Cats 入門

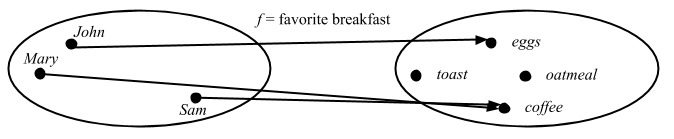

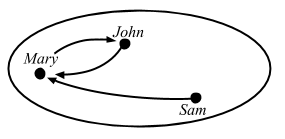

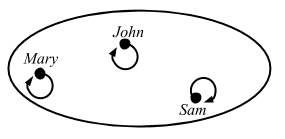

Nick Partridge さんが Melbourne Scala Users Group で 2010年3月22日に行った Scalaz のトークをネタとして借用する:

Scalaz talk is up - http://bit.ly/c2eTVR Lots of code showing how/why the library exists

— Nick Partridge (@nkpart) March 28, 2010

Cats は、主に 2つの部分から構成される:

- 新しいデータ型 (

Validated,State, etc) - 実用上必要な多くの汎用関数の実装 (アドホック多相性、trait + implicit)

多相性って何?

パラメータ多相 (parametric polymorphism)

Nick さん曰く:

この関数

headはAのリストを取ってAを返します。Aが何であるかはかまいません。Intでもいいし、Stringでもいいし、OrangeでもCarでもいいです。どのAでも動作し、存在可能な全てのAに対してこの関数は定義されています。

def head[A](xs: List[A]): A = xs(0)

head(1 :: 2 :: Nil)

// res1: Int = 1

case class Car(make: String)

head(Car("Civic") :: Car("CR-V") :: Nil)

// res2: Car = Car(make = "Civic")

Haskell wiki 曰く:

パラメータ多相 (parametric polymorphism) とは、ある値の型が 1つもしくは複数の (制限の無い) 型変数を含むことを指し、その値は型変数を具象型によって置換することによって得られる型ならどれでも採用することができる。

派生型による多態 (subtype polymorphism)

ここで、型 A の 2つの値を足す plus という関数を考える:

def plus[A](a1: A, a2: A): A = ???

型 A によって、足すことの定義を別々に提供する必要がある。これを実現する方法の一つが派生型 (subtyping) だ。

trait PlusIntf[A] {

def plus(a2: A): A

}

def plusBySubtype[A <: PlusIntf[A]](a1: A, a2: A): A = a1.plus(a2)

これで A の型によって異なる plus の定義を提供できるようにはなった。しかし、この方法はデータ型の定義時に Plus を mixin する必要があるため柔軟性に欠ける。例えば、Int や String には使うことができない。

アドホック多相

Scala における3つ目の方法は trait への暗黙の変換か暗黙のパラメータ (implicit parameter) を使うことだ。

trait CanPlus[A] {

def plus(a1: A, a2: A): A

}

def plus[A: CanPlus](a1: A, a2: A): A = implicitly[CanPlus[A]].plus(a1, a2)

これは以下の意味においてまさにアドホックだと言える

- 異なる

Aの型に対して別の関数定義を提供することができる - (

Intのような) 型に対してソースコードへのアクセスが無くても関数定義を提供することができる - 異なるスコープにおいて関数定義を有効化したり無効化したりできる

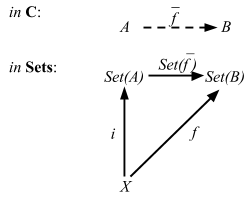

この最後の点によって Scala のアドホック多相性は Haskell のそれよりもより強力なものだと言える。このトピックに関しては Debasish Ghosh さん (@debasishg) のScala Implicits: 型クラス、襲来参照。

この plus 関数をより詳しく見ていこう。

sum 関数

アドホック多相の具体例として、Int のリストを合計する簡単な関数 sum を徐々に一般化していく。

def sum(xs: List[Int]): Int = xs.foldLeft(0) { _ + _ }

sum(List(1, 2, 3, 4))

// res0: Int = 10

Monoid

これを少し一般化してみましょう。

Monoidというものを取り出します。… これは、同じ型の値を生成するmappendという関数と「ゼロ」を生成する関数を含む型です。

object IntMonoid {

def mappend(a: Int, b: Int): Int = a + b

def mzero: Int = 0

}

これを代入することで、少し一般化されました。

def sum(xs: List[Int]): Int = xs.foldLeft(IntMonoid.mzero)(IntMonoid.mappend)

sum(List(1, 2, 3, 4))

// res2: Int = 10

次に、全ての型

AについてMonoidが定義できるように、Monoidを抽象化します。これでIntMonoidがIntのモノイドになりました。

trait Monoid[A] {

def mappend(a1: A, a2: A): A

def mzero: A

}

object IntMonoid extends Monoid[Int] {

def mappend(a: Int, b: Int): Int = a + b

def mzero: Int = 0

}

これで sum が Int のリストと Int のモノイドを受け取って合計を計算できるようになった:

def sum(xs: List[Int], m: Monoid[Int]): Int = xs.foldLeft(m.mzero)(m.mappend)

sum(List(1, 2, 3, 4), IntMonoid)

// res4: Int = 10

これで

Intを使わなくなったので、全てのIntを一般型に置き換えることができます。

def sum[A](xs: List[A], m: Monoid[A]): A = xs.foldLeft(m.mzero)(m.mappend)

sum(List(1, 2, 3, 4), IntMonoid)

// res6: Int = 10

最後の変更点は

Monoidを implicit にすることで毎回渡さなくてもいいようにすることです。

def sum[A](xs: List[A])(implicit m: Monoid[A]): A = xs.foldLeft(m.mzero)(m.mappend)

{

implicit val intMonoid = IntMonoid

sum(List(1, 2, 3, 4))

}

// res8: Int = 10

Nick さんはやらなかったけど、この形の暗黙のパラメータは context bound で書かれることが多い:

def sum[A: Monoid](xs: List[A]): A = {

val m = implicitly[Monoid[A]]

xs.foldLeft(m.mzero)(m.mappend)

}

{

implicit val intMonoid = IntMonoid

sum(List(1, 2, 3, 4))

}

// res10: Int = 10

これでどのモノイドのリストでも合計できるようになり、

sum関数はかなり一般化されました。StringのMonoidを書くことでこれをテストすることができます。また、これらはMonoidという名前のオブジェクトに包むことにします。その理由は Scala の implicit 解決ルールです。ある型の暗黙のパラメータを探すとき、Scala はスコープ内を探しますが、それには探している型のコンパニオンオブジェクトも含まれるのです。

trait Monoid[A] {

def mappend(a1: A, a2: A): A

def mzero: A

}

object Monoid {

implicit val IntMonoid: Monoid[Int] = new Monoid[Int] {

def mappend(a: Int, b: Int): Int = a + b

def mzero: Int = 0

}

implicit val StringMonoid: Monoid[String] = new Monoid[String] {

def mappend(a: String, b: String): String = a + b

def mzero: String = ""

}

}

def sum[A: Monoid](xs: List[A]): A = {

val m = implicitly[Monoid[A]]

xs.foldLeft(m.mzero)(m.mappend)

}

sum(List("a", "b", "c"))

// res12: String = "abc"

この関数に直接異なるモノイドを渡すこともできます。例えば、

Intの積算のモノイドのインスタンスを提供してみましょう。

val multiMonoid: Monoid[Int] = new Monoid[Int] {

def mappend(a: Int, b: Int): Int = a * b

def mzero: Int = 1

}

// multiMonoid: Monoid[Int] = repl.MdocSession3@6082c022

sum(List(1, 2, 3, 4))(multiMonoid)

// res13: Int = 24

FoldLeft

Listに関しても一般化した関数を目指しましょう。… そのためには、foldLeft演算に関して一般化します。

object FoldLeftList {

def foldLeft[A, B](xs: List[A], b: B, f: (B, A) => B) = xs.foldLeft(b)(f)

}

def sum[A: Monoid](xs: List[A]): A = {

val m = implicitly[Monoid[A]]

FoldLeftList.foldLeft(xs, m.mzero, m.mappend)

}

sum(List(1, 2, 3, 4))

// res1: Int = 10

sum(List("a", "b", "c"))

// res2: String = "abc"

sum(List(1, 2, 3, 4))(multiMonoid)

// res3: Int = 24

これで先ほどと同様の抽象化を行なって

FoldLeft型クラスを抜き出します。

trait FoldLeft[F[_]] {

def foldLeft[A, B](xs: F[A], b: B, f: (B, A) => B): B

}

object FoldLeft {

implicit val FoldLeftList: FoldLeft[List] = new FoldLeft[List] {

def foldLeft[A, B](xs: List[A], b: B, f: (B, A) => B) = xs.foldLeft(b)(f)

}

}

def sum[M[_]: FoldLeft, A: Monoid](xs: M[A]): A = {

val m = implicitly[Monoid[A]]

val fl = implicitly[FoldLeft[M]]

fl.foldLeft(xs, m.mzero, m.mappend)

}

sum(List(1, 2, 3, 4))

// res5: Int = 10

sum(List("a", "b", "c"))

// res6: String = "abc"

これで Int と List の両方が sum から抜き出された。

Cats の型クラス

上の例における trait の Monoid と FoldLeft は Haskell の型クラスに相当する。Cats は多くの型クラスを提供する。

これらの型クラスの全ては必要な関数だけを含んだ部品に分けられています。ある関数が必要十分なものだけを要請するため究極のダック・タイピングだと言うこともできるでしょう。

メソッド注入 (enrich my library)

Monoidを使ってある型の 2つの値を足す関数を書いた場合、このようになります。

def plus[A: Monoid](a: A, b: A): A = implicitly[Monoid[A]].mappend(a, b)

plus(3, 4)

// res0: Int = 7

これに演算子を提供したい。だけど、1つの型だけを拡張するんじゃなくて、Monoid のインスタンスを持つ全ての型を拡張したい。

Simulacrum を用いて Cats スタイルでこれを行なってみる。

trait Monoid[A] {

def mappend(a: A, b: A): A

def mzero: A

}

object Monoid {

object syntax extends MonoidSyntax

implicit val IntMonoid: Monoid[Int] = new Monoid[Int] {

def mappend(a: Int, b: Int): Int = a + b

def mzero: Int = 0

}

implicit val StringMonoid: Monoid[String] = new Monoid[String] {

def mappend(a: String, b: String): String = a + b

def mzero: String = ""

}

}

trait MonoidSyntax {

implicit final def syntaxMonoid[A: Monoid](a: A): MonoidOps[A] =

new MonoidOps[A](a)

}

final class MonoidOps[A: Monoid](lhs: A) {

def |+|(rhs: A): A = implicitly[Monoid[A]].mappend(lhs, rhs)

}

import Monoid.syntax._

3 |+| 4

// res2: Int = 7

"a" |+| "b"

// res3: String = "ab"

1つの定義から Int と String の両方に |+| 演算子を注入することができた。

標準データ型に対する演算子構文

このテクニックを使って、Cats はごくたまに Option のような標準ライブラリデータ型へのメソッド注入も提供する:

import cats._, cats.syntax.all._

1.some

// res5: Option[Int] = Some(value = 1)

1.some.orEmpty

// res6: Int = 1

しかし、Cats の演算子の大半は型クラスに関連付けられている。

これで Cats の雰囲気がつかめてもらえただろうか。

1 日目

型クラス初級講座

型クラスは、何らかの振る舞いを定義するインターフェイスです。ある型クラスのインスタンスである型は、その型クラスが記述する振る舞いを実装します。

Cats 曰く:

We are trying to make the library modular. It will have a tight core which will contain only the typeclasses and the bare minimum of data structures that are needed to support them. Support for using these typeclasses with the Scala standard library will be in the

stdproject.

ライブラリはモジュラーなものにしたいと思っている。これは、型クラスとそれらを補助する必要最低限のデータ構造だけを含んだタイトなコアを持つ予定だ。これらの型クラスを Scala 標準ライブラリと併用するためのサポートは

stdプロジェクトになる。

Haskell をたのしく学ぶ路線で取りあえず行ってみる。

sbt

Cats を使ってみるための build.sbt はこんな感じになる:

val catsVersion = "2.4.2"

val catsCore = "org.typelevel" %% "cats-core" % catsVersion

val catsFree = "org.typelevel" %% "cats-free" % catsVersion

val catsLaws = "org.typelevel" %% "cats-laws" % catsVersion

val catsMtl = "org.typelevel" %% "cats-mtl-core" % "0.7.1"

val simulacrum = "org.typelevel" %% "simulacrum" % "1.0.1"

val kindProjector = compilerPlugin("org.typelevel" % "kind-projector" % "0.11.3" cross CrossVersion.full)

val resetAllAttrs = "org.scalamacros" %% "resetallattrs" % "1.0.0"

val munit = "org.scalameta" %% "munit" % "0.7.22"

val disciplineMunit = "org.typelevel" %% "discipline-munit" % "1.0.6"

ThisBuild / scalaVersion := "2.13.5"

lazy val root = (project in file("."))

.settings(

organization := "com.example",

name := "something",

libraryDependencies ++= Seq(

catsCore,

catsFree,

catsMtl,

simulacrum,

kindProjector,

resetAllAttrs,

catsLaws % Test,

munit % Test,

disciplineMunit % Test,

),

scalacOptions ++= Seq(

"-deprecation",

"-encoding", "UTF-8",

"-feature",

"-language:_"

)

)

sbt 1.4.9 を用いて REPL を開く:

$ sbt

> console

[info] Starting scala interpreter...

Welcome to Scala 2.13.5 (OpenJDK 64-Bit Server VM, Java 1.8.0_232).

Type in expressions for evaluation. Or try :help.

scala>

Cats の API ドキュメント もある。

Eq

LYAHFGG:

Eqは等値性をテストできる型に使われます。Eq のインスタンスが定義すべき関数は==と/=です。

Cats で Eq 型クラスと同じものも Eq と呼ばれている。

Eq は non/algebra から cats-kernel というサブプロジェクトに移行して、Cats の一部になった:

import cats._, cats.syntax.all._

1 === 1

// res0: Boolean = true

1 === "foo"

// error: type mismatch;

// found : String("foo")

// required: Int

// 1 === "foo"

// ^^^^^

(Some(1): Option[Int]) =!= (Some(2): Option[Int])

// res2: Boolean = true

標準の == のかわりに、Eq は === と =!= 演算を可能とする。主な違いは Int と String と比較すると === はコンパイルに失敗することだ。

algebra では neqv は eqv に基いて実装されている。

/**

* A type class used to determine equality between 2 instances of the same

* type. Any 2 instances `x` and `y` are equal if `eqv(x, y)` is `true`.

* Moreover, `eqv` should form an equivalence relation.

*/

trait Eq[@sp A] extends Any with Serializable { self =>

/**

* Returns `true` if `x` and `y` are equivalent, `false` otherwise.

*/

def eqv(x: A, y: A): Boolean

/**

* Returns `false` if `x` and `y` are equivalent, `true` otherwise.

*/

def neqv(x: A, y: A): Boolean = !eqv(x, y)

....

}

これは多相性 (polymorphism) の例だ。型の A にとって等価性が何を意味しようと、

neqv はその逆だと定義されている。それが String でも Int でも変わらない。

別の言い方をすれば、Eq[A] が与えられたとき、=== は普遍的に =!= の逆だ。

気になるのが、Eq では等価 (equal) と同値 (equivalent) を同じように使っているフシがあることだ。

同値関係は例えば、「同じ誕生日を持つ」関係も含むのに対して、

等価性は代入原理を要請する。

Order

LYAHFGG:

Ordは、何らかの順序を付けられる型のための型クラスです。Ordはすべての標準的な大小比較関数、>、<、>=、<=をサポートします。

Cats で Ord に対応する型クラスは Order だ。

// plain Scala

1 > 2.0

// res0: Boolean = false

import cats._, cats.syntax.all._

1 compare 2.0

// error: type mismatch;

// found : Double(2.0)

// required: Int

// 1.0 compare 2.0

// ^^^

import cats._, cats.syntax.all._

1.0 compare 2.0

// res2: Int = -1

1.0 max 2.0

// res3: Double = 2.0

Order は Int (負、ゼロ、正) を返す compare 演算を可能とする。

また、minx と max 演算子も可能とする。

Eq 同様、Int と Double の比較はコンパイルを失敗させる。

PartialOrder

Order の他に、Cats は PartialOrder も定義する。

import cats._, cats.data._, cats.implicits._

1 tryCompare 2

// res0: Option[Int] = Some(value = -1)

1.0 tryCompare Double.NaN

// res1: Option[Int] = Some(value = -1)

PartialOrder は Option[Int] を返す tryCompare 演算を可能とする。

algebra によると、オペランドが比較不能な場合は None を返すとのことだ。

だけど、1.0 と Double.NaN を比較しても Some(-1) を返しているので、何が比較不能なのかは不明だ。

def lt[A: PartialOrder](a1: A, a2: A): Boolean = a1 <= a2

lt(1, 2)

// res2: Boolean = true

lt[Int](1, 2.0)

// error: type mismatch;

// found : Double(2.0)

// required: Int

// lt[Int](1, 2.0)

// ^^^

PartialOrder は他にも >, >=, <, そして <=

演算子を可能とするが、これらは気をつけないと標準の比較演算子を使うことになるのでトリッキーだ。

Show

LYAHFGG:

ある値は、その値が

Show型クラスのインスタンスになっていれば、文字列として表現できます。

Cats で Show に対応する型クラスは Show だ:

import cats._, cats.syntax.all._

3.show

// res0: String = "3"

"hello".show

// res1: String = "hello"

これが型クラスのコントラクトだ:

@typeclass trait Show[T] {

def show(f: T): String

}

Scala には既に Any に toString があるため、Show

を定義するのは馬鹿げているように一見見えるかもしれない。

Any ということは逆に何でも該当してしまうので、型安全性を失うことになる。

toString は何らかの親クラスが書いたゴミかもしれない:

(new {}).toString

// res2: String = "repl.MdocSession1@b3c274f"

(new {}).show

// error: value show is not a member of AnyRef

// (new {}).show

// ^^^^^^^^^^^^

object Show は Show のインスタンスを作成するための 2つの関数を提供する:

object Show {

/** creates an instance of [[Show]] using the provided function */

def show[A](f: A => String): Show[A] = new Show[A] {

def show(a: A): String = f(a)

}

/** creates an instance of [[Show]] using object toString */

def fromToString[A]: Show[A] = new Show[A] {

def show(a: A): String = a.toString

}

implicit val catsContravariantForShow: Contravariant[Show] = new Contravariant[Show] {

def contramap[A, B](fa: Show[A])(f: B => A): Show[B] =

show[B](fa.show _ compose f)

}

}

使ってみる:

case class Person(name: String)

case class Car(model: String)

{

implicit val personShow = Show.show[Person](_.name)

Person("Alice").show

}

// res4: String = "Alice"

{

implicit val carShow = Show.fromToString[Car]

Car("CR-V")

}

// res5: Car = Car(model = "CR-V")

Read

LYAHFGG:

ReadはShowと対をなす型クラスです。read関数は文字列を受け取り、Readのインスタンスの型の値を返します。

これは対応する Cats での型クラスを見つけることができなかった。

個人的には Read とその変種である ReadJs をしばしば定義している。

stringly typed programming (strongly typed をもじった造語で、データ構造の代わりに String を使ったコード)

は醜いものだ。

しかし、同時に文字列はプラットフォームの境界に対して堅固なデータ・フォーマットであり (例、 JSON)、

また人が直接扱うことができる (例、コマンドラインオプション)。

そのため、文字列パーシングを避けるのは難しいだろう。

どうしてもやらなければならないのならば、Read はそれを楽にする。

Enum

LYAHFGG:

Enumのインスタンスは、順番に並んだ型、つまり要素の値を列挙できる型です。Enum型クラスの主な利点は、その値をレンジの中で使えることです。また、Enumのインスタンスの型には後者関数succと前者関数predも定義されます。

これは対応する Cats での型クラスを見つけることができなかった。

これは、Enum でも範囲でもないが、non/spire には Interval と呼ばれる面白いデータ構造がある。

nescala 2015 での Erik のトーク、Intervals: Unifying Uncertainty, Ranges, and Loops を見てほしい。

Numeric

LYAHFGG:

Numは数の型クラスです。このインスタンスは数のように振る舞います。

これは対応する Cats での型クラスを見つけることができなかったが、

spire は Numeric を定義する。Cats は、Bounds も定義しない。

これまで、色々と Cats では定義されていない型クラスをみていきた。 Cats の設計目標としてタイトなコアを作ることにあるため、これは必ずしも悪いことではない。

型クラス中級講座

Haskell の文法に関しては飛ばして第8章の型や型クラスを自分で作ろう まで行こう (本を持っている人は第7章)。

信号の型クラス

data TrafficLight = Red | Yellow | Green

これを Scala で書くと:

import cats._, cats.syntax.all._

sealed trait TrafficLight

object TrafficLight {

case object Red extends TrafficLight

case object Yellow extends TrafficLight

case object Green extends TrafficLight

}

これに Eq のインスタンスを定義する。

implicit val trafficLightEq: Eq[TrafficLight] =

new Eq[TrafficLight] {

def eqv(a1: TrafficLight, a2: TrafficLight): Boolean = a1 == a2

}

// trafficLightEq: Eq[TrafficLight] = repl.MdocSession1@7eb2adb6

注意: 最新の algebra.Equal には Equal.instance と Equal.fromUniversalEquals も定義されている。

Eq を使えるかな?

TrafficLight.Red === TrafficLight.Yellow

// error: value === is not a member of object repl.MdocSession.App.TrafficLight.Red

// TrafficLight.red === TrafficLight.yellow

// ^^^^^^^^^^^^^^^^^^^^

Eq が不変 (invariant) なサブタイプ Eq[A] を持つせいで、Eq[TrafficLight] が検知されないみたいだ。

この問題を回避する方法としては、TrafficLight にキャストするヘルパー関数を定義するという方法がある:

import cats._, cats.syntax.all._

sealed trait TrafficLight

object TrafficLight {

def red: TrafficLight = Red

def yellow: TrafficLight = Yellow

def green: TrafficLight = Green

case object Red extends TrafficLight

case object Yellow extends TrafficLight

case object Green extends TrafficLight

}

{

implicit val trafficLightEq: Eq[TrafficLight] =

new Eq[TrafficLight] {

def eqv(a1: TrafficLight, a2: TrafficLight): Boolean = a1 == a2

}

TrafficLight.red === TrafficLight.yellow

}

// res2: Boolean = false

ちょっと冗長だけども、一応動いた。

2日目

昨日はすごいHaskellたのしく学ぼう を頼りに Eq などの

Cats の型クラスを見てきた。

simulacrum を用いた独自型クラスの定義

LYAHFGG:

JavaScript をはじめ、いくつかの弱く型付けされた言語では、

if式の中にほとんど何でも書くことができます。…. 真理値の意味論が必要なところでは厳密にBool型を使うのが Haskell の流儀ですが、 JavaScript 的な振る舞いを実装してみるのも面白そうですよね!

Scala でモジュラーな型クラスを定義するための従来のステップは以下のうようになっていた:

- 型クラス・コントラクト trait である

Fooを定義する。 - 同名のコンパニオン・オブジェクト

Fooを定義して、implicitlyのように振る舞うapplyや、関数からFooのインスタンスを定義するためのヘルパーメソッドを定義する。 FooOpsクラスを定義して、一項演算子や二項演算子を定義する。FooのインスタンスからFooOpsを implicit に提供するFooSyntaxtrait を定義する。

正直言って、最初のもの以外はほとんどコピーペーストするだけのボイラープレートだ。

ここで登場するのが、Michael Pilquist (@mpilquist) 氏の

simulacrum (シミュラクラム) だ。

@typeclass アノテーションを書くだけで、simulacrum は魔法のように上記の 2-4 をほぼ生成してくれる。

丁度、Cats を全面的に simulacrum化させた Stew O’Connor (@stewoconnor/@stew) 氏の #294

が先日 merge されたばかりだ。

Yes と No の型クラス

とりあえず、truthy 値の型クラスを作れるか試してみよう。

@typeclass アノテーションに注意:

scala> import simulacrum._

scala> :paste

@typeclass trait CanTruthy[A] { self =>

/** Return true, if `a` is truthy. */

def truthy(a: A): Boolean

}

object CanTruthy {

def fromTruthy[A](f: A => Boolean): CanTruthy[A] = new CanTruthy[A] {

def truthy(a: A): Boolean = f(a)

}

}

README によると、マクロによって演算子の enrich 関連コードが色々と生成される:

// これは、生成されたであろうコードの予想。自分で書く必要は無い!

object CanTruthy {

def fromTruthy[A](f: A => Boolean): CanTruthy[A] = new CanTruthy[A] {

def truthy(a: A): Boolean = f(a)

}

def apply[A](implicit instance: CanTruthy[A]): CanTruthy[A] = instance

trait Ops[A] {

def typeClassInstance: CanTruthy[A]

def self: A

def truthy: A = typeClassInstance.truthy(self)

}

trait ToCanTruthyOps {

implicit def toCanTruthyOps[A](target: A)(implicit tc: CanTruthy[A]): Ops[A] = new Ops[A] {

val self = target

val typeClassInstance = tc

}

}

trait AllOps[A] extends Ops[A] {

def typeClassInstance: CanTruthy[A]

}

object ops {

implicit def toAllCanTruthyOps[A](target: A)(implicit tc: CanTruthy[A]): AllOps[A] = new AllOps[A] {

val self = target

val typeClassInstance = tc

}

}

}

ちゃんと動くか確かめるために、Int のインスタンスを定義して、使ってみよう。ゴールは 1.truthy が true を返すことだ:

scala> implicit val intCanTruthy: CanTruthy[Int] = CanTruthy.fromTruthy({

case 0 => false

case _ => true

})

scala> import CanTruthy.ops._

scala> 10.truthy

動いた。これは、かなり便利だ。

ただ一点警告があって、それはコンパイル時にマクロパラダイス・プラグインが必要なことだ。CanTruthy

が一度コンパイルされてしまえば、呼び出す側はマクロパラダイスはいらない。

シンボルを使った演算子

CanTruthy に関しては、注入された演算子は一項演算子で、かつ型クラス・コントラクトの関数と同名のものだった。

simulacrum は @op アノテーションを使うことで、シンボルを使った演算子も定義することができる:

scala> @typeclass trait CanAppend[A] {

@op("|+|") def append(a1: A, a2: A): A

}

scala> implicit val intCanAppend: CanAppend[Int] = new CanAppend[Int] {

def append(a1: Int, a2: Int): Int = a1 + a2

}

scala> import CanAppend.ops._

scala> 1 |+| 2

Functor

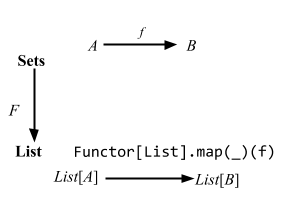

LYAHFGG:

今度は、

Functor(ファンクター)という型クラスを見ていきたいと思います。Functorは、全体を写せる (map over) ものの型クラスです。

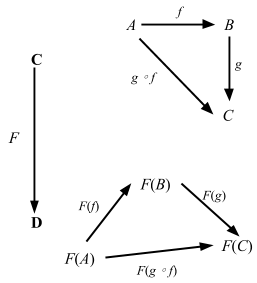

本のとおり、実装がどうなってるかをみてみよう:

/**

* Functor.

*

* The name is short for "covariant functor".

*

* Must obey the laws defined in cats.laws.FunctorLaws.

*/

@typeclass trait Functor[F[_]] extends functor.Invariant[F] { self =>

def map[A, B](fa: F[A])(f: A => B): F[B]

....

}

このように使うことができる:

import cats._, cats.syntax.all._

Functor[List].map(List(1, 2, 3)) { _ + 1 }

// res0: List[Int] = List(2, 3, 4)

このような用例は関数構文と呼ぶことにする:

@typeclass アノテーションによって自動的に map 関数が map

演算子になることは分かると思う。 fa の所がメソッドの this になって、第2パラメータリストが、

map 演算子のパラメータリストとなる:

// 生成されるコードの予想

object Functor {

trait Ops[F[_], A] {

def typeClassInstance: Functor[F]

def self: F[A]

def map[B](f: A => B): F[B] = typeClassInstance.map(self)(f)

}

}

これは、Scala collection ライブラリの map とかなり近いものに見えるが、

この map は CanBuildFrom の自動変換を行わない。

ファンクターとしての Either

Cats は Either[A, B] の Functor インスタンスを定義する。

(Right(1): Either[String, Int]) map { _ + 1 }

// res1: Either[String, Int] = Right(value = 2)

(Left("boom!"): Either[String, Int]) map { _ + 1 }

// res2: Either[String, Int] = Left(value = "boom!")

上のデモが正しく動作するのは現在の所 Either[A, B] には標準ライブラリでは

map を実装してないということに依存していることに注意してほしい。

例えば、List(1, 2, 3) を例に使った場合は、

Functor[List] の map ではなくて、

リストの実装の map が呼び出されてしまう。

そのため、演算子構文の方が読み慣れていると思うけど、

標準ライブラリが map を実装していないことを確信しているか、

多相関数内で使うか以外は演算子構文は避けた方がいい。

回避策としては関数構文を使うことだ。

ファンクターとしての関数

Cats は Function1 に対する Functor のインスタンスも定義する。

{

val addOne: Int => Int = (x: Int) => x + 1

val h: Int => Int = addOne map {_ * 7}

h(3)

}

// res3: Int = 28

これは興味深い。つまり、map は関数を合成する方法を与えてくれるが、順番が f compose g とは逆順だ。通りで Scalaz は map のエイリアスとして ∘ を提供するわけだ。Function1 のもう1つのとらえ方は、定義域 (domain) から値域 (range) への無限の写像だと考えることができる。入出力に関しては飛ばして Functors, Applicative Functors and Monoids へ行こう (本だと、「ファンクターからアプリカティブファンクターへ」)。

ファンクターとしての関数 …

ならば、型

fmap :: (a -> b) -> (r -> a) -> (r -> b)が意味するものとは?この型は、aからbへの関数と、rからaへの関数を引数に受け取り、rからbへの関数を返す、と読めます。何か思い出しませんか?そう!関数合成です!

あ、すごい Haskell も僕がさっき言ったように関数合成をしているという結論になったみたいだ。ちょっと待てよ。

ghci> fmap (*3) (+100) 1

303

ghci> (*3) . (+100) $ 1

303

Haskell では fmap は f compose g を同じ順序で動作してるみたいだ。Scala でも同じ数字を使って確かめてみる:

(((_: Int) * 3) map {_ + 100}) (1)

// res4: Int = 103

何かがおかしい。fmap の宣言と Cats の map 関数を比べてみよう:

fmap :: (a -> b) -> f a -> f b

そしてこれが Cats:

def map[A, B](fa: F[A])(f: A => B): F[B]

順番が逆になっている。これに関して Paolo Giarrusso (@blaisorblade) 氏が説明してくれた:

これはよくある Haskell 対 Scala の差異だ。

Haskell では、point-free プログラミングをするために、「データ」の引数が通常最後に来る。例えば、

map f listという引数順を利用してmap f . map g . map hと書くことでリストの変換子を得ることができる。 (ちなみに、map は fmap を List ファンクターに限定させたものだ)一方 Scala では、「データ」引数はレシーバとなる。 これは、しばしば型推論にとっても重要であるため、map を関数のメソッドとして定義するのは無理がある。 Scala が

(x => x + 1) map List(1, 2, 3)の型推論を行おうとするのを考えてみてほしい。

これが、どうやら有力な説みたいだ。

関数の持ち上げ

LYAHFGG:

fmapも、関数とファンクター値を取ってファンクター値を返す 2 引数関数と思えますが、そうじゃなくて、関数を取って「元の関数に似てるけどファンクター値を取ってファンクター値を返す関数」を返す関数だと思うこともできます。fmapは、関数a -> bを取って、関数f a -> f bを返すのです。こういう操作を、関数の持ち上げ (lifting) といいます。

ghci> :t fmap (*2)

fmap (*2) :: (Num a, Functor f) => f a -> f a

ghci> :t fmap (replicate 3)

fmap (replicate 3) :: (Functor f) => f a -> f [a]

パラメータ順が逆だということは、この持ち上げ (lifting) ができないということだろうか?

幸いなことに、Cats は Functor 型クラス内に派生関数を色々実装している:

@typeclass trait Functor[F[_]] extends functor.Invariant[F] { self =>

def map[A, B](fa: F[A])(f: A => B): F[B]

....

// derived methods

/**

* Lift a function f to operate on Functors

*/

def lift[A, B](f: A => B): F[A] => F[B] = map(_)(f)

/**

* Empty the fa of the values, preserving the structure

*/

def void[A](fa: F[A]): F[Unit] = map(fa)(_ => ())

/**

* Tuple the values in fa with the result of applying a function

* with the value

*/

def fproduct[A, B](fa: F[A])(f: A => B): F[(A, B)] = map(fa)(a => a -> f(a))

/**

* Replaces the `A` value in `F[A]` with the supplied value.

*/

def as[A, B](fa: F[A], b: B): F[B] = map(fa)(_ => b)

}

見ての通り、lift も入っている!

{

val lifted = Functor[List].lift {(_: Int) * 2}

lifted(List(1, 2, 3))

}

// res5: List[Int] = List(2, 4, 6)

これで {(_: Int) * 2} という関数を List[Int] => List[Int] に持ち上げることができた。

他の派生関数も演算子構文で使ってみる:

List(1, 2, 3).void

// res6: List[Unit] = List((), (), ())

List(1, 2, 3) fproduct {(_: Int) * 2}

// res7: List[(Int, Int)] = List((1, 2), (2, 4), (3, 6))

List(1, 2, 3) as "x"

// res8: List[String] = List("x", "x", "x")

Functor則

LYAHFGG:

すべてのファンクターの性質や挙動は、ある一定の法則に従うことになっています。 … ファンクターの第一法則は、「

idでファンクター値を写した場合、ファンクター値が変化してはいけない」というものです。

Either[A, B] を使って確かめてみる。

val x: Either[String, Int] = Right(1)

// x: Either[String, Int] = Right(value = 1)

assert { (x map identity) === x }

第二法則は、2つの関数

fとgについて、「fとgの合成関数でファンクター値を写したもの」と、「まずg、次にfでファンクター値を写したもの」が等しいことを要求します。

言い換えると、

val f = {(_: Int) * 3}

// f: Int => Int = <function1>

val g = {(_: Int) + 1}

// g: Int => Int = <function1>

assert { (x map (f map g)) === (x map f map g) }

これらの法則は Functor の実装者が従うべき法則で、コンパイラはチェックしてくれない。

Discipline を用いた法則のチェック

コンパイラはチェックしてくれないけども、Cats は Functor則をコードで表現した

FunctorLaws trait を含む:

/**

* Laws that must be obeyed by any [[Functor]].

*/

trait FunctorLaws[F[_]] extends InvariantLaws[F] {

implicit override def F: Functor[F]

def covariantIdentity[A](fa: F[A]): IsEq[F[A]] =

fa.map(identity) <-> fa

def covariantComposition[A, B, C](fa: F[A], f: A => B, g: B => C): IsEq[F[C]] =

fa.map(f).map(g) <-> fa.map(f andThen g)

}

REPL からの法則のチェック

これは ScalaCheck のラッパーである Discipline というライブラリに基いている。 ScalaCheck を使って REPL からテストを実行することができる。

scala> import cats._, cats.syntax.all._

import cats._

import cats.syntax.all._

scala> import cats.laws.discipline.FunctorTests

import cats.laws.discipline.FunctorTests

scala> val rs = FunctorTests[Either[Int, *]].functor[Int, Int, Int]

val rs: cats.laws.discipline.FunctorTests[[?$0$]scala.util.Either[Int,?$0$]]#RuleSet = org.typelevel.discipline.Laws$DefaultRuleSet@2b1a2a1d

scala> import org.scalacheck.Test.Parameters

import org.scalacheck.Test.Parameters

scala> rs.all.check(Parameters.default)

+ functor.covariant composition: OK, passed 100 tests.

+ functor.covariant identity: OK, passed 100 tests.

+ functor.invariant composition: OK, passed 100 tests.

+ functor.invariant identity: OK, passed 100 tests.

rs.all は org.scalacheck.Properties を返し、これは check メソッドを実装する。

Discipline + MUnit を用いた法則のチェック

ScalaCheck の他に ScalaTest、Specs2、MUnit からこれらのテストを呼び出して使うということができる。Either[Int, Int] の Functor則を MUnit でチェックしてみよう:

package example

import cats._

import cats.laws.discipline.FunctorTests

class EitherTest extends munit.DisciplineSuite {

checkAll("Either[Int, Int]", FunctorTests[Either[Int, *]].functor[Int, Int, Int])

}

上の Either[Int, *] という表記は non/kind-projector を使っている。

テストを実行すると、以下のように表示される:

sbt:herding-cats> Test/testOnly example.EitherTest

example.EitherTest:

+ Either[Int, Int]: functor.covariant composition 0.096s

+ Either[Int, Int]: functor.covariant identity 0.017s

+ Either[Int, Int]: functor.invariant composition 0.041s

+ Either[Int, Int]: functor.invariant identity 0.011s

[info] Passed: Total 4, Failed 0, Errors 0, Passed 4

法則を破る

LYAHFGG:

ここで、

Functorのインスタンスなのに、ファンクター則を満たしていないような病的な例を考えてみましょう。

法則を破ってみよう:

package example

import cats._

sealed trait COption[+A]

case class CSome[A](counter: Int, a: A) extends COption[A]

case object CNone extends COption[Nothing]

object COption {

implicit def coptionEq[A]: Eq[COption[A]] = new Eq[COption[A]] {

def eqv(a1: COption[A], a2: COption[A]): Boolean = a1 == a2

}

implicit val coptionFunctor = new Functor[COption] {

def map[A, B](fa: COption[A])(f: A => B): COption[B] =

fa match {

case CNone => CNone

case CSome(c, a) => CSome(c + 1, f(a))

}

}

}

使ってみる:

import cats._, cats.syntax.all._

import example._

(CSome(0, "hi"): COption[String]) map {identity}

// res0: COption[String] = CSome(counter = 1, a = "hi")

これは最初の法則を破っている。検知するには COption[A] の「任意」の値を暗黙に提供する:

package example

import cats._

import cats.laws.discipline.{ FunctorTests }

import org.scalacheck.{ Arbitrary, Gen }

class COptionTest extends munit.DisciplineSuite {

checkAll("COption[Int]", FunctorTests[COption].functor[Int, Int, Int])

implicit def coptionArbiterary[A](implicit arbA: Arbitrary[A]): Arbitrary[COption[A]] =

Arbitrary {

val arbSome = for {

i <- implicitly[Arbitrary[Int]].arbitrary

a <- arbA.arbitrary

} yield (CSome(i, a): COption[A])

val arbNone = Gen.const(CNone: COption[Nothing])

Gen.oneOf(arbSome, arbNone)

}

}

以下のように表示される:

example.COptionTest:

failing seed for functor.covariant composition is 43LA3KHokN6KnEAzbkXi6IijQU91ran9-zsO2JeIyIP=

==> X example.COptionTest.COption[Int]: functor.covariant composition 0.058s munit.FailException: /Users/eed3si9n/work/herding-cats/src/test/scala/example/COptionTest.scala:8

7:class COptionTest extends munit.DisciplineSuite {

8: checkAll("COption[Int]", FunctorTests[COption].functor[Int, Int, Int])

9:

Failing seed: 43LA3KHokN6KnEAzbkXi6IijQU91ran9-zsO2JeIyIP=

You can reproduce this failure by adding the following override to your suite:

override val scalaCheckInitialSeed = "43LA3KHokN6KnEAzbkXi6IijQU91ran9-zsO2JeIyIP="

Falsified after 0 passed tests.

> Labels of failing property:

Expected: CSome(2,-1)

Received: CSome(3,-1)

> ARG_0: CSome(1,0)

> ARG_1: org.scalacheck.GenArities$$Lambda$36505/1702985322@62d7d97c

> ARG_2: org.scalacheck.GenArities$$Lambda$36505/1702985322@18bdc9d7

....

failing seed for functor.covariant identity is a4C-NCiCQEn0lU6F_TXdy5-IZ-XhMYDrC0vipJ3O_tG=

==> X example.COptionTest.COption[Int]: functor.covariant identity 0.003s munit.FailException: /Users/eed3si9n/work/herding-cats/src/test/scala/example/COptionTest.scala:8

7:class COptionTest extends munit.DisciplineSuite {

8: checkAll("COption[Int]", FunctorTests[COption].functor[Int, Int, Int])

9:

Failing seed: RhjRyflmRS-5CYveyf0uAFHuX6mWNm-Z98FVIs2aIVC=

You can reproduce this failure by adding the following override to your suite:

override val scalaCheckInitialSeed = "RhjRyflmRS-5CYveyf0uAFHuX6mWNm-Z98FVIs2aIVC="

Falsified after 1 passed tests.

> Labels of failing property:

Expected: CSome(-1486306630,-1498342842)

Received: CSome(-1486306629,-1498342842)

> ARG_0: CSome(-1486306630,-1498342842)

....

failing seed for functor.invariant composition is 9uQIZNNK_uZksfWg5pRb0VJUIgUtkv9vG9ckZ4UlRwD=

==> X example.COptionTest.COption[Int]: functor.invariant composition 0.005s munit.FailException: /Users/eed3si9n/work/herding-cats/src/test/scala/example/COptionTest.scala:8

7:class COptionTest extends munit.DisciplineSuite {

8: checkAll("COption[Int]", FunctorTests[COption].functor[Int, Int, Int])

9:

Failing seed: 9uQIZNNK_uZksfWg5pRb0VJUIgUtkv9vG9ckZ4UlRwD=

You can reproduce this failure by adding the following override to your suite:

override val scalaCheckInitialSeed = "9uQIZNNK_uZksfWg5pRb0VJUIgUtkv9vG9ckZ4UlRwD="

Falsified after 0 passed tests.

> Labels of failing property:

Expected: CSome(1,2147483647)

Received: CSome(2,2147483647)

> ARG_0: CSome(0,1095768235)

> ARG_1: org.scalacheck.GenArities$$Lambda$36505/1702985322@431263ab

> ARG_2: org.scalacheck.GenArities$$Lambda$36505/1702985322@5afe6566

> ARG_3: org.scalacheck.GenArities$$Lambda$36505/1702985322@ca0deda

> ARG_4: org.scalacheck.GenArities$$Lambda$36505/1702985322@1d7dde37

....

failing seed for functor.invariant identity is RcktTeI0rbpoUfuI3FHdvZtVGXGMoAjB6JkNBcTNTVK=

==> X example.COptionTest.COption[Int]: functor.invariant identity 0.002s munit.FailException: /Users/eed3si9n/work/herding-cats/src/test/scala/example/COptionTest.scala:8

7:class COptionTest extends munit.DisciplineSuite {

8: checkAll("COption[Int]", FunctorTests[COption].functor[Int, Int, Int])

9:

Failing seed: RcktTeI0rbpoUfuI3FHdvZtVGXGMoAjB6JkNBcTNTVK=

You can reproduce this failure by adding the following override to your suite:

override val scalaCheckInitialSeed = "RcktTeI0rbpoUfuI3FHdvZtVGXGMoAjB6JkNBcTNTVK="

Falsified after 0 passed tests.

> Labels of failing property:

Expected: CSome(2147483647,1054398067)

Received: CSome(-2147483648,1054398067)

> ARG_0: CSome(2147483647,1054398067)

....

[error] Failed: Total 4, Failed 4, Errors 0, Passed 0

[error] Failed tests:

[error] example.COptionTest

[error] (Test / testOnly) sbt.TestsFailedException: Tests unsuccessful

期待通りテストは失敗した。

import ガイド

Cats は implicit を使い倒している。ライブラリを使う側としても、拡張する側としても何がどこから来てるかという一般的な勘を作っていくのは大切だ。 ただし、Cats を始めたばかりの頃はとりあえず以下の import を使ってこのページは飛ばしても大丈夫だと思う。ただし、Cats 2.2.0 以降である必要がある:

scala> import cats._, cats.data._, cats.syntax.all._

Cats 2.2.0 以前は:

scala> import cats._, cats.data._, cats.implicits._

implicit のまとめ

Scala 2 の import と implicit を手早く復習しよう! Scala では import は 2つの目的で使われる:

- 値や型の名前をスコープに取り込むため。

- implicit をスコープに取り込むため。

ある型 A があるとき、implicit はコンパイラにその型に対応する項値をもらうための機構だ。これは色々な目的で使うことができるが、Cats では主に 2つの用法がある:

- instances; 型クラスインスタンスを提供するため。

- syntax; メソッドや演算子を注入するため。(メソッド拡張)

implicit は以下の優先順位で選択される:

- プレフィックス無しでアクセスできる暗黙の値や変換子。ローカル宣言、import、外のスコープ、継承、および現在のパッケージオブジェクトから取り込まれる。同名の暗黙の値があった場合は内側のスコープのものが外側のものを shadow する。

- 暗黙のスコープ。型、その部分、および親型のコンパニオンオブジェクトおよびパッケージオブジェクト内で宣言された暗黙の値や変換子。

import cats._

まずは import cats._ で何が import されるのかみてみよう。

まずは、名前だ。Show[A] や Functor[F[_]] のような型クラスは trait として実装されていて、cats パッケージ内で定義されている。だから、cats.Show[[A] と書くかわりに Show[A] と書ける。

次も、名前だけど、これは型エイリアス。cats のパッケージオブジェクトは Eq[A] や ~>[F[_], G[_]] のような主な型エイリアスを宣言する。これも cats.Eq[A] というふうにアクセスすることができる。

最後に、Id[A] の Traverse[F[_]] や Monad[F[_]] その他への型クラスインスタンスとして catsInstancesForId が定義されているけど、気にしなくてもいい。パッケージオブジェクトに入っているというだけで暗黙のスコープに入るので、これは import しても結果は変わらない。確かめてみよう:

scala> cats.Functor[cats.Id]

res0: cats.Functor[cats.Id] = cats.package$$anon$1@3c201c09

import は必要なしということで、うまくいった。つまり、import cats._ の効果はあくまで便宜のためであって、省略可能だ。

暗黙のスコープ

2020年の3月に Travis Brown さんの #3043 がマージされて Cats 2.2.0 としてリリースされた。まとめると、この変更は標準ライブラリ型のための型クラスインスタンスを型クラスのコンパニオン・オブジェクトへと追加した。

これによって構文スコープへと import する必要性が下がり、簡潔さとコンパイラへの負荷の低下という利点がある。例えば、Cat 2.4.x 系を使った場合、以下は一切 import 無しで動作する:

scala> cats.Functor[Option]

val res1: cats.Functor[Option] = cats.instances.OptionInstances$$anon$1@56a2a3bf

詳細は Travis さんの Implicit scope and Cats を参照。

import cats.data._

次に import cats.data._ で何が取り込まれるか見ていく。

まずは、これも名前だ。cats.data パッケージ以下には Validated[+E, +A] のようなカスタムデータ型が定義されている。

次に、型エイリアス。cats.data のパッケージオブジェクト内には Reader[A, B] (ReaderT モナド変換子を特殊化したものという扱い) のような型エイリアスが定義してある。

import cats.implicits._

だとすると、import cats.implicits._ は一体何をやっているんだろう? 以下が implicits オブジェクトの定義だ:

package cats

object implicits extends syntax.AllSyntax with instances.AllInstances

これは import をまとめるのに便利な方法だ。implicits object そのものは何も定義せずに、trait をミックスインしている。以下にそれぞれの trait を詳しくみていくけど、飲茶スタイルでそれぞれ別々に import することもできる。フルコースに戻ろう。

cats.instances.AllInstances

これまでの所、僕は意図的に型クラスインスタンスという概念とメソッド注入 (別名 enrich my library) という概念をあたかも同じ事のように扱ってきた。だけど、(Int, +) が Monoid を形成することと、Monoid が |+| 演算子を導入することは 2つの異なる事柄だ。

Cats の設計方針で興味深いことの 1つとしてこれらの概念が徹底して “instance” (インスタンス) と “syntax” (構文) として区別されていることが挙げられる。たとえどれだけ一部のユーザにとって論理的に筋が通ったとしても、ライブラリがシンボルを使った演算子を導入すると議論の火種となる。 sbt、dispatch、specs などのライブラリやツールはそれぞれ独自の DSL を導入し、それらの効用に関して何度も議論が繰り広げられた。

AllInstances は、Either[A, B] や Option[A] といった標準のデータ型に対する型クラスのインスタンスのミックスインだ。

package cats

package instances

trait AllInstances

extends FunctionInstances

with StringInstances

with EitherInstances

with ListInstances

with OptionInstances

with SetInstances

with StreamInstances

with VectorInstances

with AnyValInstances

with MapInstances

with BigIntInstances

with BigDecimalInstances

with FutureInstances

with TryInstances

with TupleInstances

with UUIDInstances

with SymbolInstances

cats.syntax.AllSyntax

AllSyntax は、Cats 内にある全ての演算子をミックスインする trait だ。

package cats

package syntax

trait AllSyntax

extends ApplicativeSyntax

with ApplicativeErrorSyntax

with ApplySyntax

with BifunctorSyntax

with BifoldableSyntax

with BitraverseSyntax

with CartesianSyntax

with CoflatMapSyntax

with ComonadSyntax

with ComposeSyntax

with ContravariantSyntax

with CoproductSyntax

with EitherSyntax

with EqSyntax

....

アラカルト形式

僕は、飲茶スタイルという名前の方がいいと思うけど、カートで点心が運ばれてきて好きなものを選んで取る「飲茶」でピンと来なければ、カウンターに座って好きなものを頼む焼き鳥屋だと考えてもいい。

もし何らかの理由で cats.implicits._ を全て import したくなければ、好きなものを選ぶことができる。

型クラスインスタンス

前述の通り、Cats 2.2.0 以降は普通は何もしなくても型クラスのインスタンスを得ることができる。

cats.Monad[Option].pure(0)

// res0: Option[Int] = Some(value = 0)

何らかの理由で Option のための全ての型クラスインスタンスを導入する方法:

{

import cats.instances.option._

cats.Monad[Option].pure(0)

}

// res1: Option[Int] = Some(value = 0)

全てのインスタンスが欲しければ、以下が全て取り込む方法だ:

{

import cats.instances.all._

cats.Monoid[Int].empty

}

// res2: Int = 0

演算子の注入を一切行なっていないので、ヘルパー関数や型クラスインスタンスに定義された関数を使う必要がある (そっちの方が好みという人もいる)。

Cats 型クラスの syntax

型クラスの syntax は型クラスごとに分かれている。以下が Eq のためのメソッドや演算子を注入する方法だ:

{

import cats.syntax.eq._

1 === 1

}

// res3: Boolean = true

Cats データ型の syntax

Writer のような Cats 独自のデータ型のための syntax も cats.syntax パッケージ以下にある:

{

import cats.syntax.writer._

1.tell

}

// res4: cats.data.package.Writer[Int, Unit] = WriterT(run = (1, ()))

標準データ型の syntax

標準データ型のための sytnax はデータ型ごとに分かれている。以下が Option のための演算子とヘルパー関数を注入する方法だ:

{

import cats.syntax.option._

1.some

}

// res5: Option[Int] = Some(value = 1)

全ての syntax

以下は全ての syntax と型クラスインスタンスを取り込む方法だ。

{

import cats.syntax.all._

import cats.instances.all._

1.some

}

// res6: Option[Int] = Some(value = 1)

これは cats.implicits._ を import するのと同じだ。

繰り返すが、これを読んで分からなかったら、まずは以下を使っていれば大丈夫だ:

scala> import cats._, cats.data._, cats.syntax.all._

3日目

昨日は simulacrum を使って独自の型クラスを定義することから始めて、 Discipline を用いて Functor則を検査するところまでみた。

型を司るもの、カインド

型とは、値について何らかの推論をするために付いている小さなラベルです。そして、型にも小さなラベルが付いているんです。その名は種類 (kind)。 … 種類とはそもそも何者で、何の役に立つのでしょう?さっそく GHCi の

:kコマンドを使って、型の種類を調べてみましょう。

Scala 2.10 時点では Scala REPL に :k コマンドが無かったので、ひとつ書いてみた: kind.scala。

George Leontiev 氏 (@folone) その他のお陰で、Scala 2.11 より :kind コマンドは標準機能として取り込まれた。使ってみよう:

scala> :k Int

scala.Int's kind is A

scala> :k -v Int

scala.Int's kind is A

*

This is a proper type.

Int と他の全ての値を作ることのできる型はプロパーな型と呼ばれ * というシンボルで表記される (「型」と読む)。これは値レベルだと 1 に相当する。Scala の型変数構文を用いるとこれは A と書ける。

scala> :k -v Option

scala.Option's kind is F[+A]

* -(+)-> *

This is a type constructor: a 1st-order-kinded type.

scala> :k -v Either

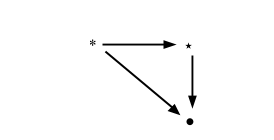

scala.util.Either's kind is F[+A1,+A2]

* -(+)-> * -(+)-> *

This is a type constructor: a 1st-order-kinded type.

これらは、型コンストラクタと呼ばれる。別の見方をすると、これらはプロパーな型から1ステップ離れている型だと考えることもできる。

これは値レベルだと、1階値、つまり普通関数と呼ばれる (_: Int) + 3 などに相当する。

カリー化した表記法を用いて * -> * や * -> * -> * などと書く。このとき Option[Int] は * で、Option が * -> * であることに注意。Scala の型変数構文を用いるとこれらは F[+A]、 F[+A1,+A2] となる。

scala> :k -v Eq

algebra.Eq's kind is F[A]

* -> *

This is a type constructor: a 1st-order-kinded type.

Scala は型クラスという概念を型コンストラクタを用いてエンコード (悪く言うとコンプレクト) する。

これを見たとき、Eq は A (つまりプロパーな型) の型クラスだと思ってほしい。

Eq には Int などを渡すので、これは理にかなっている。

scala> :k -v Functor

cats.Functor's kind is X[F[A]]

(* -> *) -> *

This is a type constructor that takes type constructor(s): a higher-kinded type.

繰り返すが、Scala は型クラスを型コンストラクタを用いてエンコードするため、

これを見たとき、Functor は F[A] (つまり、型コンストラクタ) のための型クラスだと思ってほしい。

Functor には List などを渡すので、これも理にかなっている。

別の言い方をすると、これは型コンストラクタを受け取る型コンストラクタだ。

これは値レベルだと高階関数に相当するもので、高カインド型 (higher-kinded type) と呼ばれる。

これらは (* -> *) -> * と表記される。Scala の型変数構文を用いるとこれは X[F[A]] と書ける。

forms-a vs is-a

型クラス関連の用語は混用されやすい。

例えば、(Int, +) のペアはモノイドという型クラスを形成する。

口語的には、「なんらかの演算に関して X はモノイドを形成できるか? (can X form a monoid under some operation?)

という意味で「is X a monoid?」と言ったりする。

この例は、昨日の説明で、暗に Either[A, B] はファンクターである (“is-a”) という説明になっていたはずだ。

実用的では無いかもしれないが、左バイアスのかかったファンクターを定義することは可能であるため、これは正確ではないと言える。

Semigroupal

Functors, Applicative Functors and Monoids:

ここまではファンクター値を写すために、もっぱら 1 引数関数を使ってきました。では、2 引数関数でファンクターを写すと何が起こるでしょう?

import cats._

{

val hs = Functor[List].map(List(1, 2, 3, 4)) ({(_: Int) * (_:Int)}.curried)

Functor[List].map(hs) {_(9)}

}

// res0: List[Int] = List(9, 18, 27, 36)

LYAHFGG:

では、ファンクター値

Just (3 *)とファンクター値Just 5があったとして、Just (3 *)から関数を取り出してJust 5の中身に適用したくなったとしたらどうしましょう?

Control.Applicativeモジュールにある型クラスApplicativeに会いに行きましょう!型クラスApplicativeは、2つの関数pureと<*>を定義しています。

Cats はこれを Cartesian、Apply、 Applicative に分けている。以下が Cartesian のコントラクト:

/**

* [[Semigroupal]] captures the idea of composing independent effectful values.

* It is of particular interest when taken together with [[Functor]] - where [[Functor]]

* captures the idea of applying a unary pure function to an effectful value,

* calling `product` with `map` allows one to apply a function of arbitrary arity to multiple

* independent effectful values.

*

* That same idea is also manifested in the form of [[Apply]], and indeed [[Apply]] extends both

* [[Semigroupal]] and [[Functor]] to illustrate this.

*/

@typeclass trait Semigroupal[F[_]] {

def product[A, B](fa: F[A], fb: F[B]): F[(A, B)]

}

Semigroupal は product 関数を定義して、これは F[A] と F[B] から、効果 F[_] に包まれたペア (A, B) を作る。

Cartesian 則

Cartesian には結合則という法則が1つのみある:

trait CartesianLaws[F[_]] {

implicit def F: Cartesian[F]

def cartesianAssociativity[A, B, C](fa: F[A], fb: F[B], fc: F[C]): (F[(A, (B, C))], F[((A, B), C)]) =

(F.product(fa, F.product(fb, fc)), F.product(F.product(fa, fb), fc))

}

Apply

Functors, Applicative Functors and Monoids:

ここまではファンクター値を写すために、もっぱら 1 引数関数を使ってきました。では、2 引数関数でファンクターを写すと何が起こるでしょう?

import cats._, cats.syntax.all._

{

val hs = Functor[List].map(List(1, 2, 3, 4)) ({(_: Int) * (_:Int)}.curried)

Functor[List].map(hs) {_(9)}

}

// res0: List[Int] = List(9, 18, 27, 36)

LYAHFGG:

では、ファンクター値

Just (3 *)とファンクター値Just 5があったとして、Just (3 *)から関数を取り出してJust 5の中身に適用したくなったとしたらどうしましょう?

Control.Applicativeモジュールにある型クラスApplicativeに会いに行きましょう!型クラスApplicativeは、2つの関数pureと<*>を定義しています。

Cats は Applicative を Apply と Applicative に分けている。以下が Apply のコントラクト:

/**

* Weaker version of Applicative[F]; has apply but not pure.

*

* Must obey the laws defined in cats.laws.ApplyLaws.

*/

@typeclass(excludeParents = List("ApplyArityFunctions"))

trait Apply[F[_]] extends Functor[F] with Cartesian[F] with ApplyArityFunctions[F] { self =>

/**

* Given a value and a function in the Apply context, applies the

* function to the value.

*/

def ap[A, B](ff: F[A => B])(fa: F[A]): F[B]

....

}

Apply は Functor、Cartesian、そして ApplyArityFunctions を拡張することに注目してほしい。

<*> 関数は、Cats の Apply では ap と呼ばれる。(これは最初は apply と呼ばれていたが、ap に直された。+1)

LYAHFGG:

<*>はfmapの強化版なのです。fmapが普通の関数とファンクター値を引数に取って、関数をファンクター値の中の値に適用してくれるのに対し、<*>は関数の入っているファンクター値と値の入っているファンクター値を引数に取って、1つ目のファンクターの中身である関数を2つ目のファンクターの中身に適用するのです。

Applicative Style

LYAHFGG:

Applicative型クラスでは、<*>を連続して使うことができ、 1つだけでなく、複数のアプリカティブ値を組み合わせて使うことができます。

以下は Haskell で書かれた例:

ghci> pure (-) <*> Just 3 <*> Just 5

Just (-2)

Cats には apply 構文というものがある。

(3.some, 5.some) mapN { _ - _ }

// res1: Option[Int] = Some(value = -2)

(none[Int], 5.some) mapN { _ - _ }

// res2: Option[Int] = None

(3.some, none[Int]) mapN { _ - _ }

// res3: Option[Int] = None

これは Option から Cartesian が形成可能であることを示す。

Apply としての List

LYAHFGG:

リスト(正確に言えばリスト型のコンストラクタ

[])もアプリカティブファンクターです。意外ですか?

apply 構文で書けるかためしてみよう:

(List("ha", "heh", "hmm"), List("?", "!", ".")) mapN {_ + _}

// res4: List[String] = List(

// "ha?",

// "ha!",

// "ha.",

// "heh?",

// "heh!",

// "heh.",

// "hmm?",

// "hmm!",

// "hmm."

// )

*> と <* 演算子

Apply は <* と *> という 2つの演算子を可能とし、これらも Apply[F].map2 の特殊形だと考えることができる。

定義はシンプルに見えるけども、面白い効果がある:

1.some <* 2.some

// res5: Option[Int] = Some(value = 1)

none[Int] <* 2.some

// res6: Option[Int] = None

1.some *> 2.some

// res7: Option[Int] = Some(value = 2)

none[Int] *> 2.some

// res8: Option[Int] = None

どちらか一方が失敗すると、None が返ってくる。

Option syntax

次にへ行く前に、Optiona 値を作るために Cats が導入する syntax をみてみる。

9.some

// res9: Option[Int] = Some(value = 9)

none[Int]

// res10: Option[Int] = None

これで (Some(9): Option[Int]) を 9.some と書ける。

Apply としての Option

これを Apply[Option].ap と一緒に使ってみる:

import cats._, cats.syntax.all._

Apply[Option].ap({{(_: Int) + 3}.some })(9.some)

// res12: Option[Int] = Some(value = 12)

Apply[Option].ap({{(_: Int) + 3}.some })(10.some)

// res13: Option[Int] = Some(value = 13)

Apply[Option].ap({{(_: String) + "hahah"}.some })(none[String])

// res14: Option[String] = None

Apply[Option].ap({ none[String => String] })("woot".some)

// res15: Option[String] = None

どちらかが失敗すると、None が返ってくる。

昨日の simulacrum を用いた独自型クラスの定義で見たとおり、 simulacrum は型クラス・コントラクト内で定義された関数を演算子として (魔法の力で) 転写する。

({(_: Int) + 3}.some) ap 9.some

// res16: Option[Int] = Some(value = 12)

({(_: Int) + 3}.some) ap 10.some

// res17: Option[Int] = Some(value = 13)

({(_: String) + "hahah"}.some) ap none[String]

// res18: Option[String] = None

(none[String => String]) ap "woot".some

// res19: Option[String] = None

Apply の便利な関数

LYAHFGG:

Control.ApplicativeにはliftA2という、以下のような型を持つ関数があります。

liftA2 :: (Applicative f) => (a -> b -> c) -> f a -> f b -> f c .

Scala ではパラメータが逆順であることを覚えているだろうか。

つまり、F[B] と F[A] を受け取った後、(A, B) => C という関数を受け取る関数だ。

これは Apply では map2 と呼ばれている。

@typeclass(excludeParents = List("ApplyArityFunctions"))

trait Apply[F[_]] extends Functor[F] with Cartesian[F] with ApplyArityFunctions[F] { self =>

def ap[A, B](ff: F[A => B])(fa: F[A]): F[B]

def productR[A, B](fa: F[A])(fb: F[B]): F[B] =

map2(fa, fb)((_, b) => b)

def productL[A, B](fa: F[A])(fb: F[B]): F[A] =

map2(fa, fb)((a, _) => a)

override def product[A, B](fa: F[A], fb: F[B]): F[(A, B)] =

ap(map(fa)(a => (b: B) => (a, b)))(fb)

/** Alias for [[ap]]. */

@inline final def <*>[A, B](ff: F[A => B])(fa: F[A]): F[B] =

ap(ff)(fa)

/** Alias for [[productR]]. */

@inline final def *>[A, B](fa: F[A])(fb: F[B]): F[B] =

productR(fa)(fb)

/** Alias for [[productL]]. */

@inline final def <*[A, B](fa: F[A])(fb: F[B]): F[A] =

productL(fa)(fb)

/**

* ap2 is a binary version of ap, defined in terms of ap.

*/

def ap2[A, B, Z](ff: F[(A, B) => Z])(fa: F[A], fb: F[B]): F[Z] =

map(product(fa, product(fb, ff))) { case (a, (b, f)) => f(a, b) }

def map2[A, B, Z](fa: F[A], fb: F[B])(f: (A, B) => Z): F[Z] =

map(product(fa, fb))(f.tupled)

def map2Eval[A, B, Z](fa: F[A], fb: Eval[F[B]])(f: (A, B) => Z): Eval[F[Z]] =

fb.map(fb => map2(fa, fb)(f))

....

}

2項演算子に関しては、map2 を使うことでアプリカティブ・スタイルを隠蔽することができる。

同じものを 2通りの方法で書いて比較してみる:

(3.some, List(4).some) mapN { _ :: _ }

// res20: Option[List[Int]] = Some(value = List(3, 4))

Apply[Option].map2(3.some, List(4).some) { _ :: _ }

// res21: Option[List[Int]] = Some(value = List(3, 4))

同じ結果となった。

Apply[F].ap の 2パラメータ版は Apply[F].ap2 と呼ばれる:

Apply[Option].ap2({{ (_: Int) :: (_: List[Int]) }.some })(3.some, List(4).some)

// res22: Option[List[Int]] = Some(value = List(3, 4))

map2 の特殊形で tuple2 というものもあって、このように使う:

Apply[Option].tuple2(1.some, 2.some)

// res23: Option[(Int, Int)] = Some(value = (1, 2))

Apply[Option].tuple2(1.some, none[Int])

// res24: Option[(Int, Int)] = None

2つ以上のパラメータを受け取る関数があったときはどうなるんだろうかと気になっている人は、

Apply[F[_]] が ApplyArityFunctions[F] を拡張することに気付いただろうか。

これは ap3、map3、tuple3 … から始まって

ap22、map22、tuple22 まで自動生成されたコードだ。

Apply則

Apply には合成則という法則のみが1つある:

trait ApplyLaws[F[_]] extends FunctorLaws[F] {

implicit override def F: Apply[F]

def applyComposition[A, B, C](fa: F[A], fab: F[A => B], fbc: F[B => C]): IsEq[F[C]] = {

val compose: (B => C) => (A => B) => (A => C) = _.compose

fa.ap(fab).ap(fbc) <-> fa.ap(fab.ap(fbc.map(compose)))

}

}

Applicative

注意: アプリカティブ・ファンクターに興味があってこのページに飛んできた人は、まずは Semigroupal と Apply を読んでほしい。

Functors, Applicative Functors and Monoids:

Control.Applicativeモジュールにある型クラスApplicativeに会いに行きましょう!型クラスApplicativeは、2つの関数pureと<*>を定義しています。

Cats の Applicative を見てみよう:

@typeclass trait Applicative[F[_]] extends Apply[F] { self =>

/**

* `pure` lifts any value into the Applicative Functor

*

* Applicative[Option].pure(10) = Some(10)

*/

def pure[A](x: A): F[A]

....

}

Apply を拡張して pure をつけただけだ。

LYAHFGG:

pureは任意の型の引数を受け取り、それをアプリカティブ値の中に入れて返します。 … アプリカティブ値は「箱」というよりも「文脈」と考えるほうが正確かもしれません。pureは、値を引数に取り、その値を何らかのデフォルトの文脈(元の値を再現できるような最小限の文脈)に置くのです。

A の値を受け取り F[A] を返すコンストラクタみたいだ。

import cats._, cats.syntax.all._

Applicative[List].pure(1)

// res0: List[Int] = List(1)

Applicative[Option].pure(1)

// res1: Option[Int] = Some(value = 1)

これは、Apply[F].ap を書くときに {{...}.some} としなくて済むのが便利かも。

{

val F = Applicative[Option]

F.ap({ F.pure((_: Int) + 3) })(F.pure(9))

}

// res2: Option[Int] = Some(value = 12)

Option を抽象化したコードになった。

Applicative の便利な関数

LYAHFGG:

では、「アプリカティブ値のリスト」を取って「リストを返り値として持つ1つのアプリカティブ値」を返す関数を実装してみましょう。これを

sequenceAと呼ぶことにします。

sequenceA :: (Applicative f) => [f a] -> f [a]

sequenceA [] = pure []

sequenceA (x:xs) = (:) <$> x <*> sequenceA xs

これを Cats でも実装できるか試してみよう!

def sequenceA[F[_]: Applicative, A](list: List[F[A]]): F[List[A]] = list match {

case Nil => Applicative[F].pure(Nil: List[A])

case x :: xs => (x, sequenceA(xs)) mapN {_ :: _}

}

テストしてみよう:

sequenceA(List(1.some, 2.some))

// res3: Option[List[Int]] = Some(value = List(1, 2))

sequenceA(List(3.some, none[Int], 1.some))

// res4: Option[List[Int]] = None

sequenceA(List(List(1, 2, 3), List(4, 5, 6)))

// res5: List[List[Int]] = List(

// List(1, 4),

// List(1, 5),

// List(1, 6),

// List(2, 4),

// List(2, 5),

// List(2, 6),

// List(3, 4),

// List(3, 5),

// List(3, 6)

// )

正しい答えが得られた。興味深いのは結局 Applicative が必要になったことと、

sequenceA が型クラスを利用したジェネリックな形になっていることだ。

sequenceAは、関数のリストがあり、そのすべてに同じ引数を食わして結果をリストとして眺めたい、という場合にはとても便利です。

Function1 の片側が Int に固定された例は、型解釈を付ける必要がある。

{

val f = sequenceA[Function1[Int, *], Int](List((_: Int) + 3, (_: Int) + 2, (_: Int) + 1))

f(3)

}

// res6: List[Int] = List(6, 5, 4)

Applicative則

以下がの Applicative のための法則だ:

- identity:

pure id <*> v = v - homomorphism:

pure f <*> pure x = pure (f x) - interchange:

u <*> pure y = pure ($ y) <*> u

Cats はもう 1つ別の法則を定義している:

def applicativeMap[A, B](fa: F[A], f: A => B): IsEq[F[B]] =

fa.map(f) <-> fa.ap(F.pure(f))

F.ap と F.pure を合成したとき、それは F.map と同じ効果を得られるということみたいだ。

結構長くなったけど、ここまでたどり着けて良かったと思う。続きはまたあとで。

4日目

昨日はカインドと型をおさらいして、Apply と

applicative style を探索した後で、

sequenceA にたどり着いた。

続いて今日は Semigroup と Monoid をやってみよう。

Semigroup

「すごいHaskellたのしく学ぼう」の本を持ってるひとは新しい章に進める。モノイドだ。ウェブサイトを読んでるひとは Functors, Applicative Functors and Monoids の続きだ。

とりあえず、Cats には newtype や tagged type 的な機能は入ってないみたいだ。

後で自分たちで実装することにする。

Haskell の Monoid は、Cats では Semigroup と Monoid に分かれている。

これらはそれぞれ algebra.Semigroup と algebra.Monoid の型エイリアスだ。

Apply と Applicative 同様に、Semigroup は Monoid の弱いバージョンだ。

同じ問題を解く事ができるなら、より少ない前提を置くため弱い方がかっこいい。

LYAHFGG:

LYAHFGG:

例えば、

(3 * 4) * 5も3 * (4 * 5)も、答は60です。++についてもこの性質は成り立ちます。 …この性質を結合的 (associativity) と呼びます。演算

*と++は結合的であると言います。結合的でない演算の例は-です。

確かめてみる:

import cats._, cats.syntax.all._

assert { (3 * 2) * (8 * 5) === 3 * (2 * (8 * 5)) }

assert { List("la") ++ (List("di") ++ List("da")) === (List("la") ++ List("di")) ++ List("da") }

エラーがないから等価ということだ。

Semigroup 型クラス

これが algebra.Semigroup の型クラスコントラクトだ。

/**

* A semigroup is any set `A` with an associative operation (`combine`).

*/

trait Semigroup[@sp(Int, Long, Float, Double) A] extends Any with Serializable {

/**

* Associative operation taking which combines two values.

*/

def combine(x: A, y: A): A

....

}

これは combine 演算子とそのシンボルを使ったエイリアスである |+| を可能とする。使ってみる。

List(1, 2, 3) |+| List(4, 5, 6)

// res2: List[Int] = List(1, 2, 3, 4, 5, 6)

"one" |+| "two"

// res3: String = "onetwo"

Semigroup則

結合則が semigroup の唯一の法則だ。

- associativity

(x |+| y) |+| z = x |+| (y |+| z)

以下は、Semigroup則を REPL から検査する方法だ。 詳細はDiscipline を用いた法則のチェックを参照。

scala> import cats._, cats.data._, cats.implicits._

import cats._

import cats.data._

import cats.implicits._

scala> import cats.kernel.laws.GroupLaws

import cats.kernel.laws.GroupLaws

scala> val rs1 = GroupLaws[Int].semigroup(Semigroup[Int])

rs1: cats.kernel.laws.GroupLaws[Int]#GroupProperties = cats.kernel.laws.GroupLaws$GroupProperties@5a077d1d

scala> rs1.all.check

+ semigroup.associativity: OK, passed 100 tests.

+ semigroup.combineN(a, 1) == a: OK, passed 100 tests.

+ semigroup.combineN(a, 2) == a |+| a: OK, passed 100 tests.

+ semigroup.serializable: OK, proved property.

Semigroups としての List

List(1, 2, 3) |+| List(4, 5, 6)

// res4: List[Int] = List(1, 2, 3, 4, 5, 6)

積と和

Int は、+ と * の両方に関して semigroup を形成することができる。

Tagged type の代わりに、cats は加算に対してにのみ

semigroup のインスタンスを提供するという方法をとっている。

これを演算子構文で書くのはトリッキーだ。

def doSomething[A: Semigroup](a1: A, a2: A): A =

a1 |+| a2

doSomething(3, 5)(Semigroup[Int])

// res5: Int = 8

これなら、関数構文で書いたほうが楽かもしれない:

Semigroup[Int].combine(3, 5)

// res6: Int = 8

Monoid

LYAHFGG:

どうやら、

*に1という組み合わせと、++に[]という組み合わせは、共通の性質を持っているようですね。

- 関数は引数を2つ取る。

- 2つの引数および返り値の型はすべて等しい。

- 2引数関数を施して相手を変えないような特殊な値が存在する。

これを Scala で確かめてみる:

4 * 1

// res0: Int = 4

1 * 9

// res1: Int = 9

List(1, 2, 3) ++ Nil

// res2: List[Int] = List(1, 2, 3)

Nil ++ List(0.5, 2.5)

// res3: List[Double] = List(0.5, 2.5)

あってるみたいだ。

Monoid 型クラス

以下が algebera.Monoid の型クラス・コントラクトだ:

/**

* A monoid is a semigroup with an identity. A monoid is a specialization of a

* semigroup, so its operation must be associative. Additionally,

* `combine(x, empty) == combine(empty, x) == x`. For example, if we have `Monoid[String]`,

* with `combine` as string concatenation, then `empty = ""`.

*/

trait Monoid[@sp(Int, Long, Float, Double) A] extends Any with Semigroup[A] {

/**

* Return the identity element for this monoid.

*/

def empty: A

...

}

Monoid則

Semigroup則に加えて、Monoid則はもう 2つの法則がある:

- associativity

(x |+| y) |+| z = x |+| (y |+| z) - left identity

Monoid[A].empty |+| x = x - right identity

x |+| Monoid[A].empty = x

REPL から Monoid則を検査してみよう:

scala> import cats._, cats.syntax.all._

import cats._

import cats.syntax.all._

scala> import cats.kernel.laws.discipline.MonoidTests

import cats.kernel.laws.discipline.MonoidTests

scala> import org.scalacheck.Test.Parameters

import org.scalacheck.Test.Parameters

scala> val rs1 = MonoidTests[Int].monoid

val rs1: cats.kernel.laws.discipline.MonoidTests[Int]#RuleSet = org.typelevel.discipline.Laws$DefaultRuleSet@108684fb

scala> rs1.all.check(Parameters.default)

+ monoid.associative: OK, passed 100 tests.

+ monoid.collect0: OK, passed 100 tests.

+ monoid.combine all: OK, passed 100 tests.

+ monoid.combineAllOption: OK, passed 100 tests.

+ monoid.intercalateCombineAllOption: OK, passed 100 tests.

+ monoid.intercalateIntercalates: OK, passed 100 tests.

+ monoid.intercalateRepeat1: OK, passed 100 tests.

+ monoid.intercalateRepeat2: OK, passed 100 tests.

+ monoid.is id: OK, passed 100 tests.

+ monoid.left identity: OK, passed 100 tests.

+ monoid.repeat0: OK, passed 100 tests.

+ monoid.repeat1: OK, passed 100 tests.

+ monoid.repeat2: OK, passed 100 tests.

+ monoid.reverseCombineAllOption: OK, passed 100 tests.

+ monoid.reverseRepeat1: OK, passed 100 tests.

+ monoid.reverseRepeat2: OK, passed 100 tests.

+ monoid.reverseReverses: OK, passed 100 tests.

+ monoid.right identity: OK, passed 100 tests.

MUnit test で書くとこうなる:

package example

import cats._

import cats.kernel.laws.discipline.MonoidTests

class IntTest extends munit.DisciplineSuite {

checkAll("Int", MonoidTests[Int].monoid)

}

値クラス

LYAHFGG:

Haskell の newtype キーワードは、まさにこのような「1つの型を取り、それを何かにくるんで別の型に見せかけたい」という場合のために作られたものです。

Cats は tagged type 的な機能を持たないけども、現在の Scala には値クラスがある。ある一定の条件下ではこれは unboxed (メモリ割り当てオーバーヘッドが無いこと) を保つので、簡単な例に使う分には問題無いと思う。

class Wrapper(val unwrap: Int) extends AnyVal

Disjunction と Conjunction

LYAHFGG:

モノイドにする方法が2通りあって、どちらも捨てがたいような型は、

Num a以外にもあります。Boolです。1つ目の方法は||をモノイド演算とし、Falseを単位元とする方法です。 ….

BoolをMonoidのインスタンスにするもう1つの方法は、Anyのいわば真逆です。&&をモノイド演算とし、Trueを単位元とする方法です。

Cats はこれを提供しないけども、自分で実装してみる。

import cats._, cats.syntax.all._

// `class Disjunction(val unwrap: Boolean) extends AnyVal` doesn't work on mdoc

class Disjunction(val unwrap: Boolean)

object Disjunction {

@inline def apply(b: Boolean): Disjunction = new Disjunction(b)

implicit val disjunctionMonoid: Monoid[Disjunction] = new Monoid[Disjunction] {

def combine(a1: Disjunction, a2: Disjunction): Disjunction =

Disjunction(a1.unwrap || a2.unwrap)

def empty: Disjunction = Disjunction(false)

}

implicit val disjunctionEq: Eq[Disjunction] = new Eq[Disjunction] {

def eqv(a1: Disjunction, a2: Disjunction): Boolean =

a1.unwrap == a2.unwrap

}

}

val x1 = Disjunction(true) |+| Disjunction(false)

// x1: Disjunction = repl.MdocSessionDisjunction@67bf7df7

x1.unwrap

// res4: Boolean = true

val x2 = Monoid[Disjunction].empty |+| Disjunction(true)

// x2: Disjunction = repl.MdocSessionDisjunction@78016f6f

x2.unwrap

// res5: Boolean = true

こっちが Conjunction:

// `class Conjunction(val unwrap: Boolean) extends AnyVal` doesn't work on mdoc

class Conjunction(val unwrap: Boolean)

object Conjunction {

@inline def apply(b: Boolean): Conjunction = new Conjunction(b)

implicit val conjunctionMonoid: Monoid[Conjunction] = new Monoid[Conjunction] {

def combine(a1: Conjunction, a2: Conjunction): Conjunction =

Conjunction(a1.unwrap && a2.unwrap)

def empty: Conjunction = Conjunction(true)

}

implicit val conjunctionEq: Eq[Conjunction] = new Eq[Conjunction] {

def eqv(a1: Conjunction, a2: Conjunction): Boolean =

a1.unwrap == a2.unwrap

}

}

val x3 = Conjunction(true) |+| Conjunction(false)

// x3: Conjunction = repl.MdocSessionConjunction@40b73a81

x3.unwrap

// res6: Boolean = false

val x4 = Monoid[Conjunction].empty |+| Conjunction(true)

// x4: Conjunction = repl.MdocSessionConjunction@c708b1e

x4.unwrap

// res7: Boolean = true

独自 newtype がちゃんと Monoid則を満たしているかチェックするべきだ。

scala> import cats._, cats.syntax.all._

import cats._

import cats.syntax.all._

scala> import cats.kernel.laws.discipline.MonoidTests

import cats.kernel.laws.discipline.MonoidTests

scala> import org.scalacheck.Test.Parameters

import org.scalacheck.Test.Parameters

scala> import org.scalacheck.{ Arbitrary, Gen }

import org.scalacheck.{Arbitrary, Gen}

scala> implicit def arbDisjunction(implicit ev: Arbitrary[Boolean]): Arbitrary[Disjunction] =

Arbitrary { ev.arbitrary map { Disjunction(_) } }

def arbDisjunction(implicit ev: org.scalacheck.Arbitrary[Boolean]): org.scalacheck.Arbitrary[Disjunction]

scala> val rs1 = MonoidTests[Disjunction].monoid

val rs1: cats.kernel.laws.discipline.MonoidTests[Disjunction]#RuleSet = org.typelevel.discipline.Laws$DefaultRuleSet@464d134

scala> rs1.all.check(Parameters.default)

+ monoid.associative: OK, passed 100 tests.

+ monoid.collect0: OK, passed 100 tests.

+ monoid.combine all: OK, passed 100 tests.

+ monoid.combineAllOption: OK, passed 100 tests.

....

Disjunction は動いた。

scala> implicit def arbConjunction(implicit ev: Arbitrary[Boolean]): Arbitrary[Conjunction] =

Arbitrary { ev.arbitrary map { Conjunction(_) } }

def arbConjunction(implicit ev: org.scalacheck.Arbitrary[Boolean]): org.scalacheck.Arbitrary[Conjunction]

scala> val rs2 = MonoidTests[Conjunction].monoid

val rs2: cats.kernel.laws.discipline.MonoidTests[Conjunction]#RuleSet = org.typelevel.discipline.Laws$DefaultRuleSet@71a4f643

scala> rs2.all.check(Parameters.default)

+ monoid.associative: OK, passed 100 tests.

+ monoid.collect0: OK, passed 100 tests.

+ monoid.combine all: OK, passed 100 tests.

+ monoid.combineAllOption: OK, passed 100 tests.

....

Conjunction も大丈夫そうだ。

Monoid としての Option

LYAHFGG:

Maybe aをモノイドにする1つ目の方法は、型引数aがモノイドであるときに限りMaybe aもモノイドであるとし、Maybe aのmappendを、Justの中身のmappendを使って定義することです。

Cats がこうなっているか確認しよう。

implicit def optionMonoid[A](implicit ev: Semigroup[A]): Monoid[Option[A]] =

new Monoid[Option[A]] {

def empty: Option[A] = None

def combine(x: Option[A], y: Option[A]): Option[A] =

x match {

case None => y

case Some(xx) => y match {

case None => x

case Some(yy) => Some(ev.combine(xx,yy))

}

}

}

mappend を combine と読み替えれば、あとはパターンマッチだけだ。

使ってみよう。

none[String] |+| "andy".some

// res8: Option[String] = Some(value = "andy")

1.some |+| none[Int]

// res9: Option[Int] = Some(value = 1)

ちゃんと動く。

LYAHFGG:

中身がモノイドがどうか分からない状態では、

mappendは使えません。どうすればいいでしょう? 1つの選択は、第一引数を返して第二引数は捨てる、と決めておくことです。この用途のためにFirst aというものが存在します。

Haskell は newtype を使って First 型コンストラクタを実装している。

ジェネリックな値クラスの場合はメモリ割り当てを回避することができないので、普通に case class を使おう。

case class First[A: Eq](val unwrap: Option[A])

object First {

implicit def firstMonoid[A: Eq]: Monoid[First[A]] = new Monoid[First[A]] {

def combine(a1: First[A], a2: First[A]): First[A] =

First((a1.unwrap, a2.unwrap) match {

case (Some(x), _) => Some(x)

case (None, y) => y

})

def empty: First[A] = First(None: Option[A])

}

implicit def firstEq[A: Eq]: Eq[First[A]] = new Eq[First[A]] {

def eqv(a1: First[A], a2: First[A]): Boolean =

Eq[Option[A]].eqv(a1.unwrap, a2.unwrap)

}

}

First('a'.some) |+| First('b'.some)

// res10: First[Char] = First(unwrap = Some(value = 'a'))

First(none[Char]) |+| First('b'.some)

// res11: First[Char] = First(unwrap = Some(value = 'b'))

Monoid則を検査:

scala> implicit def arbFirst[A: Eq](implicit ev: Arbitrary[Option[A]]): Arbitrary[First[A]] =

Arbitrary { ev.arbitrary map { First(_) } }

def arbFirst[A](implicit evidence$1: cats.Eq[A], ev: org.scalacheck.Arbitrary[Option[A]]): org.scalacheck.Arbitrary[First[A]]

scala> val rs3 = MonoidTests[First[Int]].monoid

val rs3: cats.kernel.laws.discipline.MonoidTests[First[Int]]#RuleSet = org.typelevel.discipline.Laws$DefaultRuleSet@17d3711d

scala> rs3.all.check(Parameters.default)

+ monoid.associative: OK, passed 100 tests.

+ monoid.collect0: OK, passed 100 tests.

+ monoid.combine all: OK, passed 100 tests.

+ monoid.combineAllOption: OK, passed 100 tests.

....

First もシリアライズできないらしい。

LYAHFGG:

逆に、2つの

Justをmappendしたときに後のほうの引数を優先するようなMaybe aが欲しい、という人のために、Data.MonoidにはLast a型も用意されています。

case class Last[A: Eq](val unwrap: Option[A])

object Last {

implicit def lastMonoid[A: Eq]: Monoid[Last[A]] = new Monoid[Last[A]] {

def combine(a1: Last[A], a2: Last[A]): Last[A] =

Last((a1.unwrap, a2.unwrap) match {

case (_, Some(y)) => Some(y)

case (x, None) => x

})

def empty: Last[A] = Last(None: Option[A])

}

implicit def lastEq[A: Eq]: Eq[Last[A]] = new Eq[Last[A]] {

def eqv(a1: Last[A], a2: Last[A]): Boolean =

Eq[Option[A]].eqv(a1.unwrap, a2.unwrap)

}

}

Last('a'.some) |+| Last('b'.some)

// res12: Last[Char] = Last(unwrap = Some(value = 'b'))

Last('a'.some) |+| Last(none[Char])

// res13: Last[Char] = Last(unwrap = Some(value = 'a'))

また、法則検査。

scala> implicit def arbLast[A: Eq](implicit ev: Arbitrary[Option[A]]): Arbitrary[Last[A]] =

Arbitrary { ev.arbitrary map { Last(_) } }

def arbLast[A](implicit evidence$1: cats.Eq[A], ev: org.scalacheck.Arbitrary[Option[A]]): org.scalacheck.Arbitrary[Last[A]]

scala> val rs4 = MonoidTests[Last[Int]].monoid

val rs4: cats.kernel.laws.discipline.MonoidTests[Last[Int]]#RuleSet = org.typelevel.discipline.Laws$DefaultRuleSet@7b28ea53

scala> rs4.all.check(Parameters.default)

+ monoid.associative: OK, passed 100 tests.

+ monoid.collect0: OK, passed 100 tests.

+ monoid.combine all: OK, passed 100 tests.

+ monoid.combineAllOption: OK, passed 100 tests.

....

モノイドが何なのか感じがつかめて気がする。

法則に関して

今日は法則に関して色々やった。何故法則なんているんだろうか?

法則は重要だから法則は重要である、はトートロジーだけども、 1かけらの真実も含まれている。例えば、ある土地の中ではある特定の側を車が走ることを規定した道路交通法のように、全員が従えばそれだけで便利な法則もある。

Cats や Haskell スタイルの関数型プログラミングが可能とするのは、

データ、コンテナ、実行モデルなどを抽象化させたコードを書くことだ。

この抽象化は法則で言明されたことのみを前提とするため、

抽象的なコードが正しく動作するためには全ての A: Monoid が法則を満たしている必要がある。

これを実利主義的視点と呼べる。

何らかの実利があることを受け入れたとしても、何故これら特定の法則なのかは気になる。

HaskellWiki や SPJ論文の一つに書いてあるからに決まってる。

これらを既存の実装付きの取っ掛かりとして、真似をすることができる。

これは伝統主義的視点と呼べる。

ただ、これは Hakell 特有の設計方針や制限まで受け継いでしまう危険をはらんでいる。

例えば、圏論における函手 (functor) は Functor[F] よりも広い意味を持つ用語だ。fmap は F[A] => F[B] を返す関数なので関連性がある。

Scala の map まで来ると、型推論のせいでその関係すら消えてしまう。

最終的には、僕たちの理解を数学までつなげるべきだ。 Monoid則はモノイドの数学的な定義に対応し、そこから既知のモノイドの特性の恩恵を得ることができる。 特にこれは Monoid則に関連することで、3つの法則は圏の3公理と同じもので、それはモノイドは圏の特殊形であることに由来する。

習う過程では、カーゴ・カルトから始めるのも悪くないと思う。 模倣とパターン認識を通して僕達は言語を習得してきたはずだ。

モノイドを使ったデータ構造の畳み込み

LYAHFGG:

畳み込み相性の良いデータ構造は実にたくさんあるので、

Foldable型クラスが導入されました。Functorが関数で写せるものを表すように、Foldableは畳み込みできるものを表しています。

Cats でこれに対応するものも Foldable と呼ばれている。型クラスのコントラクトも見てみよう:

/**

* Data structures that can be folded to a summary value.

*

* In the case of a collection (such as `List` or `Set`), these

* methods will fold together (combine) the values contained in the

* collection to produce a single result. Most collection types have

* `foldLeft` methods, which will usually be used by the associationed

* `Fold[_]` instance.

*

* Foldable[F] is implemented in terms of two basic methods:

*

* - `foldLeft(fa, b)(f)` eagerly folds `fa` from left-to-right.

* - `foldLazy(fa, b)(f)` lazily folds `fa` from right-to-left.

*

* Beyond these it provides many other useful methods related to

* folding over F[A] values.

*

* See: [[https://www.cs.nott.ac.uk/~gmh/fold.pdf A tutorial on the universality and expressiveness of fold]]

*/

@typeclass trait Foldable[F[_]] extends Serializable { self =>

/**

* Left associative fold on 'F' using the function 'f'.

*/

def foldLeft[A, B](fa: F[A], b: B)(f: (B, A) => B): B

/**

* Right associative lazy fold on `F` using the folding function 'f'.

*

* This method evaluates `b` lazily (in some cases it will not be

* needed), and returns a lazy value. We are using `A => Fold[B]` to

* support laziness in a stack-safe way.

*

* For more detailed information about how this method works see the

* documentation for `Fold[_]`.

*/

def foldLazy[A, B](fa: F[A], lb: Lazy[B])(f: A => Fold[B]): Lazy[B] =

Lazy(partialFold[A, B](fa)(f).complete(lb))

/**

* Low-level method that powers `foldLazy`.

*/

def partialFold[A, B](fa: F[A])(f: A => Fold[B]): Fold[B]

....

}

このように使う:

import cats._, cats.syntax.all._

Foldable[List].foldLeft(List(1, 2, 3), 1) {_ * _}

// res0: Int = 6

Foldable はいくつかの便利な関数や演算子がついてきて、型クラスを駆使している。

まずは fold。Monoid[A] が empty と combine を提供するので、これだけで畳込みをすることができる。

/**

* Fold implemented using the given Monoid[A] instance.

*/

def fold[A](fa: F[A])(implicit A: Monoid[A]): A =

foldLeft(fa, A.empty) { (acc, a) =>

A.combine(acc, a)

}

使ってみる。

Foldable[List].fold(List(1, 2, 3))(Monoid[Int])

// res1: Int = 6

関数を受け取る変種として foldMap もある。

/**

* Fold implemented by mapping `A` values into `B` and then

* combining them using the given `Monoid[B]` instance.

*/

def foldMap[A, B](fa: F[A])(f: A => B)(implicit B: Monoid[B]): B =

foldLeft(fa, B.empty) { (b, a) =>

B.combine(b, f(a))

}

標準のコレクションライブラリが foldMap を実装しないため、演算子として使える。

List(1, 2, 3).foldMap(identity)(Monoid[Int])

// res2: Int = 6

もう一つ便利なのは、これで値を newtype に変換することができることだ。

// `class Conjunction(val unwrap: Boolean) extends AnyVal` doesn't work on mdoc

class Conjunction(val unwrap: Boolean)

object Conjunction {

@inline def apply(b: Boolean): Conjunction = new Conjunction(b)

implicit val conjunctionMonoid: Monoid[Conjunction] = new Monoid[Conjunction] {

def combine(a1: Conjunction, a2: Conjunction): Conjunction =

Conjunction(a1.unwrap && a2.unwrap)

def empty: Conjunction = Conjunction(true)

}

implicit val conjunctionEq: Eq[Conjunction] = new Eq[Conjunction] {

def eqv(a1: Conjunction, a2: Conjunction): Boolean =

a1.unwrap == a2.unwrap

}

}

val x = List(true, false, true) foldMap {Conjunction(_)}

// x: Conjunction = repl.MdocSessionConjunction@5d64621e

x.unwrap

// res3: Boolean = false

Conjunction(true) と一つ一つ書きだして |+| でつなぐよりずっと楽だ。

続きはまた後で。

5日目

4日目は Semigroup と Monoid をみて、

独自のモノイドを実装した。あとは、foldMap などができる Foldable も少しかじった。

Apply.ap

今日は、更新のお知らせから。まず、3日目にみた Apply.apply だけど、

Apply.ap に改名された (戻ったとも言えるが)。 #308

Serializable な型クラスインスタンス

以前のバージョンでモノイドの法則検査を値クラスに対して行った時に Serializable

関連で失敗していた。

これは、実は Cats のせいじゃないらしいことが分かった。Cats の

gitter に行った所、Erik (@d6/@non)

が親切に僕の型クラスインスタンスが serializable じゃないのは

REPL から定義されているせいだと教えてもらった。

First を src/ 以下で定義した所、法則は普通に合格した。

Jason Zaugg (@retronym) さんの指摘によると、分散処理時に受送信両者の Cats のバージョンが完全に一致するとき以外でのシリアライゼーションをサポートするには、さらに:

- 匿名クラスの回避 (クラス名の変更を避けるため)

- 全てに

@SerialVersionUID(0L)を付ける必要がある

など他にも気をつけることがあるということだった。

FlatMap

今日はすごいHaskellたのしく学ぼうの新しい章「モナドがいっぱい」を始めることができる。

モナドはある願いを叶えるための、アプリカティブ値の自然な拡張です。その願いとは、「普通の値

aを取って文脈付きの値を返す関数に、文脈付きの値m aを渡したい」というものです。

Cats は Monad 型クラスを FlatMap と Monad という 2つの型クラスに分ける。

以下が[FlatMap の型クラスのコントラクト]だ:

@typeclass trait FlatMap[F[_]] extends Apply[F] {

def flatMap[A, B](fa: F[A])(f: A => F[B]): F[B]

def tailRecM[A, B](a: A)(f: A => F[Either[A, B]]): F[B]

....

}

FlatMap が、Applicative の弱いバージョンである Apply を拡張することに注目してほしい。これらが演算子だ:

class FlatMapOps[F[_], A](fa: F[A])(implicit F: FlatMap[F]) {

def flatMap[B](f: A => F[B]): F[B] = F.flatMap(fa)(f)

def mproduct[B](f: A => F[B]): F[(A, B)] = F.mproduct(fa)(f)

def >>=[B](f: A => F[B]): F[B] = F.flatMap(fa)(f)

def >>[B](fb: F[B]): F[B] = F.flatMap(fa)(_ => fb)

}

これは flatMap 演算子とシンボルを使ったエイリアスである >>= を導入する。他の演算子に関しては後回しにしよう。とりあえず標準ライブラリで flatMap は慣れている:

import cats._, cats.syntax.all._

(Right(3): Either[String, Int]) flatMap { x => Right(x + 1) }

// res0: Either[String, Int] = Right(value = 4)

Option から始める

本の通り、Option から始めよう。この節では Cats の型クラスを使っているのか標準ライブラリの実装なのかについてはうるさく言わないことにする。

以下がファンクターとしての Option:

"wisdom".some map { _ + "!" }

// res1: Option[String] = Some(value = "wisdom!")

none[String] map { _ + "!" }

// res2: Option[String] = None

Apply としての Option:

({(_: Int) + 3}.some) ap 3.some

// res3: Option[Int] = Some(value = 6)

none[String => String] ap "greed".some

// res4: Option[String] = None

({(_: String).toInt}.some) ap none[String]

// res5: Option[Int] = None

以下は FlatMap としての Option:

3.some flatMap { (x: Int) => (x + 1).some }

// res6: Option[Int] = Some(value = 4)

"smile".some flatMap { (x: String) => (x + " :)").some }

// res7: Option[String] = Some(value = "smile :)")

none[Int] flatMap { (x: Int) => (x + 1).some }

// res8: Option[Int] = None

none[String] flatMap { (x: String) => (x + " :)").some }

// res9: Option[String] = None

期待通り、モナディックな値が None の場合は None が返ってきた。

FlatMap則

FlatMap には結合律 (associativity) という法則がある:

- associativity:

(m flatMap f) flatMap g === m flatMap { x => f(x) flatMap {g} }

Cats の FlatMapLaws にはあと 2つ定義してある:

trait FlatMapLaws[F[_]] extends ApplyLaws[F] {

implicit override def F: FlatMap[F]

def flatMapAssociativity[A, B, C](fa: F[A], f: A => F[B], g: B => F[C]): IsEq[F[C]] =

fa.flatMap(f).flatMap(g) <-> fa.flatMap(a => f(a).flatMap(g))

def flatMapConsistentApply[A, B](fa: F[A], fab: F[A => B]): IsEq[F[B]] =

fab.ap(fa) <-> fab.flatMap(f => fa.map(f))

/**

* The composition of `cats.data.Kleisli` arrows is associative. This is

* analogous to [[flatMapAssociativity]].

*/

def kleisliAssociativity[A, B, C, D](f: A => F[B], g: B => F[C], h: C => F[D], a: A): IsEq[F[D]] = {

val (kf, kg, kh) = (Kleisli(f), Kleisli(g), Kleisli(h))

((kf andThen kg) andThen kh).run(a) <-> (kf andThen (kg andThen kh)).run(a)

}

}

Monad

先ほど Cats はモナド型クラスを FlatMap と Monad の2つに分けると書いた。

この FlatMap-Monad の関係は、Apply-Applicative の関係の相似となっている:

@typeclass trait Monad[F[_]] extends FlatMap[F] with Applicative[F] {

....

}

Monad は FlatMap に pure を付けたものだ。Haskell と違って Monad[F] は Applicative[F] を拡張するため、return と pure と名前が異なるという問題が生じていない。

綱渡り

LYAHFGG:

さて、棒の左右にとまった鳥の数の差が3以内であれば、ピエールはバランスを取れているものとしましょう。例えば、右に1羽、左に4羽の鳥がとまっているなら大丈夫。だけど左に5羽目の鳥がとまったら、ピエールはバランスを崩して飛び降りる羽目になります。

本の Pole の例題を実装してみよう。

import cats._, cats.syntax.all._

type Birds = Int

case class Pole(left: Birds, right: Birds)

Scala ではこんな風に Int に型エイリアスを付けるのは一般的じゃないと思うけど、ものは試しだ。landLeft と landRight をメソッドをとして実装したいから Pole は case class にする:

case class Pole(left: Birds, right: Birds) {

def landLeft(n: Birds): Pole = copy(left = left + n)

def landRight(n: Birds): Pole = copy(right = right + n)

}

OO の方が見栄えが良いと思う:

Pole(0, 0).landLeft(2)

// res1: Pole = Pole(left = 2, right = 0)

Pole(1, 2).landRight(1)

// res2: Pole = Pole(left = 1, right = 3)

Pole(1, 2).landRight(-1)