独習 Scalaz

これまでいくつのプログラミング言語が羊の衣を着た Lisp に喩えられただろうか? Java は馴染み親しんだ C++ のような文法に GC を持ち込んだ。それまで他にも GC を載せた言語はあったけども、現実的に C++ の代替となりうる言語に GC が載ったことは 1996年には画期的に思われた。やがて時は経ち、人々は自分でメモリ管理をしないことに慣れていった。JavaScript と Ruby の両言語もその第一級関数 (first-class function) やブロック構文を持つことから羊の衣を着た Lisp と呼ばれたことがある。S式の同図像性がマクロに適することから Lisp系の言語はまだ面白いと思う。

近年の言語はもう少し新しい関数型言語から概念を借りるようになってきた。型推論やパターンマッチングは ML にさかのぼることができると思う。時が経てば、人々はこれらの機能もまた当然と思うようになるだろう。Lisp が 1958年、ML が 1973年に発表されたことを考えると、良いアイディアが一般受けするには何十年かの時間がかかっている。その寒々しい何十年かの間、これらの言語は教義に異を唱える異端者、またはより酷く「真剣じゃない」と思われたことだろう。

別に Scalaz が次に大流行すると言っているわけじゃない。だいたい僕は Scalaz のことをまだ分かってもいない。ただ確信を持っているのはこれを使っている奴らは彼らの問題を真剣になって解いているということだ。または、残りの Scala コミュニティーがパターンマッチングを使っているのと同じぐらい学術的なことをやっている。Haskell が 1990年に発表されたことを考えると、この魔女裁判はしばらく続くだろうが、僕はオープンマインドでありたい。

リンク

- Scalaz 7.0 ベースの古い独習 Scalaz

- learning-scalaz.pdf

0日目

「(読者が) X日で学ぶ Scalaz」を書くつもりは無かった。1日目は、Scalaz 7 が milestone 7 だった 2012年の8月31日に書かれた。2日目はその次の日に書かれた。つまり、これは「(僕が) 独習」した web ログだ。だから、簡潔に最低限のことしか書かれてなかったりする。記事を書くよりも本を読みながらコードを試してみるのに時間をさいていた日もあったと思う。

いきなり詳細に飛び込む代わりに、今日は前編として導入から始めたいと思う。これは飛ばして後で読んでも構わない。

Scalaz 入門

Scalaz 入門はいくつかあるけど、僕が見た中で一番良かったのは Nick Partridge さんが Melbourne Scala Users Group で 2010年3月22日に行った Scalaz のトークだ。

Scalaz talk is up - http://bit.ly/c2eTVR Lots of code showing how/why the library exists

— Nick Partridge (@nkpart) March 28, 2010

これをネタとして使うことにする。

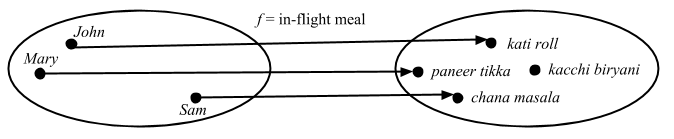

Scalaz は主に3つの部分から構成される:

- 新しいデータ型 (

Validation、NonEmptyListなど) - 標準クラスの拡張 (

OptionOps、ListOpsなど) - 実用上必要な全ての汎用関数の実装 (アドホック多相性、trait + implicit)

多相性って何?

パラメータ多相

Nick さん曰く:

この関数

headはAのリストを取ってAを返します。Aが何であるかはかまいません。Intでもいいし、Stringでもいいし、OrangeでもCarでもいいです。どのAでも動作し、存在可能な全てのAに対してこの関数は定義されています。

scala> def head[A](xs: List[A]): A = xs(0)

head: [A](xs: List[A])A

scala> head(1 :: 2 :: Nil)

res0: Int = 1

scala> case class Car(make: String)

defined class Car

scala> head(Car("Civic") :: Car("CR-V") :: Nil)

res1: Car = Car(Civic)

Haskell wiki 曰く:

パラメータ多相 (parametric polymorphism) とは、ある値の型が 1つもしくは複数の (制限の無い) 型変数を含むことを指し、その値は型変数を具象型によって置換することによって得られる型ならどれでも採用することができる。

派生型多態

ここで、型 A の 2つの値を足す plus という関数を考える:

scala> def plus[A](a1: A, a2: A): A = ???

plus: [A](a1: A, a2: A)A

型 A によって、足すことの定義を別々に提供する必要がある。これを実現する方法の一つが派生型 (subtyping) だ。

scala> trait Plus[A] {

def plus(a2: A): A

}

defined trait Plus

scala> def plus[A <: Plus[A]](a1: A, a2: A): A = a1.plus(a2)

plus: [A <: Plus[A]](a1: A, a2: A)A

これで A の型によって異なる plus の定義を提供できるようにはなった。しかし、この方法はデータ型の定義時に Plus を mixin する必要があるため柔軟性に欠ける。例えば、Int や String には使うことができない。

アドホック多相

Scala における3つ目の方法は trait への暗黙の変換か暗黙のパラメータ (implicit parameter) を使うことだ。

scala> trait Plus[A] {

def plus(a1: A, a2: A): A

}

defined trait Plus

scala> def plus[A: Plus](a1: A, a2: A): A = implicitly[Plus[A]].plus(a1, a2)

plus: [A](a1: A, a2: A)(implicit evidence$1: Plus[A])A

これは以下の意味においてまさにアドホックだと言える

- 異なる

Aの型に対して別の関数定義を提供することができる - (

Intのような) 型に対してソースコードへのアクセスが無くても関数定義を提供することができる - 異なるスコープにおいて関数定義を有効化したり無効化したりできる

この最後の点によって Scala のアドホック多相性は Haskell のそれよりもより強力なものだと言える。このトピックに関しては Debasish Ghosh さん (@debasishg) のScala Implicits: 型クラス、襲来参照。

この plus 関数をより詳しく見ていこう。

sum 関数

アドホック多相の具体例として、Int のリストを合計する簡単な関数 sum を徐々に一般化していく。

scala> def sum(xs: List[Int]): Int = xs.foldLeft(0) { _ + _ }

sum: (xs: List[Int])Int

scala> sum(List(1, 2, 3, 4))

res3: Int = 10

Monoid

これを少し一般化してみましょう。

Monoidというものを取り出します。… これは、同じ型の値を生成するmappendという関数と「ゼロ」を生成する関数を含む型です。

scala> object IntMonoid {

def mappend(a: Int, b: Int): Int = a + b

def mzero: Int = 0

}

defined module IntMonoid

これを代入することで、少し一般化されました。

scala> def sum(xs: List[Int]): Int = xs.foldLeft(IntMonoid.mzero)(IntMonoid.mappend)

sum: (xs: List[Int])Int

scala> sum(List(1, 2, 3, 4))

res5: Int = 10

次に、全ての型

AについてMonoidが定義できるように、Monoidを抽象化します。これでIntMonoidがIntのモノイドになりました。

scala> trait Monoid[A] {

def mappend(a1: A, a2: A): A

def mzero: A

}

defined trait Monoid

scala> object IntMonoid extends Monoid[Int] {

def mappend(a: Int, b: Int): Int = a + b

def mzero: Int = 0

}

defined module IntMonoid

これで sum が Int のリストと Int のモノイドを受け取って合計を計算できるようになった:

scala> def sum(xs: List[Int], m: Monoid[Int]): Int = xs.foldLeft(m.mzero)(m.mappend)

sum: (xs: List[Int], m: Monoid[Int])Int

scala> sum(List(1, 2, 3, 4), IntMonoid)

res7: Int = 10

これで

Intを使わなくなったので、全てのIntを一般型に置き換えることができます。

scala> def sum[A](xs: List[A], m: Monoid[A]): A = xs.foldLeft(m.mzero)(m.mappend)

sum: [A](xs: List[A], m: Monoid[A])A

scala> sum(List(1, 2, 3, 4), IntMonoid)

res8: Int = 10

最後の変更点は

Monoidを implicit にすることで毎回渡さなくてもいいようにすることです。

scala> def sum[A](xs: List[A])(implicit m: Monoid[A]): A = xs.foldLeft(m.mzero)(m.mappend)

sum: [A](xs: List[A])(implicit m: Monoid[A])A

scala> implicit val intMonoid = IntMonoid

intMonoid: IntMonoid.type = IntMonoid$@3387dfac

scala> sum(List(1, 2, 3, 4))

res9: Int = 10

Nick さんはやらなかったけど、この形の暗黙のパラメータは context bound で書かれることが多い:

scala> def sum[A: Monoid](xs: List[A]): A = {

val m = implicitly[Monoid[A]]

xs.foldLeft(m.mzero)(m.mappend)

}

sum: [A](xs: List[A])(implicit evidence$1: Monoid[A])A

scala> sum(List(1, 2, 3, 4))

res10: Int = 10

これでどのモノイドのリストでも合計できるようになり、

sum関数はかなり一般化されました。StringのMonoidを書くことでこれをテストすることができます。また、これらはMonoidという名前のオブジェクトに包むことにします。その理由は Scala の implicit 解決ルールです。ある型の暗黙のパラメータを探すとき、Scala はスコープ内を探しますが、それには探している型のコンパニオンオブジェクトも含まれるのです。

scala> :paste

// Entering paste mode (ctrl-D to finish)

trait Monoid[A] {

def mappend(a1: A, a2: A): A

def mzero: A

}

object Monoid {

implicit val IntMonoid: Monoid[Int] = new Monoid[Int] {

def mappend(a: Int, b: Int): Int = a + b

def mzero: Int = 0

}

implicit val StringMonoid: Monoid[String] = new Monoid[String] {

def mappend(a: String, b: String): String = a + b

def mzero: String = ""

}

}

def sum[A: Monoid](xs: List[A]): A = {

val m = implicitly[Monoid[A]]

xs.foldLeft(m.mzero)(m.mappend)

}

// Exiting paste mode, now interpreting.

defined trait Monoid

defined module Monoid

sum: [A](xs: List[A])(implicit evidence$1: Monoid[A])A

scala> sum(List("a", "b", "c"))

res12: String = abc

この関数に直接異なるモノイドを渡すこともできます。例えば、

Intの積算のモノイドのインスタンスを提供してみましょう。

scala> val multiMonoid: Monoid[Int] = new Monoid[Int] {

def mappend(a: Int, b: Int): Int = a * b

def mzero: Int = 1

}

multiMonoid: Monoid[Int] = $anon$1@48655fb6

scala> sum(List(1, 2, 3, 4))(multiMonoid)

res14: Int = 24

FoldLeft

Listに関しても一般化した関数を目指しましょう。… そのためには、foldLeft演算に関して一般化します。

scala> object FoldLeftList {

def foldLeft[A, B](xs: List[A], b: B, f: (B, A) => B) = xs.foldLeft(b)(f)

}

defined module FoldLeftList

scala> def sum[A: Monoid](xs: List[A]): A = {

val m = implicitly[Monoid[A]]

FoldLeftList.foldLeft(xs, m.mzero, m.mappend)

}

sum: [A](xs: List[A])(implicit evidence$1: Monoid[A])A

scala> sum(List(1, 2, 3, 4))

res15: Int = 10

scala> sum(List("a", "b", "c"))

res16: String = abc

scala> sum(List(1, 2, 3, 4))(multiMonoid)

res17: Int = 24

これで先ほどと同様の抽象化を行なって

FoldLeft型クラスを抜き出します。

scala> :paste

// Entering paste mode (ctrl-D to finish)

trait FoldLeft[F[_]] {

def foldLeft[A, B](xs: F[A], b: B, f: (B, A) => B): B

}

object FoldLeft {

implicit val FoldLeftList: FoldLeft[List] = new FoldLeft[List] {

def foldLeft[A, B](xs: List[A], b: B, f: (B, A) => B) = xs.foldLeft(b)(f)

}

}

def sum[M[_]: FoldLeft, A: Monoid](xs: M[A]): A = {

val m = implicitly[Monoid[A]]

val fl = implicitly[FoldLeft[M]]

fl.foldLeft(xs, m.mzero, m.mappend)

}

// Exiting paste mode, now interpreting.

warning: there were 2 feature warnings; re-run with -feature for details

defined trait FoldLeft

defined module FoldLeft

sum: [M[_], A](xs: M[A])(implicit evidence$1: FoldLeft[M], implicit evidence$2: Monoid[A])A

scala> sum(List(1, 2, 3, 4))

res20: Int = 10

scala> sum(List("a", "b", "c"))

res21: String = abc

これで Int と List の両方が sum から抜き出された。

Scalaz の型クラス

上の例における trait の Monoid と FoldLeft は Haskell の型クラスに相当する。Scalaz は多くの型クラスを提供する。

これらの型クラスの全ては必要な関数だけを含んだ部品に分けられています。ある関数が必要十分なものだけを要請するため究極のダック・タイピングだと言うこともできるでしょう。

メソッド注入 (enrich my library)

Monoidを使ってある型の 2つの値を足す関数を書いた場合、このようになります。

scala> def plus[A: Monoid](a: A, b: A): A = implicitly[Monoid[A]].mappend(a, b)

plus: [A](a: A, b: A)(implicit evidence$1: Monoid[A])A

scala> plus(3, 4)

res25: Int = 7

これに演算子を提供したい。だけど、1つの型だけを拡張するんじゃなくて、Monoid のインスタンスを持つ全ての型を拡張したい。Scalaz 7 スタイルでこれを行なってみる。

scala> trait MonoidOp[A] {

val F: Monoid[A]

val value: A

def |+|(a2: A) = F.mappend(value, a2)

}

defined trait MonoidOp

scala> implicit def toMonoidOp[A: Monoid](a: A): MonoidOp[A] = new MonoidOp[A] {

val F = implicitly[Monoid[A]]

val value = a

}

toMonoidOp: [A](a: A)(implicit evidence$1: Monoid[A])MonoidOp[A]

scala> 3 |+| 4

res26: Int = 7

scala> "a" |+| "b"

res28: String = ab

1つの定義から Int と String の両方に |+| 演算子を注入することができた。

標準型構文

同様のテクニックを使って Scalaz は Option や Boolean のような標準ライブラリ型へのメソッド注入も提供する:

scala> 1.some | 2

res0: Int = 1

scala> Some(1).getOrElse(2)

res1: Int = 1

scala> (1 > 10)? 1 | 2

res3: Int = 2

scala> if (1 > 10) 1 else 2

res4: Int = 2

これで Scalaz がどういうライブラリなのかというのを感じてもらえただろうか。

1日目

型クラス初級講座

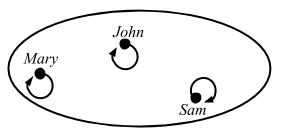

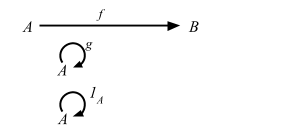

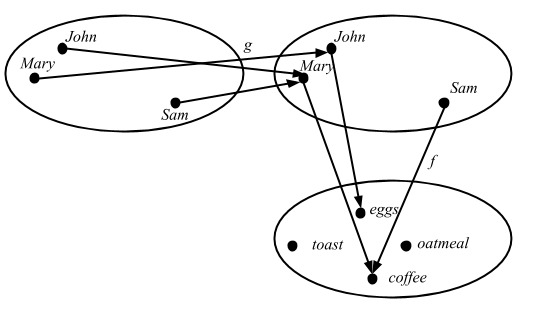

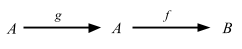

型クラスは、何らかの振る舞いを定義するインターフェイスです。ある型クラスのインスタンスである型は、その型クラスが記述する振る舞いを実装します。

Scalaz 曰く:

It provides purely functional data structures to complement those from the Scala standard library. It defines a set of foundational type classes (e.g.

Functor,Monad) and corresponding instances for a large number of data structures.

Scala 標準ライブラリを補完する純粋関数型データ構造を提供する。(

FunctorやMonadなど) 基本的な型クラスを定義し、また多くのデータ構造に対して対応するインスタンスを提供する。

Haskell をたのしく学びながら Scalaz も学べるかためしてみよう。

sbt

以下が Scalaz 7.1.0 を試すための build.sbt だ:

scalaVersion := "2.11.2"

val scalazVersion = "7.1.0"

libraryDependencies ++= Seq(

"org.scalaz" %% "scalaz-core" % scalazVersion,

"org.scalaz" %% "scalaz-effect" % scalazVersion,

"org.scalaz" %% "scalaz-typelevel" % scalazVersion,

"org.scalaz" %% "scalaz-scalacheck-binding" % scalazVersion % "test"

)

scalacOptions += "-feature"

initialCommands in console := "import scalaz._, Scalaz._"

あとは sbt 0.12.3 から REPL を開くだけだ:

$ sbt console

...

[info] downloading http://repo1.maven.org/maven2/org/scalaz/scalaz-core_2.10/7.0.5/scalaz-core_2.10-7.0.5.jar ...

import scalaz._

import Scalaz._

Welcome to Scala version 2.10.3 (Java HotSpot(TM) 64-Bit Server VM, Java 1.6.0_51).

Type in expressions to have them evaluated.

Type :help for more information.

scala>

Scalaz 7.1.0 から生成された API ドキュメントもある。

Equal

LYAHFGG:

Eqは等値性をテストできる型に使われます。Eq のインスタンスが定義すべき関数は==と/=です。

Scalaz で Eq 型クラスと同じものは Equal と呼ばれている:

scala> 1 === 1

res0: Boolean = true

scala> 1 === "foo"

<console>:14: error: could not find implicit value for parameter F0: scalaz.Equal[Object]

1 === "foo"

^

scala> 1 == "foo"

<console>:14: warning: comparing values of types Int and String using `==' will always yield false

1 == "foo"

^

res2: Boolean = false

scala> 1.some =/= 2.some

res3: Boolean = true

scala> 1 assert_=== 2

java.lang.RuntimeException: 1 ≠ 2

標準の == のかわりに、Equal は equal メソッドを宣言することで ===、=/=、と assert_=== 演算を可能とする。主な違いは Int と String と比較すると === はコンパイルに失敗することだ。

注意: 初出ではここで =/= じゃなくて /== を使っていたけども、Eiríkr Åsheim さんに以下の通り教えてもらった:

@eed3si9n hey, was reading your scalaz tutorials. you should encourage people to use =/= and not /== since the latter has bad precedence.

— Eiríkr Åsheim (@d6) September 6, 2012

/== は優先順位壊れてるから =/= を推奨すべき。

通常、!= のような比較演算子は && や通常の文字列などに比べて高い優先順位を持つ。ところが、/== は = で終わるが = で始まらないため代入演算子のための特殊ルールが発動し、優先順位の最底辺に落ちてしまう:

scala> 1 != 2 && false

res4: Boolean = false

scala> 1 /== 2 && false

<console>:14: error: value && is not a member of Int

1 /== 2 && false

^

scala> 1 =/= 2 && false

res6: Boolean = false

Order

LYAHFGG:

Ordは、何らかの順序を付けられる型のための型クラスです。Ordはすべての標準的な大小比較関数、>、<、>=、<=をサポートします。

Scalaz で Ord に対応する型クラスは Order だ:

scala> 1 > 2.0

res8: Boolean = false

scala> 1 gt 2.0

<console>:14: error: could not find implicit value for parameter F0: scalaz.Order[Any]

1 gt 2.0

^

scala> 1.0 ?|? 2.0

res10: scalaz.Ordering = LT

scala> 1.0 max 2.0

res11: Double = 2.0

Order は Ordering (LT, GT, EQ) を返す ?|? 演算を可能とする。また、order メソッドを宣言することで lt、gt、lte、gte、min、そして max 演算子を可能とする。Equal 同様 Int と Double の比較はコンパイルを失敗させる。

Show

LYAHFGG:

ある値は、その値が

Show型クラスのインスタンスになっていれば、文字列として表現できます。

Scalaz で Show に対応する型クラスは Show だ:

scala> 3.show

res14: scalaz.Cord = 3

scala> 3.shows

res15: String = 3

scala> "hello".println

"hello"

Cord というのは潜在的に長い可能性のある文字列を保持できる純粋関数型データ構造のことらしい。

Read

LYAHFGG:

ReadはShowと対をなす型クラスです。read関数は文字列を受け取り、Readのインスタンスの型の値を返します。

これは対応する Scalaz での型クラスを見つけることができなかった。

Enum

LYAHFGG:

Enumのインスタンスは、順番に並んだ型、つまり要素の値を列挙できる型です。Enum型クラスの主な利点は、その値をレンジの中で使えることです。また、Enumのインスタンスの型には後者関数succと前者関数predも定義されます。

Scalaz で Enum に対応する型クラスは Enum だ:

scala> 'a' to 'e'

res30: scala.collection.immutable.NumericRange.Inclusive[Char] = NumericRange(a, b, c, d, e)

scala> 'a' |-> 'e'

res31: List[Char] = List(a, b, c, d, e)

scala> 3 |=> 5

res32: scalaz.EphemeralStream[Int] = scalaz.EphemeralStreamFunctions$$anon$4@6a61c7b6

scala> 'B'.succ

res33: Char = C

Order 型クラスの上に pred と succ メソッドを宣言することで、標準の to のかわりに、Enum は List を返す |-> を可能とする。他にも -+-、---、from、 fromStep、pred、predx、succ、succx、|-->、|->、|==>、|=> など多くの演算があるが、全て前後にステップ移動するか範囲を返すものだ。

Bounded

Bounded型クラスのインスタンスは上限と下限を持ち、それぞれminBoundとmaxBound関数で調べることができます。

Scalaz で Bounded に対応する型クラスは再び Enum みたいだ:

scala> implicitly[Enum[Char]].min

res43: Option[Char] = Some(?)

scala> implicitly[Enum[Char]].max

res44: Option[Char] = Some( )

scala> implicitly[Enum[Double]].max

res45: Option[Double] = Some(1.7976931348623157E308)

scala> implicitly[Enum[Int]].min

res46: Option[Int] = Some(-2147483648)

scala> implicitly[Enum[(Boolean, Int, Char)]].max

<console>:14: error: could not find implicit value for parameter e: scalaz.Enum[(Boolean, Int, Char)]

implicitly[Enum[(Boolean, Int, Char)]].max

^

Enum 型クラスのインスタンスは最大値に対して Option[T] を返す。

Num

Numは数の型クラスです。このインスタンスは数のように振る舞います。

Scalaz で Num、Floating、Integral に対応する型クラスは見つけることが出来なかった。

型クラス中級講座

Haskell の文法に関しては飛ばして第8章の型や型クラスを自分で作ろう まで行こう (本を持っている人は第7章)。

信号の型クラス

data TrafficLight = Red | Yellow | Green

これを Scala で書くと:

scala> :paste

// Entering paste mode (ctrl-D to finish)

sealed trait TrafficLight

case object Red extends TrafficLight

case object Yellow extends TrafficLight

case object Green extends TrafficLight

これに Equal のインスタンスを定義する。

scala> implicit val TrafficLightEqual: Equal[TrafficLight] = Equal.equal(_ == _)

TrafficLightEqual: scalaz.Equal[TrafficLight] = scalaz.Equal$$anon$7@2457733b

使えるかな?

scala> Red === Yellow

<console>:18: error: could not find implicit value for parameter F0: scalaz.Equal[Product with Serializable with TrafficLight]

Red === Yellow

Equal が不変 (invariant) なサブタイプ Equal[F] を持つせいで、Equal[TrafficLight] が検知されないみたいだ。TrafficLight を case class にして Red と Yellow が同じ型を持つようになるけど、厳密なパターンマッチングができなくなる。#ダメじゃん

scala> :paste

// Entering paste mode (ctrl-D to finish)

case class TrafficLight(name: String)

val red = TrafficLight("red")

val yellow = TrafficLight("yellow")

val green = TrafficLight("green")

implicit val TrafficLightEqual: Equal[TrafficLight] = Equal.equal(_ == _)

red === yellow

// Exiting paste mode, now interpreting.

defined class TrafficLight

red: TrafficLight = TrafficLight(red)

yellow: TrafficLight = TrafficLight(yellow)

green: TrafficLight = TrafficLight(green)

TrafficLightEqual: scalaz.Equal[TrafficLight] = scalaz.Equal$$anon$7@42988fee

res3: Boolean = false

Yes と No の型クラス

Scalaz 流に truthy 値の型クラスを作れるか試してみよう。ただし、命名規則は我流でいく。Scalaz は Show、show、show というように 3つや 4つの異なるものに型クラスの名前を使っているため分かりづらい所があると思う。

CanBuildFrom に倣って型クラスは Can で始めて、sjson/sbinary に倣って型クラスのメソッドは動詞 + s と命名するのが僕の好みだ。yesno というのは意味不明なので、truthy と呼ぶ。ゴールは 1.truthy が true を返すことだ。この欠点は型クラスのインスタンスを CanTruthy[Int].truthys(1) のように関数として呼ぶと名前に s が付くことだ。

scala> :paste

// Entering paste mode (ctrl-D to finish)

trait CanTruthy[A] { self =>

/** @return true, if `a` is truthy. */

def truthys(a: A): Boolean

}

object CanTruthy {

def apply[A](implicit ev: CanTruthy[A]): CanTruthy[A] = ev

def truthys[A](f: A => Boolean): CanTruthy[A] = new CanTruthy[A] {

def truthys(a: A): Boolean = f(a)

}

}

trait CanTruthyOps[A] {

def self: A

implicit def F: CanTruthy[A]

final def truthy: Boolean = F.truthys(self)

}

object ToCanIsTruthyOps {

implicit def toCanIsTruthyOps[A](v: A)(implicit ev: CanTruthy[A]) =

new CanTruthyOps[A] {

def self = v

implicit def F: CanTruthy[A] = ev

}

}

// Exiting paste mode, now interpreting.

defined trait CanTruthy

defined module CanTruthy

defined trait CanTruthyOps

defined module ToCanIsTruthyOps

scala> import ToCanIsTruthyOps._

import ToCanIsTruthyOps._

Int への型クラスのインスタンスを定義する:

scala> implicit val intCanTruthy: CanTruthy[Int] = CanTruthy.truthys({

case 0 => false

case _ => true

})

intCanTruthy: CanTruthy[Int] = CanTruthy$$anon$1@71780051

scala> 10.truthy

res6: Boolean = true

次が List[A]:

scala> implicit def listCanTruthy[A]: CanTruthy[List[A]] = CanTruthy.truthys({

case Nil => false

case _ => true

})

listCanTruthy: [A]=> CanTruthy[List[A]]

scala> List("foo").truthy

res7: Boolean = true

scala> Nil.truthy

<console>:23: error: could not find implicit value for parameter ev: CanTruthy[scala.collection.immutable.Nil.type]

Nil.truthy

またしても不変な型パラメータのせいで Nil を特殊扱いしなくてはいけない。

scala> implicit val nilCanTruthy: CanTruthy[scala.collection.immutable.Nil.type] = CanTruthy.truthys(_ => false)

nilCanTruthy: CanTruthy[collection.immutable.Nil.type] = CanTruthy$$anon$1@1e5f0fd7

scala> Nil.truthy

res8: Boolean = false

Boolean は identity を使える:

scala> implicit val booleanCanTruthy: CanTruthy[Boolean] = CanTruthy.truthys(identity)

booleanCanTruthy: CanTruthy[Boolean] = CanTruthy$$anon$1@334b4cb

scala> false.truthy

res11: Boolean = false

LYAHFGG 同様に CanTruthy 型クラスを使って truthyIf を定義しよう:

では、

ifの真似をしてYesNo値を取る関数を作ってみましょう。

名前渡しを使って渡された引数の評価を遅延する:

scala> :paste

// Entering paste mode (ctrl-D to finish)

def truthyIf[A: CanTruthy, B, C](cond: A)(ifyes: => B)(ifno: => C) =

if (cond.truthy) ifyes

else ifno

// Exiting paste mode, now interpreting.

truthyIf: [A, B, C](cond: A)(ifyes: => B)(ifno: => C)(implicit evidence$1: CanTruthy[A])Any

使用例はこうなる:

scala> truthyIf (Nil) {"YEAH!"} {"NO!"}

res12: Any = NO!

scala> truthyIf (2 :: 3 :: 4 :: Nil) {"YEAH!"} {"NO!"}

res13: Any = YEAH!

scala> truthyIf (true) {"YEAH!"} {"NO!"}

res14: Any = YEAH!

続きはまたあとで。

2日目

昨日はすごいHaskellたのしく学ぼう を頼りに Equal などの Scalaz の型クラスを見てきた。

Functor

LYAHFGG:

今度は、

Functor(ファンクター)という型クラスを見ていきたいと思います。Functorは、全体を写せる (map over) ものの型クラスです。

本のとおり、実装がどうなってるかをみてみよう:

trait Functor[F[_]] { self =>

/** Lift `f` into `F` and apply to `F[A]`. */

def map[A, B](fa: F[A])(f: A => B): F[B]

...

}

これが可能とする演算子はこうなっている:

trait FunctorOps[F[_],A] extends Ops[F[A]] {

implicit def F: Functor[F]

////

import Leibniz.===

final def map[B](f: A => B): F[B] = F.map(self)(f)

...

}

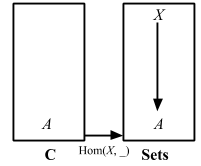

つまり、これは関数 A => B を受け取り F[B] を返す map メソッドを宣言する。コレクションの map メソッドなら得意なものだ。

scala> List(1, 2, 3) map {_ + 1}

res15: List[Int] = List(2, 3, 4)

Scalaz は Tuple などにも Functor のインスタンスを定義している。

scala> (1, 2, 3) map {_ + 1}

res28: (Int, Int, Int) = (1,2,4)

この演算は Tuple の最後の値のみに適用されていることに注意。詳細は scalaz group での議論を参照。

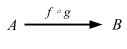

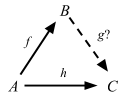

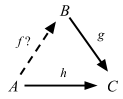

Functor としての関数

Scalaz は Function1 に対する Functor のインスタンスも定義する。

scala> ((x: Int) => x + 1) map {_ * 7}

res30: Int => Int = <function1>

scala> res30(3)

res31: Int = 28

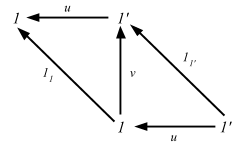

これは興味深い。つまり、map は関数を合成する方法を与えてくれるが、順番が f compose g とは逆順だ。通りで Scalaz は map のエイリアスとして ∘ を提供するわけだ。Function1 のもう1つのとらえ方は、定義域 (domain) から値域 (range) への無限の写像だと考えることができる。入出力に関しては飛ばして Functors, Applicative Functors and Monoids へ行こう (本だと、「ファンクターからアプリカティブファンクターへ」)。

ファンクターとしての関数 …

ならば、型

fmap :: (a -> b) -> (r -> a) -> (r -> b)が意味するものとは?この型は、aからbへの関数と、rからaへの関数を引数に受け取り、rからbへの関数を返す、と読めます。何か思い出しませんか?そう!関数合成です!

あ、すごい Haskell も僕がさっき言ったように関数合成をしているという結論になったみたいだ。ちょっと待てよ。

ghci> fmap (*3) (+100) 1

303

ghci> (*3) . (+100) $ 1

303

Haskell では fmap は f compose g を同じ順序で動作してるみたいだ。Scala でも同じ数字を使って確かめてみる:

scala> (((_: Int) * 3) map {_ + 100}) (1)

res40: Int = 103

何かがおかしい。fmap の宣言と Scalaz の map 演算子を比べてみよう:

fmap :: (a -> b) -> f a -> f b

そしてこれが Scalaz:

final def map[B](f: A => B): F[B] = F.map(self)(f)

順番が完全に違っている。ここでの map は F[A] に注入されたメソッドのため、投射される側のデータ構造が最初に来て、次に関数が来る。List で考えると分かりやすい:

ghci> fmap (*3) [1, 2, 3]

[3,6,9]

で

scala> List(1, 2, 3) map {3*}

res41: List[Int] = List(3, 6, 9)

ここでも順番が逆なことが分かる。

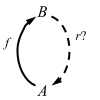

fmapも、関数とファンクター値を取ってファンクター値を返す 2 引数関数と思えますが、そうじゃなくて、関数を取って「元の関数に似てるけどファンクター値を取ってファンクター値を返す関数」を返す関数だと思うこともできます。fmapは、関数a -> bを取って、関数f a -> f bを返すのです。こういう操作を、関数の持ち上げ (lifting) といいます。

ghci> :t fmap (*2)

fmap (*2) :: (Num a, Functor f) => f a -> f a

ghci> :t fmap (replicate 3)

fmap (replicate 3) :: (Functor f) => f a -> f [a]

この関数の持ち上げ (lifting) は是非やってみたい。Functor の型クラス内に色々便利な関数が定義されていて、その中の 1つに lift がある:

scala> Functor[List].lift {(_: Int) * 2}

res45: List[Int] => List[Int] = <function1>

scala> res45(List(3))

res47: List[Int] = List(6)

Functor は他にもデータ構造の中身を書きかえる >|、as、fpair、strengthL、strengthR、そして void などの演算子を可能とする:

scala> List(1, 2, 3) >| "x"

res47: List[String] = List(x, x, x)

scala> List(1, 2, 3) as "x"

res48: List[String] = List(x, x, x)

scala> List(1, 2, 3).fpair

res49: List[(Int, Int)] = List((1,1), (2,2), (3,3))

scala> List(1, 2, 3).strengthL("x")

res50: List[(String, Int)] = List((x,1), (x,2), (x,3))

scala> List(1, 2, 3).strengthR("x")

res51: List[(Int, String)] = List((1,x), (2,x), (3,x))

scala> List(1, 2, 3).void

res52: List[Unit] = List((), (), ())

Applicative

LYAHFGG:

ここまではファンクター値を写すために、もっぱら 1 引数関数を使ってきました。では、2 引数関数でファンクターを写すと何が起こるでしょう?

scala> List(1, 2, 3, 4) map {(_: Int) * (_:Int)}

<console>:14: error: type mismatch;

found : (Int, Int) => Int

required: Int => ?

List(1, 2, 3, 4) map {(_: Int) * (_:Int)}

^

おっと。これはカリー化する必要がある:

scala> List(1, 2, 3, 4) map {(_: Int) * (_:Int)}.curried

res11: List[Int => Int] = List(<function1>, <function1>, <function1>, <function1>)

scala> res11 map {_(9)}

res12: List[Int] = List(9, 18, 27, 36)

LYAHFGG:

Control.Applicativeモジュールにある型クラスApplicativeに会いに行きましょう!型クラスApplicativeは、2つの関数pureと<*>を定義しています。

Scalaz の Applicative のコントラクトも見てみよう:

trait Applicative[F[_]] extends Apply[F] { self =>

def point[A](a: => A): F[A]

/** alias for `point` */

def pure[A](a: => A): F[A] = point(a)

...

}

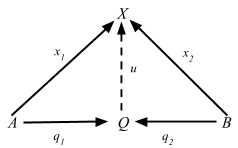

Applicative は別の型クラス Apply を継承し、それ自身も point とそのエイリアス pure を導入する。

LYAHFGG:

pureは任意の型の引数を受け取り、それをアプリカティブ値の中に入れて返します。 … アプリカティブ値は「箱」というよりも「文脈」と考えるほうが正確かもしれません。pureは、値を引数に取り、その値を何らかのデフォルトの文脈(元の値を再現できるような最小限の文脈)に置くのです。

Scalaz は pure のかわりに point という名前が好きみたいだ。見たところ A の値を受け取り F[A] を返すコンストラクタみたいだ。これは演算子こそは導入しないけど、全てのデータ型に point メソッドとシンボルを使ったエイリアス η を導入する。

scala> 1.point[List]

res14: List[Int] = List(1)

scala> 1.point[Option]

res15: Option[Int] = Some(1)

scala> 1.point[Option] map {_ + 2}

res16: Option[Int] = Some(3)

scala> 1.point[List] map {_ + 2}

res17: List[Int] = List(3)

ちょっとうまく説明できないけど、コンストラクタが抽象化されているのは何か可能性を感じるものがある。

Apply

LYAHFGG:

<*>はfmapの強化版なのです。fmapが普通の関数とファンクター値を引数に取って、関数をファンクター値の中の値に適用してくれるのに対し、<*>は関数の入っているファンクター値と値の入っているファンクター値を引数に取って、1つ目のファンクターの中身である関数を2つ目のファンクターの中身に適用するのです。

trait Apply[F[_]] extends Functor[F] { self =>

def ap[A,B](fa: => F[A])(f: => F[A => B]): F[B]

}

ap を使って Apply は <*>、*>、<* 演算子を可能とする。

scala> 9.some <*> {(_: Int) + 3}.some

res20: Option[Int] = Some(12)

期待通りだ。

*> と <* は左辺項か右辺項のみ返すバリエーションだ。

scala> 1.some <* 2.some

res35: Option[Int] = Some(1)

scala> none <* 2.some

res36: Option[Nothing] = None

scala> 1.some *> 2.some

res38: Option[Int] = Some(2)

scala> none *> 2.some

res39: Option[Int] = None

Apply としての Option

<*> を使えばいい。

scala> 9.some <*> {(_: Int) + 3}.some

res57: Option[Int] = Some(12)

scala> 3.some <*> { 9.some <*> {(_: Int) + (_: Int)}.curried.some }

res58: Option[Int] = Some(12)

Applicative Style

もう 1つ見つけたのが、コンテナから値だけを抽出して 1つの関数を適用する新記法だ:

scala> ^(3.some, 5.some) {_ + _}

res59: Option[Int] = Some(8)

scala> ^(3.some, none[Int]) {_ + _}

res60: Option[Int] = None

これは 1関数の場合はいちいちコンテナに入れなくてもいいから便利そうだ。これは推測だけど、これのお陰で Scalaz 7 は Applicative そのものでは何も演算子を導入していないんだと思う。実際どうなのかはともかく、Pointed も <$> もいらないみたいだ。

だけど、^(f1, f2) {...} スタイルに問題が無いわけではない。どうやら Function1、Writer、Validation のような 2つの型パラメータを取る Applicative を処理できないようだ。もう 1つ Applicative Builder という Scalaz 6 から使われていたらしい方法がある。 M3 で deprecated になったけど、^(f1, f2) {...} の問題のため、近い将来名誉挽回となるらしい。

こう使う:

scala> (3.some |@| 5.some) {_ + _}

res18: Option[Int] = Some(8)

今の所は |@| スタイルを使おう。

Apply としての List

LYAHFGG:

リスト(正確に言えばリスト型のコンストラクタ

[])もアプリカティブファンクターです。意外ですか?

<*> と |@| が使えるかみてみよう:

scala> List(1, 2, 3) <*> List((_: Int) * 0, (_: Int) + 100, (x: Int) => x * x)

res61: List[Int] = List(0, 0, 0, 101, 102, 103, 1, 4, 9)

scala> List(3, 4) <*> { List(1, 2) <*> List({(_: Int) + (_: Int)}.curried, {(_: Int) * (_: Int)}.curried) }

res62: List[Int] = List(4, 5, 5, 6, 3, 4, 6, 8)

scala> (List("ha", "heh", "hmm") |@| List("?", "!", ".")) {_ + _}

res63: List[String] = List(ha?, ha!, ha., heh?, heh!, heh., hmm?, hmm!, hmm.)

Zip List

LYAHFGG:

ところが、

[(+3),(*2)] <*> [1,2]の挙動は、左辺の1つ目の関数を右辺の1つ目の値に適用し、左辺の2つ目の関数を右辺の2つ目の値に適用する、というのではまずいのでしょうか?それなら結果は[4,4]になるはずです。これは[1 + 3, 2 * 2]と考えることもできます。

これは Scalaz で書けるけど、簡単ではない。

scala> streamZipApplicative.ap(Tags.Zip(Stream(1, 2))) (Tags.Zip(Stream({(_: Int) + 3}, {(_: Int) * 2})))

res32: scala.collection.immutable.Stream[Int] with Object{type Tag = scalaz.Tags.Zip} = Stream(4, ?)

scala> res32.toList

res33: List[Int] = List(4, 4)

Tagged type を使った例は明日また詳しく説明する。

Applicative の便利な関数

LYAHFGG:

Control.ApplicativeにはliftA2という、以下のような型を持つ関数があります。

liftA2 :: (Applicative f) => (a -> b -> c) -> f a -> f b -> f c .

Apply[F].lift2 というものがある:

scala> Apply[Option].lift2((_: Int) :: (_: List[Int]))

res66: (Option[Int], Option[List[Int]]) => Option[List[Int]] = <function2>

scala> res66(3.some, List(4).some)

res67: Option[List[Int]] = Some(List(3, 4))

LYAHFGG:

では、「アプリカティブ値のリスト」を取って「リストを返り値として持つ1つのアプリカティブ値」を返す関数を実装してみましょう。これを

sequenceAと呼ぶことにします。

sequenceA :: (Applicative f) => [f a] -> f [a]

sequenceA [] = pure []

sequenceA (x:xs) = (:) <$> x <*> sequenceA xs

これを Scalaz でも実装できるか試してみよう!

scala> def sequenceA[F[_]: Applicative, A](list: List[F[A]]): F[List[A]] = list match {

case Nil => (Nil: List[A]).point[F]

case x :: xs => (x |@| sequenceA(xs)) {_ :: _}

}

sequenceA: [F[_], A](list: List[F[A]])(implicit evidence$1: scalaz.Applicative[F])F[List[A]]

テストしてみよう:

scala> sequenceA(List(1.some, 2.some))

res82: Option[List[Int]] = Some(List(1, 2))

scala> sequenceA(List(3.some, none, 1.some))

res85: Option[List[Int]] = None

scala> sequenceA(List(List(1, 2, 3), List(4, 5, 6)))

res86: List[List[Int]] = List(List(1, 4), List(1, 5), List(1, 6), List(2, 4), List(2, 5), List(2, 6), List(3, 4), List(3, 5), List(3, 6))

正しい答えが得られた。興味深いのは結局 Pointed が必要になったことと、sequenceA が型クラスに関してジェネリックなことだ。

Function1 の片側が Int に固定された例は、残念ながら黒魔術を召喚する必要がある。

scala> type Function1Int[A] = ({type l[A]=Function1[Int, A]})#l[A]

defined type alias Function1Int

scala> sequenceA(List((_: Int) + 3, (_: Int) + 2, (_: Int) + 1): List[Function1Int[Int]])

res1: Int => List[Int] = <function1>

scala> res1(3)

res2: List[Int] = List(6, 5, 4)

結構長くなったけど、ここまでたどり着けて良かったと思う。続きはまたあとで。

3日目

昨日は map 演算子を加える Functor から始めて、Pointed[F].point や Applicative な ^(f1, f2) {_ :: _} 構文を使った多態的な関数 sequenceA にたどり着いた。

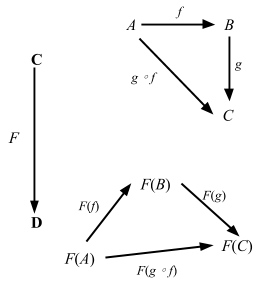

型を司るもの、カインド

型や型クラスを自分で作ろう の節で昨日のうちにカバーしておくべきだったけどしなかったのはカインドと型の話だ。Scalaz の理解には関係無いだろうと思ってたけど、関係あるので、座って聞いて欲しい。

型とは、値について何らかの推論をするために付いている小さなラベルです。そして、型にも小さなラベルが付いているんです。その名は種類 (kind)。 … 種類とはそもそも何者で、何の役に立つのでしょう?さっそく GHCi の

:kコマンドを使って、型の種類を調べてみましょう。

Scala 2.10 時点では Scala REPL に :k コマンドが無かったので、ひとつ書いてみた: kind.scala。

scala/scala#2340 を送ってくれた George Leontiev さん (@folone) その他の協力もあって、Scala 2.11 より :kind コマンドは標準機能として取り込まれた。使ってみよう:

scala> :k Int

scala.Int's kind is A

scala> :k -v Int

scala.Int's kind is A

*

プロパーな型だ。

scala> :k -v Option

scala.Option's kind is F[+A]

* -(+)-> *

型コンストラクタ: 1階カインド型だ。

scala> :k -v Either

scala.util.Either's kind is F[+A1,+A2]

* -(+)-> * -(+)-> *

型コンストラクタ: 1階カインド型だ。

scala> :k -v Equal

scalaz.Equal's kind is F[A]

* -> *

型コンストラクタ: 1階カインド型だ。

scala> :k -v Functor

scalaz.Functor's kind is X[F[A]]

(* -> *) -> *

型コンストラクタを受け取る型コンストラクタ: 高カインド型だ。

上から順番に。Int と他の全ての値を作ることのできる型はプロパーな型と呼ばれ * というシンボルで表記される (「型」と読む)。これは値レベルだと 1 に相当する。Scala の型変数構文を用いるとこれは A と書ける。

1階値、つまり (_: Int) + 3 のような値コンストラクタ、は普通関数と呼ばれる。同様に、1階カインド型はプロパーな型になるために他の型を受け取る型のことだ。これは普通型コンストラクタと呼ばれる。Option、Either、Equal などは全て1階カインドだ。これらが他の型を受け取ることを表記するのにカリー化した表記法を用いて * -> * や * -> * -> * などと書く。このとき Option[Int] は * で、Option が * -> * であることに注意。Scala の型変数構文を用いるとこれらは F[+A]、 F[+A1,+A2] となる。

(f: Int => Int, list: List[Int]) => list map {f} のような高階値、つまり関数を受け取る関数、は普通高階関数と呼ばれる。同様に、高カインド型は型コンストラクタを受け取る型コンストラクタだ。これは多分高カインド型コンストラクタと呼ばれるべきだが、その名前は使われていない。これらは (* -> *) -> * と表記される。Scala の型変数構文を用いるとこれは X[F[A]] と書ける。

Scalaz 7.1 の場合、Equal その他は F[A] のカインドを持ち、Functor とその派生型は X[F[A]]カインドを持つ。

Scala は型クラスという概念を型コンストラクタを用いてエンコード (悪く言うとコンプレクト) するため、この辺の用語が混乱しやすいことがある。例えば、データ構造である List は函手 (functor) となるという言い方をして、これは List に対して Functor[List] のインスタンスを導き出せるという意味だ。List に対するインスタンスなんて一つしか無いのが分かってるので、「List は函手である (List is a functor)」と言うことができる。 is-a に関する議論は以下も参照:

In FP, "is-a" means "an instance can be derived from." @jimduey #CPL14 It's a provable relationship, not reliant on LSP.

— Jessica Kerr (@jessitron) February 25, 2014List そのものは F[+A] なので、F が函手に関連すると覚えるのは簡単だ。しかし、型クラス定義の Functor は F[A] を囲む必要があるので、カインドは X[F[A]] となっている。さらにこれを混乱させるのが、Scala から型コンストラクタを第一級変数として扱えることが目新しかったため、コンパイラは 1階カインド型でも「高カインド型」と呼んでいることだ:

scala> trait Test {

type F[_]

}

<console>:14: warning: higher-kinded type should be enabled

by making the implicit value scala.language.higherKinds visible.

This can be achieved by adding the import clause 'import scala.language.higherKinds'

or by setting the compiler option -language:higherKinds.

See the Scala docs for value scala.language.higherKinds for a discussion

why the feature should be explicitly enabled.

type F[_]

^

注入された演算子を使っているぶんにはこれらの心配をする必要はないはずだ:

scala> List(1, 2, 3).shows

res11: String = [1,2,3]

だけど Show[A].shows を使いたければ、これが Show[List[Int]] であって Show[List] ではないことを理解している必要がある。同様に、関数を持ち上げ (lift) たければ Functor[F] (F は Functor の F) だと知っている必要がある:

scala> Functor[List[Int]].lift((_: Int) + 2)

<console>:14: error: List[Int] takes no type parameters, expected: one

Functor[List[Int]].lift((_: Int) + 2)

^

scala> Functor[List].lift((_: Int) + 2)

res13: List[Int] => List[Int] = <function1>

チートシート を始めたとき、Scalaz 7 のソースコードに合わせて Equal[F] と書いた。すると Adam Rosien さんに Equal[A] と表記すべきと指摘された。

@eed3si9n love the scalaz cheat sheet start, but using the type param F usually means Functor, what about A instead?

— Adam Rosien (@arosien) September 1, 2012

これで理由がよく分かった!

Tagged type

「すごいHaskellたのしく学ぼう」の本を持ってるひとは新しい章に進める。モノイドだ。ウェブサイトを読んでるひとは Functors, Applicative Functors and Monoids の続きだ。

LYAHFGG:

Haskell の newtype キーワードは、まさにこのような「1つの型を取り、それを何かにくるんで別の型に見せかけたい」という場合のために作られたものです。

これは Haskell の言語レベルでの機能なので、Scala に移植するのは無理なんじゃないかと思うと思う。

ところが、約1年前 (2011年9月) Miles Sabin さん (@milessabin) が gist を書き、それを Tagged と名付け、Jason Zaugg さん (@retronym) が @@ という型エイリアスを加えた。

type Tagged[U] = { type Tag = U }

type @@[T, U] = T with Tagged[U]

これについて読んでみたいひとは Eric Torreborre さん (@etorreborre) が Practical uses for Unboxed Tagged Types、それから Tim Perrett さん (@timperrett) が Unboxed new types within Scalaz7 を書いている。

例えば、体積をキログラムで表現したいとする。kg は国際的な標準単位だからだ。普通は Double を渡して終わる話だけど、それだと他の Double の値と区別が付かない。case class は使えるだろうか?

case class KiloGram(value: Double)

型安全性は加わったけど、使うたびに x.value というふうに値を取り出さなきゃいけないのが不便だ。Tagged type 登場。

scala> sealed trait KiloGram

defined trait KiloGram

scala> def KiloGram[A](a: A): A @@ KiloGram = Tag[A, KiloGram](a)

KiloGram: [A](a: A)scalaz.@@[A,KiloGram]

scala> val mass = KiloGram(20.0)

mass: scalaz.@@[Double,KiloGram] = 20.0

scala> 2 * Tag.unwrap(mass) // this doesn't work on REPL

res2: Double = 40.0

scala> 2 * Tag.unwrap(mass)

<console>:17: error: wrong number of type parameters for method unwrap$mDc$sp: [T](a: Object{type Tag = T; type Self = Double})Double

2 * Tag.unwrap(mass)

^

scala> 2 * scalaz.Tag.unsubst[Double, Id, KiloGram](mass)

res2: Double = 40.0

以前は 2 * mass と書けたけども Scalaz 7.1 以降は明示的にタグを unwrap しなければいけなくなった。さらに REPL のバグ

SI-8871

のせいで、Tag.unwrap が動作しないため、Tag.unsubst を使う必要があった。

補足しておくと、A @@ KiloGram は scalaz.@@[A, KiloGram] の中置記法だ。これで相対論的エネルギーを計算する関数を定義できる。

scala> sealed trait JoulePerKiloGram

defined trait JoulePerKiloGram

scala> def JoulePerKiloGram[A](a: A): A @@ JoulePerKiloGram = Tag[A, JoulePerKiloGram](a)

JoulePerKiloGram: [A](a: A)scalaz.@@[A,JoulePerKiloGram]

scala> def energyR(m: Double @@ KiloGram): Double @@ JoulePerKiloGram =

JoulePerKiloGram(299792458.0 * 299792458.0 * Tag.unsubst[Double, Id, KiloGram](m))

energyR: (m: scalaz.@@[Double,KiloGram])scalaz.@@[Double,JoulePerKiloGram]

scala> energyR(mass)

res4: scalaz.@@[Double,JoulePerKiloGram] = 1.79751035747363533E18

scala> energyR(10.0)

<console>:18: error: type mismatch;

found : Double(10.0)

required: scalaz.@@[Double,KiloGram]

(which expands to) AnyRef{type Tag = KiloGram; type Self = Double}

energyR(10.0)

^

見ての通り、素の Double を energyR に渡すとコンパイル時に失敗する。これは newtype そっくりだけど、Int @@ KiloGram など定義できるからより強力だと言える。

Monoid について

LYAHFGG:

どうやら、

*に1という組み合わせと、++に[]という組み合わせは、共通の性質を持っているようですね。

- 関数は引数を2つ取る。

- 2つの引数および返り値の型はすべて等しい。

- 2引数関数を施して相手を変えないような特殊な値が存在する。

これを Scala で確かめてみる:

scala> 4 * 1

res16: Int = 4

scala> 1 * 9

res17: Int = 9

scala> List(1, 2, 3) ++ Nil

res18: List[Int] = List(1, 2, 3)

scala> Nil ++ List(0.5, 2.5)

res19: List[Double] = List(0.5, 2.5)

あってるみたいだ。

LYAHFGG:

例えば、

(3 * 4) * 5も3 * (4 * 5)も、答は60です。++についてもこの性質は成り立ちます。 … この性質を結合的 (associativity) と呼びます。演算*と++は結合的であると言います。結合的でない演算の例は-です。

これも確かめよう:

scala> (3 * 2) * (8 * 5) assert_=== 3 * (2 * (8 * 5))

scala> List("la") ++ (List("di") ++ List("da")) assert_=== (List("la") ++ List("di")) ++ List("da")

エラーがないから等価ということだ。これを monoid と言うらしい。

Monoid

LYAHFGG:

モノイドは、結合的な二項演算子(2引数関数)と、その演算に関する単位元からなる構造です。

Scalaz の Monoid の型クラスのコントラクトを見てみよう:

trait Monoid[A] extends Semigroup[A] { self =>

////

/** The identity element for `append`. */

def zero: A

...

}

Semigroup

Monoid は Semigroup を継承するみたいなのでその型クラスも見てみる。

trait Semigroup[A] { self =>

def append(a1: A, a2: => A): A

...

}

これが演算子だ:

trait SemigroupOps[A] extends Ops[A] {

final def |+|(other: => A): A = A.append(self, other)

final def mappend(other: => A): A = A.append(self, other)

final def ⊹(other: => A): A = A.append(self, other)

}

mappend 演算子とシンボルを使ったエイリアス |+| と ⊹ を導入する。

LYAHFGG:

次は

mappendです。これは、お察しのとおり、モノイド固有の二項演算です。mappendは同じ型の引数を2つ取り、その型の別の値を返します。

すごい Haskell は名前が mappend だからといって、* の場合のように必ずしも何かを追加 (append) してるわけじゃないと注意している。これを使ってみよう:

scala> List(1, 2, 3) mappend List(4, 5, 6)

res23: List[Int] = List(1, 2, 3, 4, 5, 6)

scala> "one" mappend "two"

res25: String = onetwo

|+| を使うのが Scalaz では一般的みたいだ:

scala> List(1, 2, 3) |+| List(4, 5, 6)

res26: List[Int] = List(1, 2, 3, 4, 5, 6)

scala> "one" |+| "two"

res27: String = onetwo

より簡潔にみえる。

Monoid に戻る

trait Monoid[A] extends Semigroup[A] { self =>

////

/** The identity element for `append`. */

def zero: A

...

}

LYAHFGG:

memptyは、そのモノイドの単位元を表わします。

これは Scalaz では zero と呼ばれている。

scala> Monoid[List[Int]].zero

res15: List[Int] = List()

scala> Monoid[String].zero

res16: String = ""

Tags.Multiplication

LYAHFGG:

さて、数をモノイドにする2つの方法は、どちらも素晴らしく優劣つけがたいように思えます。一体どちらを選べまよいのでしょう?実は、1つだけ選ぶ必要はないのです。

これが Scalaz 7.1 での Tagged type の出番だ。最初から定義済みのタグは Tags にある。8つのタグが Monoid 用で、1つ Zip という名前のタグが Applicative 用にある。(もしかしてこれが昨日見つけられなかった Zip List?)

scala> Tags.Multiplication(10) |+| Monoid[Int @@ Tags.Multiplication].zero

res21: scalaz.@@[Int,scalaz.Tags.Multiplication] = 10

よし! |+| を使って数字を掛けることができた。加算には普通の Int を使う。

scala> 10 |+| Monoid[Int].zero

res22: Int = 10

Tags.Disjunction and Tags.Conjunction

LYAHFGG:

モノイドにする方法が2通りあって、どちらも捨てがたいような型は、

Num a以外にもあります。Boolです。1つ目の方法は||をモノイド演算とし、Falseを単位元とする方法です。 …BoolをMonoidのインスタンスにするもう1つの方法は、Anyのいわば真逆です。&&をモノイド演算とし、Trueを単位元とする方法です。

Scalaz 7 でこれらはそれぞれ Boolean @@ Tags.Disjunction、Boolean @@ Tags.Conjunction と呼ばれている。

scala> Tags.Disjunction(true) |+| Tags.Disjunction(false)

res28: scalaz.@@[Boolean,scalaz.Tags.Disjunction] = true

scala> Monoid[Boolean @@ Tags.Disjunction].zero |+| Tags.Disjunction(true)

res29: scalaz.@@[Boolean,scalaz.Tags.Disjunction] = true

scala> Monoid[Boolean @@ Tags.Disjunction].zero |+| Monoid[Boolean @@ Tags.Disjunction].zero

res30: scalaz.@@[Boolean,scalaz.Tags.Disjunction] = false

scala> Monoid[Boolean @@ Tags.Conjunction].zero |+| Tags.Conjunction(true)

res31: scalaz.@@[Boolean,scalaz.Tags.Conjunction] = true

scala> Monoid[Boolean @@ Tags.Conjunction].zero |+| Tags.Conjunction(false)

res32: scalaz.@@[Boolean,scalaz.Tags.Conjunction] = false

Monoid としての Ordering

LYAHFGG:

Orderingの場合、モノイドを見抜くのはちょっと難しいです。しかしOrderingのMonoidインスタンスは、分かってみれば今までのモノイドと同じくごく自然な定義で、しかも便利なんです。

ちょっと変わっているが、確かめてみよう。

scala> Ordering.LT |+| Ordering.GT

<console>:14: error: value |+| is not a member of object scalaz.Ordering.LT

Ordering.LT |+| Ordering.GT

^

scala> (Ordering.LT: Ordering) |+| (Ordering.GT: Ordering)

res42: scalaz.Ordering = LT

scala> (Ordering.GT: Ordering) |+| (Ordering.LT: Ordering)

res43: scalaz.Ordering = GT

scala> Monoid[Ordering].zero |+| (Ordering.LT: Ordering)

res44: scalaz.Ordering = LT

scala> Monoid[Ordering].zero |+| (Ordering.GT: Ordering)

res45: scalaz.Ordering = GT

LYAHFGG:

では、このモノイドはどういうときに便利なのでしょう?例えば、2つの文字列を引数に取り、その長さを比較して

Orderingを返す関数を書きたいとしましょう。だたし、2つの文字列の長さが等しいときは、直ちにEQを返すのではなくて、2つの文字列の辞書順比較することとします。

Ordering.EQ 以外の場合は左辺の比較が保存されるため、これを使って2つのレベルの比較を合成することができる。Scalaz を使って lengthCompare を実装してみよう:

scala> def lengthCompare(lhs: String, rhs: String): Ordering =

(lhs.length ?|? rhs.length) |+| (lhs ?|? rhs)

lengthCompare: (lhs: String, rhs: String)scalaz.Ordering

scala> lengthCompare("zen", "ants")

res46: scalaz.Ordering = LT

scala> lengthCompare("zen", "ant")

res47: scalaz.Ordering = GT

合ってる。“zen” は “ants” より短いため LT が返ってきた。

他にも Monoid があるけど、今日はこれでおしまいにしよう。また後でここから続ける。

4日目

昨日は、カインドと型について考え、Tagged type を探検して、さまざまな型の 2項演算を抽象化する方法としての Semigroup と Monoid をみてみた。

Jason Zaugg にもコメントをもらった:

This might be a good point to pause and discuss the laws by which a well behaved type class instance must abide.

この辺りで一度立ち止まって、行儀の良い型クラスが従うべき法則についても議論すべきじゃないですか。

すごいHaskellたのしく学ぼうの型クラスの法則に関しては全て飛ばしてきたところを、パトカーに止められた形だ。恥ずかしい限りだ。

Functor則

LYAHFGG:

すべてのファンクターの性質や挙動は、ある一定の法則に従うことになっています。 … ファンクターの第一法則は、「

idでファンクター値を写した場合、ファンクター値が変化してはいけない」というものです。

言い換えると、

scala> List(1, 2, 3) map {identity} assert_=== List(1, 2, 3)

第二法則は、2つの関数

fとgについて、「fとgの合成関数でファンクター値を写したもの」と、「まずg、次にfでファンクター値を写したもの」が等しいことを要求します。

言い換えると、

scala> (List(1, 2, 3) map {{(_: Int) * 3} map {(_: Int) + 1}}) assert_=== (List(1, 2, 3) map {(_: Int) * 3} map {(_: Int) + 1})

これらの法則は Functor の実装者が従うべき法則で、コンパイラはチェックしてくれない。Scalaz 7 にはコードでこれを記述した FunctorLaw trait が入っている:

trait FunctorLaw {

/** The identity function, lifted, is a no-op. */

def identity[A](fa: F[A])(implicit FA: Equal[F[A]]): Boolean = FA.equal(map(fa)(x => x), fa)

/**

* A series of maps may be freely rewritten as a single map on a

* composed function.

*/

def associative[A, B, C](fa: F[A], f1: A => B, f2: B => C)(implicit FC: Equal[F[C]]): Boolean = FC.equal(map(map(fa)(f1))(f2), map(fa)(f2 compose f1))

}

それだけじゃなく、これらを任意の値でテストする ScalaCheck へのバインディングもついてきてる。以下が REPL からこれを実行するための build.sbt だ:

scalaVersion := "2.11.2"

val scalazVersion = "7.1.0"

libraryDependencies ++= Seq(

"org.scalaz" %% "scalaz-core" % scalazVersion,

"org.scalaz" %% "scalaz-effect" % scalazVersion,

"org.scalaz" %% "scalaz-typelevel" % scalazVersion,

"org.scalaz" %% "scalaz-scalacheck-binding" % scalazVersion % "test"

)

scalacOptions += "-feature"

initialCommands in console := "import scalaz._, Scalaz._"

initialCommands in console in Test := "import scalaz._, Scalaz._, scalacheck.ScalazProperties._, scalacheck.ScalazArbitrary._,scalacheck.ScalaCheckBinding._"

通常の sbt console のかわりに、sbt test:console を実行する:

$ sbt test:console

[info] Starting scala interpreter...

[info]

import scalaz._

import Scalaz._

import scalacheck.ScalazProperties._

import scalacheck.ScalazArbitrary._

import scalacheck.ScalaCheckBinding._

Welcome to Scala version 2.10.3 (Java HotSpot(TM) 64-Bit Server VM, Java 1.6.0_45).

Type in expressions to have them evaluated.

Type :help for more information.

scala>

List が Functor則を満たすかテストしてる:

scala> functor.laws[List].check

+ functor.identity: OK, passed 100 tests.

+ functor.associative: OK, passed 100 tests.

法則を破る

本にあわせて、法則を破ってみよう:

scala> :paste

// Entering paste mode (ctrl-D to finish)

sealed trait COption[+A] {}

case class CSome[A](counter: Int, a: A) extends COption[A]

case object CNone extends COption[Nothing]

implicit def coptionEqual[A]: Equal[COption[A]] = Equal.equalA

implicit val coptionFunctor = new Functor[COption] {

def map[A, B](fa: COption[A])(f: A => B): COption[B] = fa match {

case CNone => CNone

case CSome(c, a) => CSome(c + 1, f(a))

}

}

// Exiting paste mode, now interpreting.

defined trait COption

defined class CSome

defined module CNone

coptionEqual: [A]=> scalaz.Equal[COption[A]]

coptionFunctor: scalaz.Functor[COption] = $anon$1@42538425

scala> (CSome(0, "ho"): COption[String]) map {(_: String) + "ha"}

res4: COption[String] = CSome(1,hoha)

scala> (CSome(0, "ho"): COption[String]) map {identity}

res5: COption[String] = CSome(1,ho)

これは最初の法則を破っている。検知できるかみてみよう。

scala> functor.laws[COption].check

<console>:26: error: could not find implicit value for parameter af: org.scalacheck.Arbitrary[COption[Int]]

functor.laws[COption].check

^

COption[A] の「任意」の値を暗黙に提供しなきゃいけないみたいだ:

scala> import org.scalacheck.{Gen, Arbitrary}

import org.scalacheck.{Gen, Arbitrary}

scala> implicit def COptionArbiterary[A](implicit a: Arbitrary[A]): Arbitrary[COption[A]] =

a map { a => (CSome(0, a): COption[A]) }

COptionArbiterary: [A](implicit a: org.scalacheck.Arbitrary[A])org.scalacheck.Arbitrary[COption[A]]

これは面白い。ScalaCheck そのものは map メソッドを提供しないけど、Scalaz が Functor[Arbitrary] として注入している! あまりぱっとしない任意の COption だけど、ScalaCheck をよく知らないのでこれでいいとする。

scala> functor.laws[COption].check

! functor.identity: Falsified after 0 passed tests.

> ARG_0: CSome(0,-170856004)

! functor.associative: Falsified after 0 passed tests.

> ARG_0: CSome(0,1)

> ARG_1: <function1>

> ARG_2: <function1>

期待通りテストは失敗した。

Applicative則

これが Applicative則だ:

trait ApplicativeLaw extends FunctorLaw {

def identityAp[A](fa: F[A])(implicit FA: Equal[F[A]]): Boolean =

FA.equal(ap(fa)(point((a: A) => a)), fa)

def composition[A, B, C](fbc: F[B => C], fab: F[A => B], fa: F[A])(implicit FC: Equal[F[C]]) =

FC.equal(ap(ap(fa)(fab))(fbc), ap(fa)(ap(fab)(ap(fbc)(point((bc: B => C) => (ab: A => B) => bc compose ab)))))

def homomorphism[A, B](ab: A => B, a: A)(implicit FB: Equal[F[B]]): Boolean =

FB.equal(ap(point(a))(point(ab)), point(ab(a)))

def interchange[A, B](f: F[A => B], a: A)(implicit FB: Equal[F[B]]): Boolean =

FB.equal(ap(point(a))(f), ap(f)(point((f: A => B) => f(a))))

}

LYAHFGG も詳細は飛ばしているので、僕も見逃してもらう。

Semigroup則

これが、Semigroup則だ:

/**

* A semigroup in type F must satisfy two laws:

*

* - '''closure''': `∀ a, b in F, append(a, b)` is also in `F`. This is enforced by the type system.

* - '''associativity''': `∀ a, b, c` in `F`, the equation `append(append(a, b), c) = append(a, append(b , c))` holds.

*/

trait SemigroupLaw {

def associative(f1: F, f2: F, f3: F)(implicit F: Equal[F]): Boolean =

F.equal(append(f1, append(f2, f3)), append(append(f1, f2), f3))

}

1 * (2 * 3) と (1 * 2) * 3 が満たされるべきで、これは結合律 (associative) と呼ばれるのは覚えているよね。

scala> semigroup.laws[Int @@ Tags.Multiplication].check

+ semigroup.associative: OK, passed 100 tests.

Monoid則

これが Monoid則 だ:

/**

* Monoid instances must satisfy [[scalaz.Semigroup.SemigroupLaw]] and 2 additional laws:

*

* - '''left identity''': `forall a. append(zero, a) == a`

* - '''right identity''' : `forall a. append(a, zero) == a`

*/

trait MonoidLaw extends SemigroupLaw {

def leftIdentity(a: F)(implicit F: Equal[F]) = F.equal(a, append(zero, a))

def rightIdentity(a: F)(implicit F: Equal[F]) = F.equal(a, append(a, zero))

}

この法則は簡単だ。単位元 (identity value) を左右のどちらに |+| (mappend) しても同じ値が返ってくるということだ。乗算で確認:

scala> 1 * 2 assert_=== 2

scala> 2 * 1 assert_=== 2

Scalaz で書くと:

scala> (Monoid[Int @@ Tags.Multiplication].zero |+| Tags.Multiplication(2): Int) assert_=== 2

scala> (Tags.Multiplication(2) |+| Monoid[Int @@ Tags.Multiplication].zero: Int) assert_=== 2

scala> monoid.laws[Int @@ Tags.Multiplication].check

+ monoid.semigroup.associative: OK, passed 100 tests.

+ monoid.left identity: OK, passed 100 tests.

+ monoid.right identity: OK, passed 100 tests.

Monoid としての Option

LYAHFGG:

Maybe aをモノイドにする1つ目の方法は、型引数aがモノイドであるときに限りMaybe aもモノイドであるとし、Maybe aのmappendを、Justの中身のmappendを使って定義することです。

Scalaz がこうなっているか確認しよう。std/Option.scala 参照:

implicit def optionMonoid[A: Semigroup]: Monoid[Option[A]] = new Monoid[Option[A]] {

def append(f1: Option[A], f2: => Option[A]) = (f1, f2) match {

case (Some(a1), Some(a2)) => Some(Semigroup[A].append(a1, a2))

case (Some(a1), None) => f1

case (None, Some(a2)) => f2

case (None, None) => None

}

def zero: Option[A] = None

}

実装はシンプルで良い感じだ。Context bound の A: Semigroup は A が |+| をサポートしなければいけないと言っている。残りはパターンマッチングだ。本の言うとおりの振る舞いだ。

scala> (none: Option[String]) |+| "andy".some

res23: Option[String] = Some(andy)

scala> (Ordering.LT: Ordering).some |+| none

res25: Option[scalaz.Ordering] = Some(LT)

ちゃんと動く。

LYAHFGG:

中身がモノイドがどうか分からない状態では、

mappendは使えません。どうすればいいでしょう? 1つの選択は、第一引数を返して第二引数は捨てる、と決めておくことです。この用途のためにFirst aというものが存在します。

Haskell は newtype を使って First 型コンストラクタを実装している。Scalaz 7 は強力な Tagged type を使っている:

scala> Tags.First('a'.some) |+| Tags.First('b'.some)

res26: scalaz.@@[Option[Char],scalaz.Tags.First] = Some(a)

scala> Tags.First(none: Option[Char]) |+| Tags.First('b'.some)

res27: scalaz.@@[Option[Char],scalaz.Tags.First] = Some(b)

scala> Tags.First('a'.some) |+| Tags.First(none: Option[Char])

res28: scalaz.@@[Option[Char],scalaz.Tags.First] = Some(a)

LYAHFGG:

逆に、2つの

Justをmappendしたときに後のほうの引数を優先するようなMaybe aが欲しい、という人のために、Data.MonoidにはLast a型も用意されています。

これは Tags.Last だ:

scala> Tags.Last('a'.some) |+| Tags.Last('b'.some)

res29: scalaz.@@[Option[Char],scalaz.Tags.Last] = Some(b)

scala> Tags.Last(none: Option[Char]) |+| Tags.Last('b'.some)

res30: scalaz.@@[Option[Char],scalaz.Tags.Last] = Some(b)

scala> Tags.Last('a'.some) |+| Tags.Last(none: Option[Char])

res31: scalaz.@@[Option[Char],scalaz.Tags.Last] = Some(a)

Foldable

LYAHFGG:

畳み込み相性の良いデータ構造は実にたくさんあるので、

Foldable型クラスが導入されました。Functorが関数で写せるものを表すように、Foldableは畳み込みできるものを表しています。

Scalaz でこれに対応するものも Foldable と呼ばれている。型クラスのコントラクトも見てみよう:

trait Foldable[F[_]] { self =>

/** Map each element of the structure to a [[scalaz.Monoid]], and combine the results. */

def foldMap[A,B](fa: F[A])(f: A => B)(implicit F: Monoid[B]): B

/**Right-associative fold of a structure. */

def foldRight[A, B](fa: F[A], z: => B)(f: (A, => B) => B): B

...

}

演算子はこれだ:

/** Wraps a value `self` and provides methods related to `Foldable` */

trait FoldableOps[F[_],A] extends Ops[F[A]] {

implicit def F: Foldable[F]

////

final def foldMap[B: Monoid](f: A => B = (a: A) => a): B = F.foldMap(self)(f)

final def foldRight[B](z: => B)(f: (A, => B) => B): B = F.foldRight(self, z)(f)

final def foldLeft[B](z: B)(f: (B, A) => B): B = F.foldLeft(self, z)(f)

final def foldRightM[G[_], B](z: => B)(f: (A, => B) => G[B])(implicit M: Monad[G]): G[B] = F.foldRightM(self, z)(f)

final def foldLeftM[G[_], B](z: B)(f: (B, A) => G[B])(implicit M: Monad[G]): G[B] = F.foldLeftM(self, z)(f)

final def foldr[B](z: => B)(f: A => (=> B) => B): B = F.foldr(self, z)(f)

final def foldl[B](z: B)(f: B => A => B): B = F.foldl(self, z)(f)

final def foldrM[G[_], B](z: => B)(f: A => ( => B) => G[B])(implicit M: Monad[G]): G[B] = F.foldrM(self, z)(f)

final def foldlM[G[_], B](z: B)(f: B => A => G[B])(implicit M: Monad[G]): G[B] = F.foldlM(self, z)(f)

final def foldr1(f: (A, => A) => A): Option[A] = F.foldr1(self)(f)

final def foldl1(f: (A, A) => A): Option[A] = F.foldl1(self)(f)

final def sumr(implicit A: Monoid[A]): A = F.foldRight(self, A.zero)(A.append)

final def suml(implicit A: Monoid[A]): A = F.foldLeft(self, A.zero)(A.append(_, _))

final def toList: List[A] = F.toList(self)

final def toIndexedSeq: IndexedSeq[A] = F.toIndexedSeq(self)

final def toSet: Set[A] = F.toSet(self)

final def toStream: Stream[A] = F.toStream(self)

final def all(p: A => Boolean): Boolean = F.all(self)(p)

final def ∀(p: A => Boolean): Boolean = F.all(self)(p)

final def allM[G[_]: Monad](p: A => G[Boolean]): G[Boolean] = F.allM(self)(p)

final def anyM[G[_]: Monad](p: A => G[Boolean]): G[Boolean] = F.anyM(self)(p)

final def any(p: A => Boolean): Boolean = F.any(self)(p)

final def ∃(p: A => Boolean): Boolean = F.any(self)(p)

final def count: Int = F.count(self)

final def maximum(implicit A: Order[A]): Option[A] = F.maximum(self)

final def minimum(implicit A: Order[A]): Option[A] = F.minimum(self)

final def longDigits(implicit d: A <:< Digit): Long = F.longDigits(self)

final def empty: Boolean = F.empty(self)

final def element(a: A)(implicit A: Equal[A]): Boolean = F.element(self, a)

final def splitWith(p: A => Boolean): List[List[A]] = F.splitWith(self)(p)

final def selectSplit(p: A => Boolean): List[List[A]] = F.selectSplit(self)(p)

final def collapse[X[_]](implicit A: ApplicativePlus[X]): X[A] = F.collapse(self)

final def concatenate(implicit A: Monoid[A]): A = F.fold(self)

final def traverse_[M[_]:Applicative](f: A => M[Unit]): M[Unit] = F.traverse_(self)(f)

////

}

これはスゴい。コレクションライブラリさながらだけど、Order などの型クラスを駆使している。畳込みをやってみよう:

scala> List(1, 2, 3).foldRight (1) {_ * _}

res49: Int = 6

scala> 9.some.foldLeft(2) {_ + _}

res50: Int = 11

これらは標準ライブラリにも入っている。foldMap 演算子も試してみよう。Monoid[A] が zero と |+| を提供するから、畳込みに十分な情報がある。Foldable がいつも Monoid を持っているとは限らないので、[B: Monoid] である A => B 関数が必要だ:

scala> List(1, 2, 3) foldMap {identity}

res53: Int = 6

scala> List(true, false, true, true) foldMap {Tags.Disjunction.apply}

res56: scalaz.@@[Boolean,scalaz.Tags.Disjunction] = true

Tags.Disjunction(true) と一つ一つ書きだして |+| でつなぐよりずっと楽だ。

続きはまた後で。今週は出張なので、ちょっとペースは落ちるかも。

5日目

4日目は Functor則などのモナドの規則をみて、ScalaCheck を用いて任意の型クラスの例を使って検証した。また、Option を Monoid として扱う3つの方法や foldMap などを行う Foldable もみた。

モナドがいっぱい

今日はすごいHaskellたのしく学ぼうの新しい章「モナドがいっぱい」を始めることができる。

モナドはある願いを叶えるための、アプリカティブ値の自然な拡張です。その願いとは、「普通の値

aを取って文脈付きの値を返す関数に、文脈付きの値m aを渡したい」というものです。

Scalaz でもモナドは Monad と呼ばれている。型クラスのコントラクトはこれだ:

trait Monad[F[_]] extends Applicative[F] with Bind[F] { self =>

////

}

これは Applicative と Bind を拡張する。Bind を見てみよう。

Bind

以下が Bind のコントラクトだ:

trait Bind[F[_]] extends Apply[F] { self =>

/** Equivalent to `join(map(fa)(f))`. */

def bind[A, B](fa: F[A])(f: A => F[B]): F[B]

}

そして、以下が演算子:

/** Wraps a value `self` and provides methods related to `Bind` */

trait BindOps[F[_],A] extends Ops[F[A]] {

implicit def F: Bind[F]

////

import Liskov.<~<

def flatMap[B](f: A => F[B]) = F.bind(self)(f)

def >>=[B](f: A => F[B]) = F.bind(self)(f)

def ∗[B](f: A => F[B]) = F.bind(self)(f)

def join[B](implicit ev: A <~< F[B]): F[B] = F.bind(self)(ev(_))

def μ[B](implicit ev: A <~< F[B]): F[B] = F.bind(self)(ev(_))

def >>[B](b: F[B]): F[B] = F.bind(self)(_ => b)

def ifM[B](ifTrue: => F[B], ifFalse: => F[B])(implicit ev: A <~< Boolean): F[B] = {

val value: F[Boolean] = Liskov.co[F, A, Boolean](ev)(self)

F.ifM(value, ifTrue, ifFalse)

}

////

}

flatMap 演算子とシンボルを使ったエイリアス >>= と ∗ を導入する。他の演算子に関しては後回しにしよう。とりあえず標準ライブラリで flatMap は慣れている:

scala> 3.some flatMap { x => (x + 1).some }

res2: Option[Int] = Some(4)

scala> (none: Option[Int]) flatMap { x => (x + 1).some }

res3: Option[Int] = None

Monad

Monad に戻ろう:

trait Monad[F[_]] extends Applicative[F] with Bind[F] { self =>

////

}

Haskell と違って Monad[F[_]] は Applicative[F[_]] を継承するため、return と pure と名前が異なるという問題が生じていない。両者とも point だ。

scala> Monad[Option].point("WHAT")

res5: Option[String] = Some(WHAT)

scala> 9.some flatMap { x => Monad[Option].point(x * 10) }

res6: Option[Int] = Some(90)

scala> (none: Option[Int]) flatMap { x => Monad[Option].point(x * 10) }

res7: Option[Int] = None

綱渡り

LYAHFGG:

さて、棒の左右にとまった鳥の数の差が3以内であれば、ピエールはバランスを取れているものとしましょう。例えば、右に1羽、左に4羽の鳥がとまっているなら大丈夫。だけど左に5羽目の鳥がとまったら、ピエールはバランスを崩して飛び降りる羽目になります。

本の Pole の例題を実装してみよう。

scala> type Birds = Int

defined type alias Birds

scala> case class Pole(left: Birds, right: Birds)

defined class Pole

Scala ではこんな風に Int に型エイリアスを付けるのは一般的じゃないと思うけど、ものは試しだ。landLeft と landRight をメソッドをとして実装したいから Pole は case class にする。

scala> case class Pole(left: Birds, right: Birds) {

def landLeft(n: Birds): Pole = copy(left = left + n)

def landRight(n: Birds): Pole = copy(right = right + n)

}

defined class Pole

OO の方が見栄えが良いと思う:

scala> Pole(0, 0).landLeft(2)

res10: Pole = Pole(2,0)

scala> Pole(1, 2).landRight(1)

res11: Pole = Pole(1,3)

scala> Pole(1, 2).landRight(-1)

res12: Pole = Pole(1,1)

チェインも可能:

scala> Pole(0, 0).landLeft(1).landRight(1).landLeft(2)

res13: Pole = Pole(3,1)

scala> Pole(0, 0).landLeft(1).landRight(4).landLeft(-1).landRight(-2)

res15: Pole = Pole(0,2)

本が言うとおり、中間値で失敗しても計算が続行してしまっている。失敗を Option[Pole] で表現しよう:

scala> case class Pole(left: Birds, right: Birds) {

def landLeft(n: Birds): Option[Pole] =

if (math.abs((left + n) - right) < 4) copy(left = left + n).some

else none

def landRight(n: Birds): Option[Pole] =

if (math.abs(left - (right + n)) < 4) copy(right = right + n).some

else none

}

defined class Pole

scala> Pole(0, 0).landLeft(2)

res16: Option[Pole] = Some(Pole(2,0))

scala> Pole(0, 3).landLeft(10)

res17: Option[Pole] = None

flatMap を使ってチェインする:

scala> Pole(0, 0).landRight(1) flatMap {_.landLeft(2)}

res18: Option[Pole] = Some(Pole(2,1))

scala> (none: Option[Pole]) flatMap {_.landLeft(2)}

res19: Option[Pole] = None

scala> Monad[Option].point(Pole(0, 0)) flatMap {_.landRight(2)} flatMap {_.landLeft(2)} flatMap {_.landRight(2)}

res21: Option[Pole] = Some(Pole(2,4))

初期値を Option コンテキストから始めるために Monad[Option].point(...) が使われていることに注意。>>= エイリアスも使うと見た目がモナディックになる:

scala> Monad[Option].point(Pole(0, 0)) >>= {_.landRight(2)} >>= {_.landLeft(2)} >>= {_.landRight(2)}

res22: Option[Pole] = Some(Pole(2,4))

モナディックチェインが綱渡りのシミュレーションを改善したか確かめる:

scala> Monad[Option].point(Pole(0, 0)) >>= {_.landLeft(1)} >>= {_.landRight(4)} >>= {_.landLeft(-1)} >>= {_.landRight(-2)}

res23: Option[Pole] = None

うまくいった。

ロープの上のバナナ

LYAHFGG:

さて、今度はバランス棒にとまっている鳥の数によらず、いきなりピエールを滑らせて落っことす関数を作ってみましょう。この関数を

bananaと呼ぶことにします。

以下が常に失敗する banana だ:

scala> case class Pole(left: Birds, right: Birds) {

def landLeft(n: Birds): Option[Pole] =

if (math.abs((left + n) - right) < 4) copy(left = left + n).some

else none

def landRight(n: Birds): Option[Pole] =

if (math.abs(left - (right + n)) < 4) copy(right = right + n).some

else none

def banana: Option[Pole] = none

}

defined class Pole

scala> Monad[Option].point(Pole(0, 0)) >>= {_.landLeft(1)} >>= {_.banana} >>= {_.landRight(1)}

res24: Option[Pole] = None

LYAHFGG:

ところで、入力に関係なく既定のモナド値を返す関数だったら、自作せずとも

>>関数を使うという手があります。

以下が >> の Option での振る舞い:

scala> (none: Option[Int]) >> 3.some

res25: Option[Int] = None

scala> 3.some >> 4.some

res26: Option[Int] = Some(4)

scala> 3.some >> (none: Option[Int])

res27: Option[Int] = None

banana を >> (none: Option[Pole]) に置き換えてみよう:

scala> Monad[Option].point(Pole(0, 0)) >>= {_.landLeft(1)} >> (none: Option[Pole]) >>= {_.landRight(1)}

<console>:26: error: missing parameter type for expanded function ((x$1) => x$1.landLeft(1))

Monad[Option].point(Pole(0, 0)) >>= {_.landLeft(1)} >> (none: Option[Pole]) >>= {_.landRight(1)}

^

突然型推論が崩れてしまった。問題の原因はおそらく演算子の優先順位にある。 Programming in Scala 曰く:

The one exception to the precedence rule, alluded to above, concerns assignment operators, which end in an equals character. If an operator ends in an equals character (

=), and the operator is not one of the comparison operators<=,>=,==, or!=, then the precedence of the operator is the same as that of simple assignment (=). That is, it is lower than the precedence of any other operator.

注意: 上記の記述は不完全だ。代入演算子ルールのもう1つの例外は演算子が === のように (=) から始まる場合だ。

>>= (bind) が等号で終わるため、優先順位は最下位に落とされ、({_.landLeft(1)} >> (none: Option[Pole])) が先に評価される。いくつかの気が進まない回避方法がある。まず、普通のメソッド呼び出しのようにドットと括弧の記法を使うことができる:

scala> Monad[Option].point(Pole(0, 0)).>>=({_.landLeft(1)}).>>(none: Option[Pole]).>>=({_.landRight(1)})

res9: Option[Pole] = None

もしくは優先順位の問題に気付いたなら、適切な場所に括弧を置くことができる:

scala> (Monad[Option].point(Pole(0, 0)) >>= {_.landLeft(1)}) >> (none: Option[Pole]) >>= {_.landRight(1)}

res10: Option[Pole] = None

両方とも正しい答が得られた。ちなみに、>>= を flatMap に変えても >> の方がまだ優先順位が高いため問題は解決しない。

for 構文

LYAHFGG:

Haskell にとってモナドはとても便利なので、モナド専用構文まで用意されています。その名は

do記法。

まずは入れ子のラムダ式を書いてみよう:

scala> 3.some >>= { x => "!".some >>= { y => (x.shows + y).some } }

res14: Option[String] = Some(3!)

>>= が使われたことで計算のどの部分も失敗することができる:

scala> 3.some >>= { x => (none: Option[String]) >>= { y => (x.shows + y).some } }

res17: Option[String] = None

scala> (none: Option[Int]) >>= { x => "!".some >>= { y => (x.shows + y).some } }

res16: Option[String] = None

scala> 3.some >>= { x => "!".some >>= { y => (none: Option[String]) } }

res18: Option[String] = None

Haskell の do 記法のかわりに、Scala には for 構文があり、これらは同じものだ:

scala> for {

x <- 3.some

y <- "!".some

} yield (x.shows + y)

res19: Option[String] = Some(3!)

LYAHFGG:

do式は、let行を除いてすべてモナド値で構成されます。

これも Scala の for 構文に当てはまると思う。

帰ってきたピエール

LYAHFGG:

ピエールの綱渡りの動作も、もちろん

do記法で書けます。

scala> def routine: Option[Pole] =

for {

start <- Monad[Option].point(Pole(0, 0))

first <- start.landLeft(2)

second <- first.landRight(2)

third <- second.landLeft(1)

} yield third

routine: Option[Pole]

scala> routine

res20: Option[Pole] = Some(Pole(3,2))

yield は Option[Pole] じゃなくて Pole を受け取るため、third も抽出する必要があった。

LYAHFGG:

ピエールにバナナの皮を踏ませたい場合、

do記法ではこう書きます。

scala> def routine: Option[Pole] =

for {

start <- Monad[Option].point(Pole(0, 0))

first <- start.landLeft(2)

_ <- (none: Option[Pole])

second <- first.landRight(2)

third <- second.landLeft(1)

} yield third

routine: Option[Pole]

scala> routine

res23: Option[Pole] = None

パターンマッチングと失敗

LYAHFGG:

do記法でモナド値を変数名に束縛するときには、let式や関数の引数のときと同様、パターンマッチが使えます。

scala> def justH: Option[Char] =

for {

(x :: xs) <- "hello".toList.some

} yield x

justH: Option[Char]

scala> justH

res25: Option[Char] = Some(h)

do式の中でパターンマッチが失敗した場合、Monad型クラスの一員であるfail関数が使われるので、異常終了という形ではなく、そのモナドの文脈に合った形で失敗を処理できます。

scala> def wopwop: Option[Char] =

for {

(x :: xs) <- "".toList.some

} yield x

wopwop: Option[Char]

scala> wopwop

res28: Option[Char] = None

失敗したパターンマッチングは None を返している。これは for 構文の興味深い一面で、今まで考えたことがなかったが、言われるとなるほどと思う。

List モナド

LYAHFGG:

一方、

[3,8,9]のような値は複数の計算結果を含んでいるとも、複数の候補値を同時に重ね合わせたような1つの値であるとも解釈できます。リストをアプリカティブ・スタイルで使うと、非決定性を表現していることがはっきりします。

まずは Applicative としての List を復習する:

scala> ^(List(1, 2, 3), List(10, 100, 100)) {_ * _}

res29: List[Int] = List(10, 100, 100, 20, 200, 200, 30, 300, 300)

それでは、非決定的値を関数に食わせてみましょう。

scala> List(3, 4, 5) >>= {x => List(x, -x)}

res30: List[Int] = List(3, -3, 4, -4, 5, -5)

モナディックな視点に立つと、List というコンテキストは複数の解がありうる数学的な値を表す。それ以外は、for を使って List を操作するなどは素の Scala と変わらない:

scala> for {

n <- List(1, 2)

ch <- List('a', 'b')

} yield (n, ch)

res33: List[(Int, Char)] = List((1,a), (1,b), (2,a), (2,b))

MonadPlus と guard 関数

Scala の for 構文はフィルタリングができる:

scala> for {

x <- 1 |-> 50 if x.shows contains '7'

} yield x

res40: List[Int] = List(7, 17, 27, 37, 47)

LYAHFGG:

MonadPlusは、モノイドの性質をあわせ持つモナドを表す型クラスです。

以下が MonadPlus の型クラスのコントラクトだ:

trait MonadPlus[F[_]] extends Monad[F] with ApplicativePlus[F] { self =>

...

}

Plus、PlusEmpty、と ApplicativePlus

これは ApplicativePlus を継承している:

trait ApplicativePlus[F[_]] extends Applicative[F] with PlusEmpty[F] { self =>

...

}

そして、それは PlusEmpty を継承している:

trait PlusEmpty[F[_]] extends Plus[F] { self =>

////

def empty[A]: F[A]

}

そして、それは Plus を継承している:

trait Plus[F[_]] { self =>

def plus[A](a: F[A], b: => F[A]): F[A]

}

Semigroup[A] と Monoid[A] 同様に、Plus[F[_]] と PlusEmpty[F[_]] はそれらのインスタンスが plus と empty を実装することを要請する。違いはこれが型コンストラクタ (F[_]) レベルであることだ。

Plus は 2つのコンテナを連結する <+> 演算子を導入する:

scala> List(1, 2, 3) <+> List(4, 5, 6)

res43: List[Int] = List(1, 2, 3, 4, 5, 6)

MonadPlus 再び

MonadPlus は filter 演算を導入する。

scala> (1 |-> 50) filter { x => x.shows contains '7' }

res46: List[Int] = List(7, 17, 27, 37, 47)

騎士の旅

LYAHFGG:

ここで、非決定性計算を使って解くのにうってつけの問題をご紹介しましょう。チェス盤の上にナイトの駒が1つだけ乗っています。ナイトを3回動かして特定のマスまで移動させられるか、というのが問題です。

ペアに型エイリアスと付けるかわりにまた case class にしよう:

scala> case class KnightPos(c: Int, r: Int)

defined class KnightPos

以下がナイトの次に取りうる位置を全て計算する関数だ:

scala> case class KnightPos(c: Int, r: Int) {

def move: List[KnightPos] =

for {

KnightPos(c2, r2) <- List(KnightPos(c + 2, r - 1), KnightPos(c + 2, r + 1),

KnightPos(c - 2, r - 1), KnightPos(c - 2, r + 1),

KnightPos(c + 1, r - 2), KnightPos(c + 1, r + 2),

KnightPos(c - 1, r - 2), KnightPos(c - 1, r + 2)) if (

((1 |-> 8) contains c2) && ((1 |-> 8) contains r2))

} yield KnightPos(c2, r2)

}

defined class KnightPos

scala> KnightPos(6, 2).move

res50: List[KnightPos] = List(KnightPos(8,1), KnightPos(8,3), KnightPos(4,1), KnightPos(4,3), KnightPos(7,4), KnightPos(5,4))

scala> KnightPos(8, 1).move

res51: List[KnightPos] = List(KnightPos(6,2), KnightPos(7,3))

答は合ってるみたいだ。次に、3回のチェインを実装する:

scala> case class KnightPos(c: Int, r: Int) {

def move: List[KnightPos] =

for {

KnightPos(c2, r2) <- List(KnightPos(c + 2, r - 1), KnightPos(c + 2, r + 1),

KnightPos(c - 2, r - 1), KnightPos(c - 2, r + 1),

KnightPos(c + 1, r - 2), KnightPos(c + 1, r + 2),

KnightPos(c - 1, r - 2), KnightPos(c - 1, r + 2)) if (

((1 |-> 8) element c2) && ((1 |-> 8) contains r2))

} yield KnightPos(c2, r2)

def in3: List[KnightPos] =

for {

first <- move

second <- first.move

third <- second.move

} yield third

def canReachIn3(end: KnightPos): Boolean = in3 contains end

}

defined class KnightPos

scala> KnightPos(6, 2) canReachIn3 KnightPos(6, 1)

res56: Boolean = true

scala> KnightPos(6, 2) canReachIn3 KnightPos(7, 3)

res57: Boolean = false

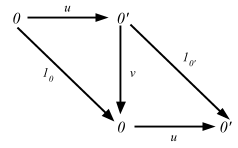

Monad則

左単位元

LYAHFGG:

第一のモナド則が言っているのは、

returnを使って値をデフォルトの文脈に入れたものを>>=を使って関数に食わせた結果は、単にその値にその関数を適用した結果と等しくなりなさい、ということです。

これを Scala で表現すると、

// (Monad[F].point(x) flatMap {f}) assert_=== f(x)

scala> (Monad[Option].point(3) >>= { x => (x + 100000).some }) assert_=== 3 |> { x => (x + 100000).some }

右単位元

モナドの第二法則は、

>>=を使ってモナド値をreturnに食わせた結果は、元のモナド値と不変であると言っています。

// (m forMap {Monad[F].point(_)}) assert_=== m

scala> ("move on up".some flatMap {Monad[Option].point(_)}) assert_=== "move on up".some

結合律

最後のモナド則は、

>>=を使ったモナド関数適用の連鎖があるときに、どの順序で評価しても結果は同じであるべき、というものです。

// (m flatMap f) flatMap g assert_=== m flatMap { x => f(x) flatMap {g} }

scala> Monad[Option].point(Pole(0, 0)) >>= {_.landRight(2)} >>= {_.landLeft(2)} >>= {_.landRight(2)}

res76: Option[Pole] = Some(Pole(2,4))

scala> Monad[Option].point(Pole(0, 0)) >>= { x =>

x.landRight(2) >>= { y =>

y.landLeft(2) >>= { z =>

z.landRight(2)

}}}

res77: Option[Pole] = Some(Pole(2,4))

Scalaz 7 はモナド則を以下のように表現する:

trait MonadLaw extends ApplicativeLaw {

/** Lifted `point` is a no-op. */

def rightIdentity[A](a: F[A])(implicit FA: Equal[F[A]]): Boolean = FA.equal(bind(a)(point(_: A)), a)

/** Lifted `f` applied to pure `a` is just `f(a)`. */

def leftIdentity[A, B](a: A, f: A => F[B])(implicit FB: Equal[F[B]]): Boolean = FB.equal(bind(point(a))(f), f(a))

/**

* As with semigroups, monadic effects only change when their

* order is changed, not when the order in which they're

* combined changes.

*/

def associativeBind[A, B, C](fa: F[A], f: A => F[B], g: B => F[C])(implicit FC: Equal[F[C]]): Boolean =

FC.equal(bind(bind(fa)(f))(g), bind(fa)((a: A) => bind(f(a))(g)))

}

以下が Option がモナド則に従うかを検証する方法だ。 4日目の build.sbt を用いて sbt test:console を実行する:

scala> monad.laws[Option].check

+ monad.applicative.functor.identity: OK, passed 100 tests.

+ monad.applicative.functor.associative: OK, passed 100 tests.

+ monad.applicative.identity: OK, passed 100 tests.

+ monad.applicative.composition: OK, passed 100 tests.

+ monad.applicative.homomorphism: OK, passed 100 tests.

+ monad.applicative.interchange: OK, passed 100 tests.

+ monad.right identity: OK, passed 100 tests.

+ monad.left identity: OK, passed 100 tests.

+ monad.associativity: OK, passed 100 tests.

Option よくできました。続きはここから。

6日目

昨日は、flatMap を導入する Monad 型クラスをみた。また、モナディックなチェインが値にコンテキストを与えることも確認した。Option も List も標準ライブラリに flatMap があるから、新しいコードというよりは今まであったものに対して視点を変えて見るという感じになった。あと、モナディックな演算をチェインする方法としての for 構文も確認した。

for 構文、再び

Haskell の do 記法と Scala の for 構文には微妙な違いがある。以下が do 表記の例:

foo = do

x <- Just 3

y <- Just "!"

Just (show x ++ y)

通常は return (show x ++ y) と書くと思うけど、最後の行がモナディックな値であることを強調するために Just を書き出した。一方 Scala はこうだ:

scala> def foo = for {

x <- 3.some

y <- "!".some

} yield x.shows + y

ほぼ同じに見えるけど、Scala の x.shows + y は素の String で、yield が強制的にその値をコンテキストに入れている。これは生の値があればうまくいく。だけど、モナディックな値を返す関数があった場合はどうすればいいだろう?

in3 start = do

first <- moveKnight start

second <- moveKnight first

moveKnight second

これは Scala では moveKnight second の値を抽出して yield で再包装せずには書くことができない。

def in3: List[KnightPos] = for {

first <- move

second <- first.move

third <- second.move

} yield third

この違いにより問題が生じることは実際には無いかもしれないけど、一応覚えておいたほうがいいと思う。

Writer? 中の人なんていません!

Maybeモナドが失敗の可能性という文脈付きの値を表し、リストモナドが非決定性が付いた値を表しているのに対し、Writerモナドは、もう1つの値がくっついた値を表し、付加された値はログのように振る舞います。

本に従って applyLog 関数を実装してみよう:

scala> def isBigGang(x: Int): (Boolean, String) =

(x > 9, "Compared gang size to 9.")

isBigGang: (x: Int)(Boolean, String)

scala> implicit class PairOps[A](pair: (A, String)) {

def applyLog[B](f: A => (B, String)): (B, String) = {

val (x, log) = pair

val (y, newlog) = f(x)

(y, log ++ newlog)

}

}

defined class PairOps

scala> (3, "Smallish gang.") applyLog isBigGang

res30: (Boolean, String) = (false,Smallish gang.Compared gang size to 9.)

メソッドの注入が implicit のユースケースとしては多いため、Scala 2.10 に implicit class という糖衣構文が登場して、クラスから強化クラスに昇進させるのが簡単になった。ログを Monoid として一般化する:

scala> implicit class PairOps[A, B: Monoid](pair: (A, B)) {

def applyLog[C](f: A => (C, B)): (C, B) = {

val (x, log) = pair

val (y, newlog) = f(x)

(y, log |+| newlog)

}

}

defined class PairOps

scala> (3, "Smallish gang.") applyLog isBigGang

res31: (Boolean, String) = (false,Smallish gang.Compared gang size to 9.)

Writer

LYAHFGG:

値にモノイドのおまけを付けるには、タプルに入れるだけです。

Writer w a型の実体は、そんなタプルのnewtypeラッパーにすぎず、定義はとてもシンプルです。

Scalaz でこれに対応するのは Writer だ:

type Writer[+W, +A] = WriterT[Id, W, A]

Writer[+W, +A] は、WriterT[Id, W, A] の型エイリアスだ。

WriterT

以下が WriterT を単純化したものだ:

sealed trait WriterT[F[+_], +W, +A] { self =>

val run: F[(W, A)]

def written(implicit F: Functor[F]): F[W] =

F.map(run)(_._1)

def value(implicit F: Functor[F]): F[A] =

F.map(run)(_._2)

}

Writer が実際にどうやって作られるのかは直ぐには分からなかったけど、見つけることができた:

scala> 3.set("Smallish gang.")

res46: scalaz.Writer[String,Int] = scalaz.WriterTFunctions$$anon$26@477a0c05

import Scalaz._ によって全てのデータ型に対して以下の演算子が導入される:

trait ToDataOps extends ToIdOps with ToTreeOps with ToWriterOps with ToValidationOps with ToReducerOps with ToKleisliOps

件の演算子は WriterOps の一部だ:

final class WriterOps[A](self: A) {

def set[W](w: W): Writer[W, A] = WriterT.writer(w -> self)

def tell: Writer[A, Unit] = WriterT.tell(self)

}

上のメソッドは全ての型に注入されるため、以下のように Writer を作ることができる:

scala> 3.set("something")

res57: scalaz.Writer[String,Int] = scalaz.WriterTFunctions$$anon$26@159663c3

scala> "something".tell

res58: scalaz.Writer[String,Unit] = scalaz.WriterTFunctions$$anon$26@374de9cf

return 3 :: Writer String Int のように単位元が欲しい場合はどうすればいいだろう? Monad[F[_]] は型パラメータが 1つの型コンストラクタを期待するけど、Writer[+W, +A] は 2つある。Scalaz にある MonadTell というヘルパー型を使うと簡単にモナドが得られる (以前は MonadWriter という名前だった):

scala> MonadTell[Writer, String]

res62: scalaz.MonadTell[scalaz.Writer,String] = scalaz.WriterTInstances$$anon$1@6b8501fa

scala> MonadTell[Writer, String].point(3).run

res64: (String, Int) = ("",3)

Writer に for 構文を使う

LYAHFGG:

こうして

Monadインスタンスができたので、Writerをdo記法で自由に扱えます。

例題を Scala で実装してみよう:

scala> def logNumber(x: Int): Writer[List[String], Int] =

x.set(List("Got number: " + x.shows))

logNumber: (x: Int)scalaz.Writer[List[String],Int]

scala> def multWithLog: Writer[List[String], Int] = for {

a <- logNumber(3)

b <- logNumber(5)

} yield a * b

multWithLog: scalaz.Writer[List[String],Int]

scala> multWithLog.run

res67: (List[String], Int) = (List(Got number: 3, Got number: 5),15)

プログラムにログを追加する

以下が例題の gcd だ:

scala> :paste

// Entering paste mode (ctrl-D to finish)

def gcd(a: Int, b: Int): Writer[List[String], Int] =

if (b == 0) for {

_ <- List("Finished with " + a.shows).tell

} yield a

else

List(a.shows + " mod " + b.shows + " = " + (a % b).shows).tell >>= { _ =>

gcd(b, a % b)

}

// Exiting paste mode, now interpreting.

gcd: (a: Int, b: Int)scalaz.Writer[List[String],Int]

scala> gcd(8, 3).run

res71: (List[String], Int) = (List(8 mod 3 = 2, 3 mod 2 = 1, 2 mod 1 = 0, Finished with 1),1)

非効率な List の構築

LYAHFGG:

Writerモナドを使うときは、使うモナドに気をつけてください。リストを使うととても遅くなる場合があるからです。リストはmappendに++を使っていますが、++を使ってリストの最後にものを追加する操作は、そのリストがとても長いと遅くなってしまいます。

主なコレクションの性能特性をまとめた表があるので見てみよう。不変コレクションで目立っているのが全ての演算を実質定数でこなす Vector だ。Vector は分岐度が 32 の木構造で、構造共有を行うことで高速な更新を実現している。

scala> Monoid[Vector[String]]

res73: scalaz.Monoid[Vector[String]] = scalaz.std.IndexedSeqSubInstances$$anon$4@6f82f06f

Vector を使った gcd:

scala> :paste

// Entering paste mode (ctrl-D to finish)

def gcd(a: Int, b: Int): Writer[Vector[String], Int] =

if (b == 0) for {

_ <- Vector("Finished with " + a.shows).tell

} yield a

else for {

result <- gcd(b, a % b)

_ <- Vector(a.shows + " mod " + b.shows + " = " + (a % b).shows).tell

} yield result

// Exiting paste mode, now interpreting.

gcd: (a: Int, b: Int)scalaz.Writer[Vector[String],Int]

scala> gcd(8, 3).run

res74: (Vector[String], Int) = (Vector(Finished with 1, 2 mod 1 = 0, 3 mod 2 = 1, 8 mod 3 = 2),1)

性能の比較

本のように性能を比較するマイクロベンチマークを書いてみよう:

def vectorFinalCountDown(x: Int): Writer[Vector[String], Unit] = {

import annotation.tailrec

@tailrec def doFinalCountDown(x: Int, w: Writer[Vector[String], Unit]): Writer[Vector[String], Unit] = x match {

case 0 => w >>= { _ => Vector("0").tell }

case x => doFinalCountDown(x - 1, w >>= { _ =>

Vector(x.shows).tell

})

}

val t0 = System.currentTimeMillis

val r = doFinalCountDown(x, Vector[String]().tell)

val t1 = System.currentTimeMillis

r >>= { _ => Vector((t1 - t0).shows + " msec").tell }

}

def listFinalCountDown(x: Int): Writer[List[String], Unit] = {

import annotation.tailrec

@tailrec def doFinalCountDown(x: Int, w: Writer[List[String], Unit]): Writer[List[String], Unit] = x match {

case 0 => w >>= { _ => List("0").tell }

case x => doFinalCountDown(x - 1, w >>= { _ =>

List(x.shows).tell

})

}

val t0 = System.currentTimeMillis

val r = doFinalCountDown(x, List[String]().tell)

val t1 = System.currentTimeMillis

r >>= { _ => List((t1 - t0).shows + " msec").tell }

}

以下のように実行できる:

scala> vectorFinalCountDown(10000).run